fronta

| 1. 1. - 31. 12. 2013 |

Celkem | @arien | @wagap |

| Počet úloh |

1 938 156 |

1 646 839 |

291 317 |

| Propočítaný CPU čas |

4398 CPU let |

2217 CPU let |

2181 CPU let |

| Počet uživatelů k 31. 12. 2013 | 761 | ||

| Počet uživatelů, kteří spustili aspoň jednu úlohu | 350 | ||

| Počet CPU k 31. 12. 2013 | 9020 |

4508 |

4512 |

| Využití diskových polí | obsazeno 517 TB z celkových 1,1 PB | ||

| Publikace z roku 2013 vykázané k 31. 12. 2013 | 75 | ||

Celkový počet aktivních uživatelů v MetaVO na konci roku 2013 je 761, z toho prodloužených účtů z předchozího roku 368 a získali jsme 393 nových uživatelů. Pro srovnání, v předchozím roce 2012 mělo na konci roku v MetaVO účet 636 uživatelů, z toho bylo 301 prodloužených a 335 nových účtů. Ze srovnání je patrné, že zájem o MetaCentrum stále roste, největší nápor nově příchozích je vždy ve druhém pololetí roku, kdy se hlásí nově příchozí studenti.

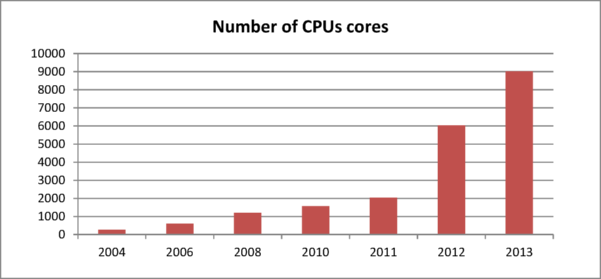

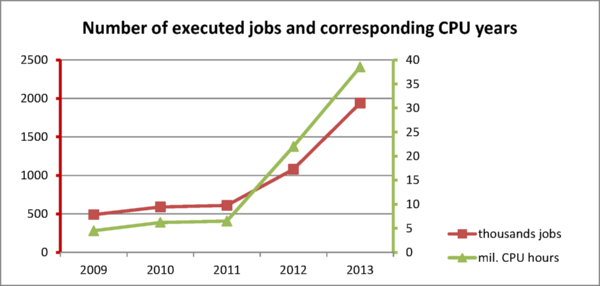

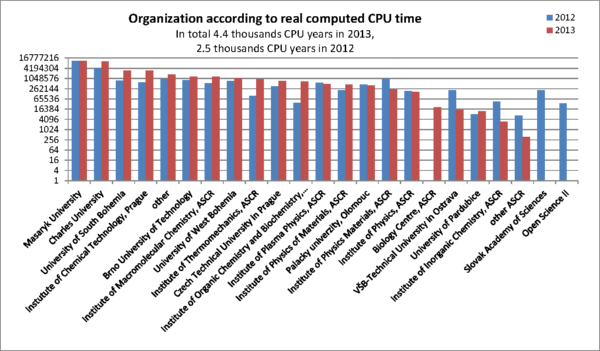

V roce 2013 uživatelé propočítali oproti loňskému roku téměř dvakrát více strojového času, celkem téměř 4,4 tis. CPU let oproti 2,5 tis. CPU let za stejné období předchozího roku. Vzrostl rovněž počet spuštěných úloh oproti loňskému roku, z 1,1 mil. v roce 2012 na 1,9 mil. spuštěných úloh ve stejném období 2013. Tak výrazný nárůst propočítaného CPU času je důsledkem významného rozšíření výpočetní kapacity z OP VaVpI prostředků Cesnetího projektu eIgeR a univerzitního projektu CERIT-SC (ÚVT MU). Meziročně vzrostl počet CPU o téměř 3000 CPU na celkový počet 9020 CPU jader (vloni 6124). Velká část nových zdrojů byla zprovozněna až v průběhu roku, takže cekový propočítaný čas neodpovídá počtu propočítaných CPU let. Část zdrojů je navíc zapojena v cloudu, a z technických důvodů se pro ně nesbírají údaje o propočítaných úlohách, nebo je vyhrazena pouze vlastníkům a celkové využití je pak výrazně nižší.

Mezi největší vlastníky patří:

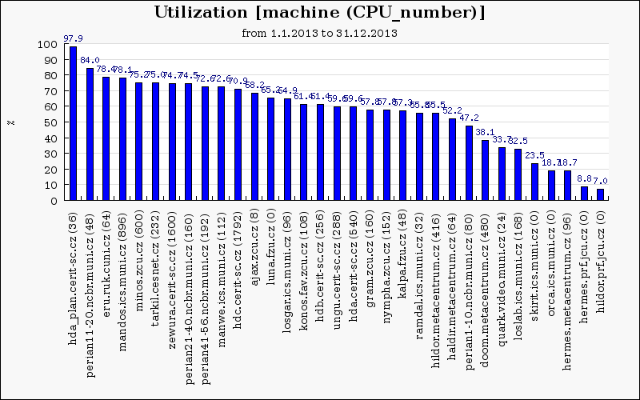

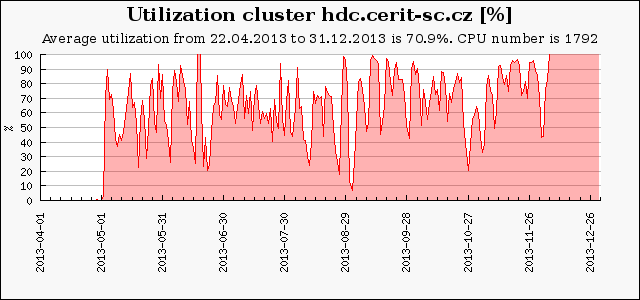

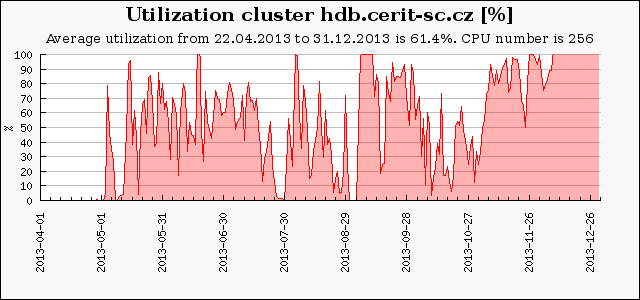

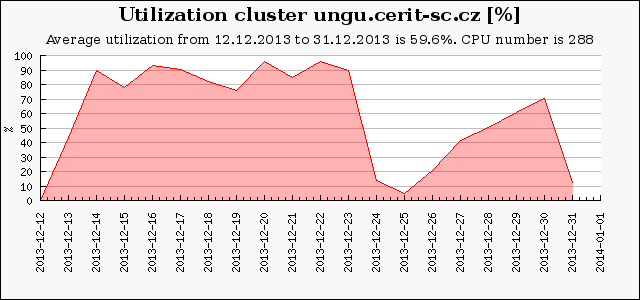

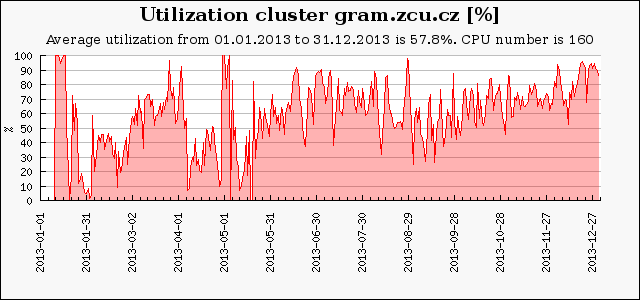

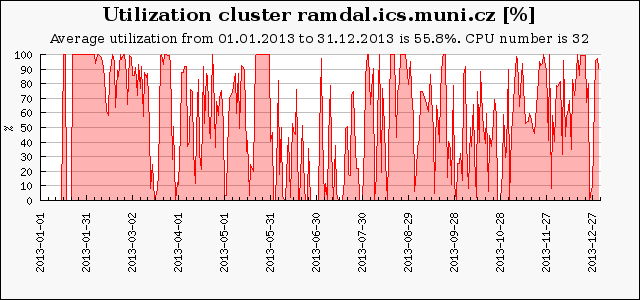

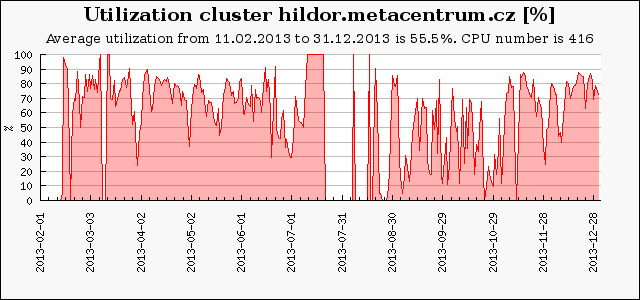

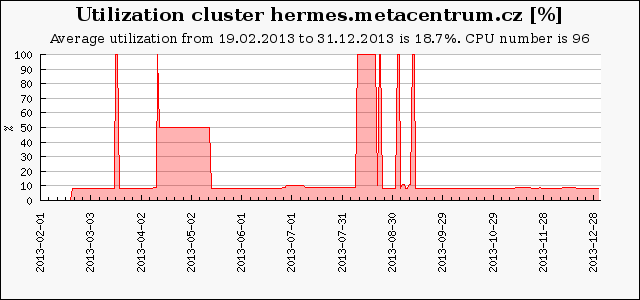

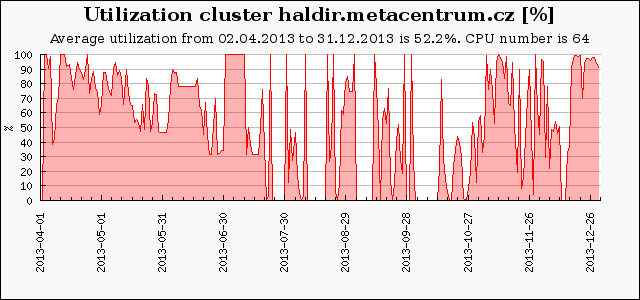

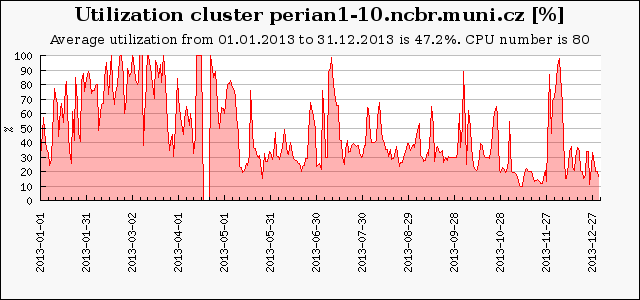

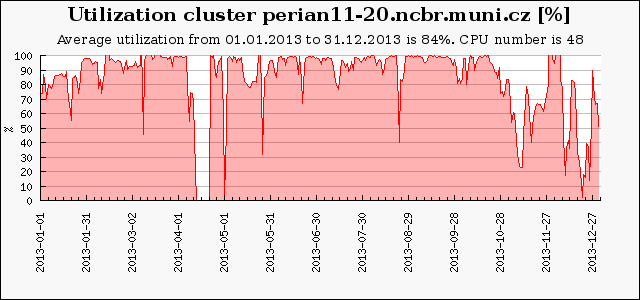

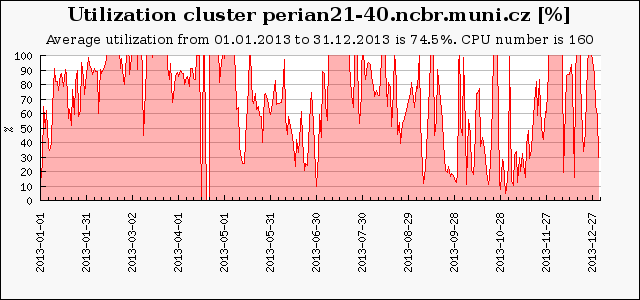

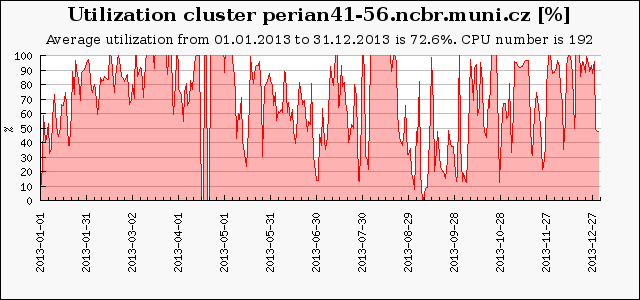

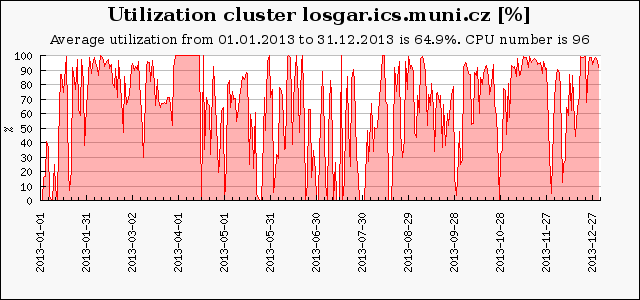

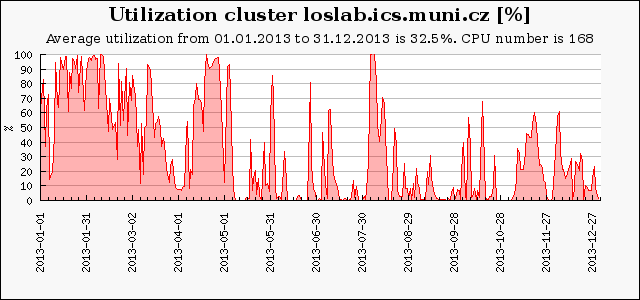

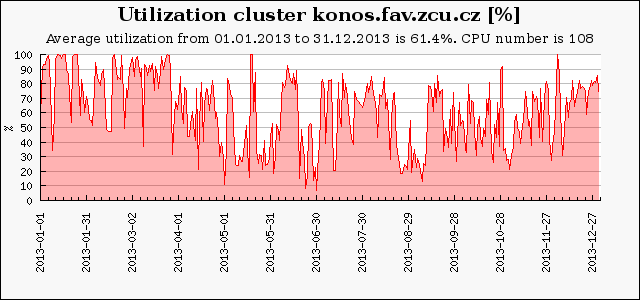

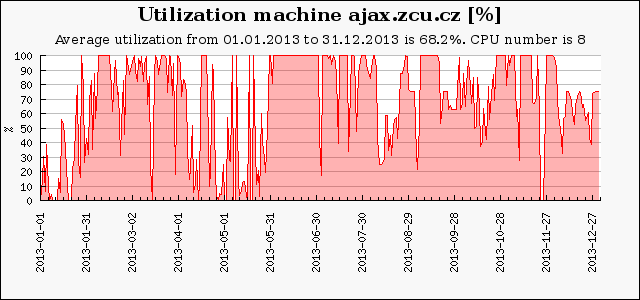

Následující graf ukazuje průměrné vytížení výpočetních clusterů a strojů v roce 2013. U některých zdrojů není započítaná část výpočetní kapacity, která byla přístupná experimentálním cloudovým rozhraním, ze kterého nemáme posbírána korektní provozní data. Základem pro výpočet průměrného vytížení (100%) je celkový počet dostupných CPU-core-seconds mínus počet CPU-core-seconds strojů, které nebyly v provozu. Rezervované stroje jsou započítané tak, jako by byly plně využity, bez ohledu na jejich skutečné využití. Údaj v závorce udává počet CPU v clusteru na konci roku. Nula značí, že cluster byl v průběhu roku vyřazen.

Průměrné vytížení volně dostupných strojů v MetaCentru se pohybovalo mezi 50 a 90 %. Vytížení okolo 70% je optimální, vyšší vytížení již znamená faktickou saturaci a způsobuje delší doby čekání úloh ve frontě. Nižší hodnoty vytížení vykazují stroje, které byly do MetaCentra zapojeny až v průběhu sledovaného období nebo jsou vyhrazené pro některou skupinu.

Nové clustery centra CERIT-SC (zigur, zapat) jsou díky virtualizaci do gridu připojeny přes cloudové rozhraní a jen část je určena pro výpočty přes plánovací systém, větší část je využitelná v cloudovém prostředí. U těchto zdrojů není započítaná část výpočetní kapacity, která byla přístupná experimentálním cloudovým rozhraním, ze kterého nemáme posbírána korektní provozní data. Jejich vytížení je proto výrazně pod průměrem MetaVO.

Cluster zapat.cerit-sc.cz (hdc.cerit-sc.cz) je nový přírůstek do rodiny clusterů patřících CERIT-SC. Skládá se ze 112 uzlů, každý obsahuje 16 CPU a 128 GB paměti. Je aktuálně největším clusterem v MetaCentru, jeho počet procesorů je 1792.

Cluster zigur.cerit-sc.cz (hdb.cerit-sc.cz) je je složen s 32 uzlů po 2x4 CPU, každý uzel má 128 GB paměti. Je osazen rychlými procesory, výkon každého uzlu naměřený během akceptačních testů je 327 bodů benchmarku SPECfp2006 base rate, tj. 41 na jádro (zapat má 29 bodů na jádro).

Unikátní NUMA server SGI UV2 (288 CPU jader, 6 TB paměti) byl uveden do provozu až v prosinci 2013. Je určen pro speciální typy vysoce paralelních úloh, které vyžadují mnoho paměti.

GPU cluster gram.zcu.cz má 10 uzlů po 16 CPU celkem tedy 160 CPU. Každý z uzlů je vybaven GPU kartou 4x nVidia Tesla M2090 6GB. Pro výpočetní využití karty je nutné využít nové fronty "gpu" a "gpu_long", které jsou přístupné všem uživatelům MetaCentra. V obou frontách se za dané období spustilo více než 9 000 úloh s celkovým časem přes 100 000 CPU hodin.

Nový stroj ramdal.ics.muni.cz slouží pro úlohy náročné na paměť, má 32 procesorů s Hyperthreadingem, velikost jeho paměti je 1 TB. Je ve zvláštním režimu, kdy pro přístup ke stroji je potřeba kontaktovat Metacentrum se zdůvodněním.

Cluster Hildor je umístěn na sále JU v Českých Budějovicích, obsahuje 26 uzlů po 16 CPU a pamětí 64 GB.

GPU Cluster Doom umístěný NA VŠB-TUO v Ostravě. Každý z 30 uzlů obsahuje dvě karty nVidia Tesla K20 5GB (Kepler).

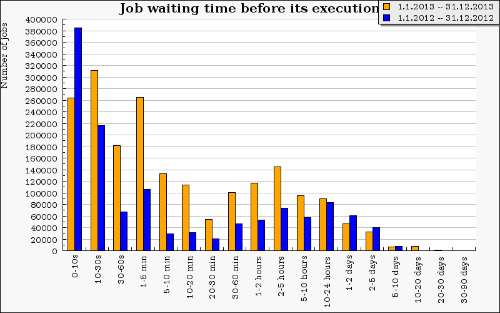

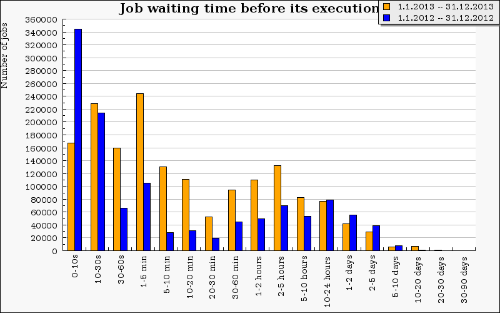

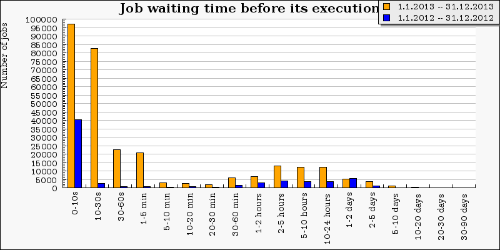

Celková doba čekání úloh se zvětšila kvůli nárůstu počtu úloh. Největší nárůst pozorujeme v čekání v rámci sekund až jednotek minut, naopak snížení můžeme pozorovat v čekání v řádu desítek hodin a jednotek dní. Díky novým strojům se již nestává tak často, že by úloha čekala na spuštění několik dní. Často se ale jedná o úlohy nesprávně zadané, kdy požadovaná kombinacevlastností buď neexistuje nebo je dlouhodobě nedostupná.

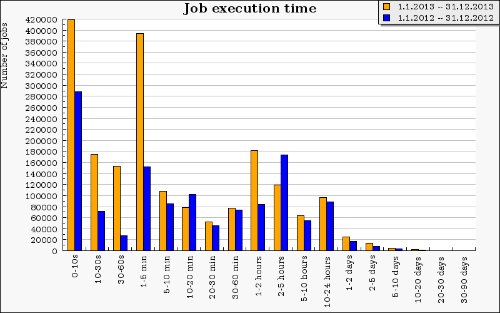

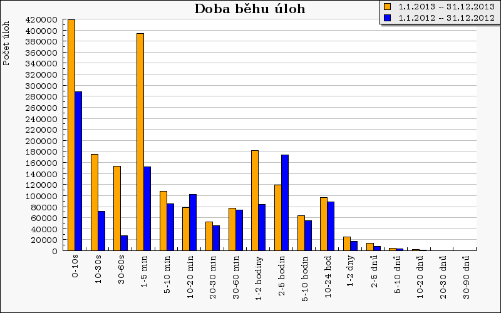

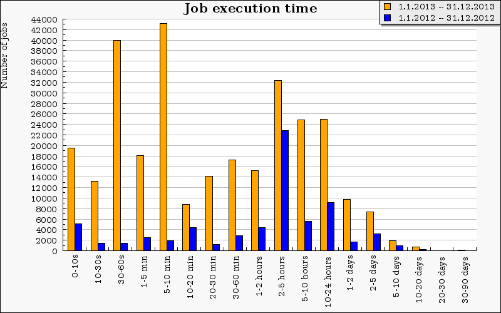

Doba běhu úloh je naopak téměř stejná nebo vyšší bež v předcházejícím roce. Výrazně narostl počet úloh běžících několik vteřin. Více než 400 tisíc z nich jsou servisní úlohy, které nám pomáhají monitorovat dostupnost strojů. Poměrně výrazně přibylo úloh s délkou běhu do 5 minut a úloh s délkou běhu 1-2 hodiny.

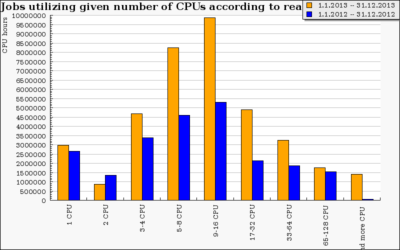

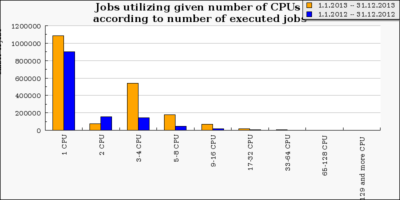

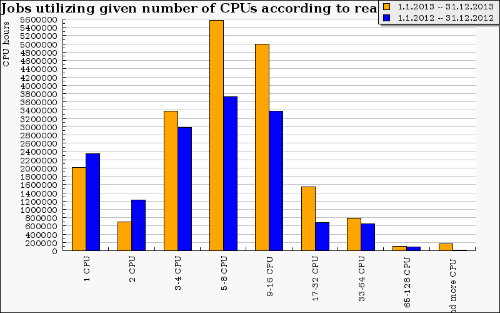

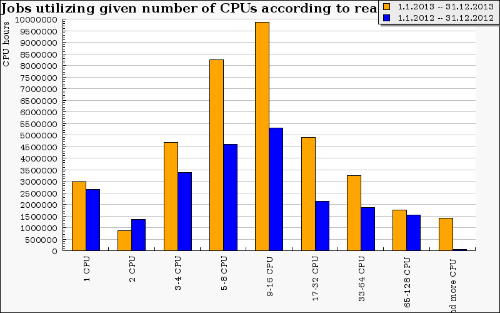

Oproti stejnému období předchozího roku se výrazně zvýšil podíl propočítaného času víceprocesorovými úlohami. Důvodem nárůstu je zprovoznění velkých SMP strojů v druhé polovině roku 2012 a úpravy v plánovači směrem k nastavení strádání úloh. Velké úlohy přes více jader již tak dlouho nečekaly a proto je uživatelé začali více používat. Největšího nárustu zaznamenaly úlohy mezi 4 a 32 CPU a úlohy požadující více než 128 CPU. Podle absolutního počtu úloh stále převažují jednoduché 1 CPU úlohy. Meziričně pak došlo k výraznému nárůstu počtu paralelních úloh do 32 CPU.

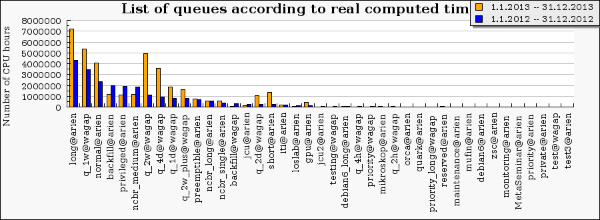

Z následujícího grafu je patrné, že podle propočítaného času jsou oblíbené dlouhé fronty s délkou běhu úloh nad 1 den. Je to logické, většina těchto úloh využila navíc více jader. Nejvíce času se propočítalo ve frontě long, která je určena pro úlohy trvající 1 až 30 dní. Další fronty jsou v rozsahu od 4 dnů do 1 týdne (q_1w) a do 24 hodin (normal). Fronta q_4d je určena pro úlohy trvající od 2 do 4 dní a q_2w pro úlohy trvající 1 až 2 týdny. V obou plánovačích (wagap i arien) přibylo úloh (dle propočítaného času) spíše v dlouhých frontách.

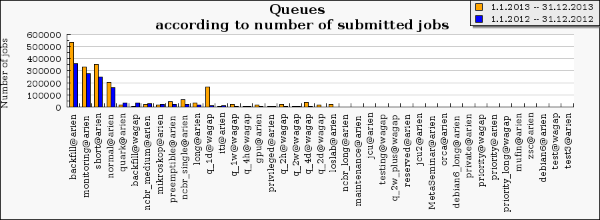

Co do počtu spuštěných úloh je nejfrekventovanější nízkoprioritní fronta backfill, určená k "vyplnění" prázdných strojů. Úlohy v této frontě mohou být v případě potřeby ukončeny, ale může jich být velmi mnoho. Další v pořadí jsou fronty short, normal a interní fronta monitoring pro monitorování stavu strojů. Poměrně oblíbená je i jednodenní fronta v prostředí plánovacího serveru wagap centra CERIT-SC.

Následující grafy jsou vykresleny pro úlohy spuštěné na clusterech MetaCentra, v Torque severu arien. Oproti loňskému roku čekají úlohy na spuštění podstatně kratší dobu, což je dáno pořízením významného množství nových zdrojů. Výrazně meziročně narostl počet úloh s délkou trvání do 5 minut. Delší úlohy a vysoce paralelní úlohy se přestěhovaly spíše na specializované zdroje centra CERIT-SC.

Následující grafy jsou vykresleny pro úlohy spuštěné na clusterech CRIT-SC (zewura, zegox, zapat, zigur). Oproti loňskému roku čekají úlohy na spuštění podstatně kratší dobu, což je dáno pořízením významného množství nových zdrojů. Uživatelé centra CERIT-SC preferují paralelní úlohy s delší dobou běhu. Výrazně meziročně narostl propočítaný čas úloh všech délek a podíl paralelních úloh. Mírně ubylo extrémně dllouhých úloh (nad 1 měsíc). Uživatelům jsme pomáhali optimalizovat takové úlohy tak, aby běžely maximálně do jednohpo měsíce. Při delší době běhu se zvyšuje riziko neočekávaného výpadku stroje a správci mají omezené možnosti při aktualizaci systému.

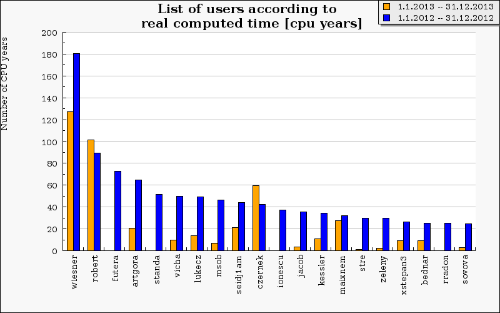

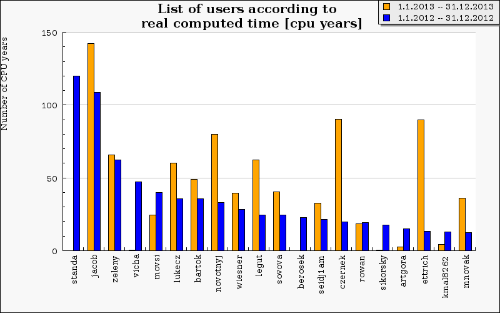

Žebříček největších počtářů (vlevo arien, vpravo wagap) ukazuje, že prvních deset uživatelů propočítalo více než 1000 CPU let na @arien a více než 920 CPU let na @wagap, což představuje u obou Torque serverů téměř polovinu celkového propočítaného času.

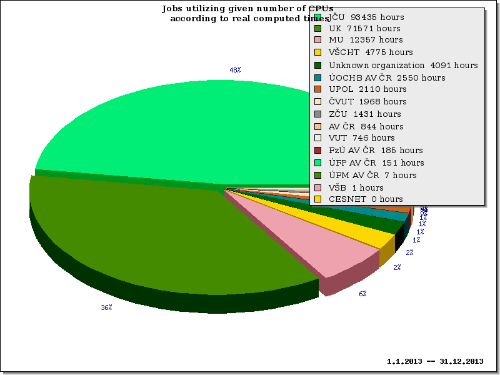

Masarykova univerzita propočítala celkem přes 5 milionů CPU hodin což tvoří celou jednu třeti celkového propočítaného času, Univerzita Karlova propočítala téměř 4 miliony CPU hodin.

Celkově se v MetaCentru za první pololetí 2013 objevuje 24 organizací, především univerzit nebo jejich kateder a 14 ústavů akademie věd ČR. Můžeme sledovat nárůst propočítané doby téměř u všech dostupných organizací. Graf zahrnuje organizace, co propočítaly nejvíc CPU hodin. Měřítko grafu je logaritmické.

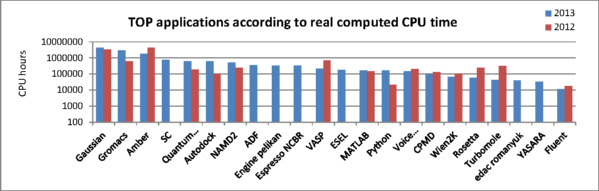

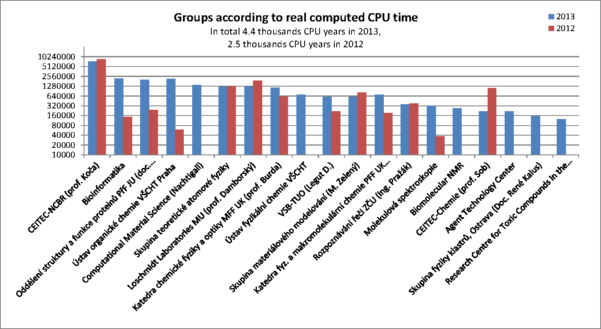

V MetaCentru je pod každou organizací řada skupin, v souhrnu téměř 80. V grafu jsou zachyceny ty nejaktivnější z nich a porovnání propočítaného času za letošní a loňský rok. Měřítko grafu na ose Y je opět logaritmické. U většiny skupin jsme zaznamenali významný nárůst aktivity, některé skupiny jsou úplně nové.

V roce 2013 bylo v MetaCentru nainstalováno nebo aktualizováno několik set aplikačních modulů. Veškeré změny v modulech jsou hlášeny na wiki a významnější SW rovněž fromou novinek.

Zde je přehled těch s největším propočítaným časem.