Celkový počet aktivních uživatelů v MetaVO na konci roku 2014 je 1112, z toho prodloužených účtů z předchozího roku 507 a získali jsme 605 nových uživatelů. Pro srovnání, koncem roku 2013 mělo v MetaVO účet 761 uživatelů, z toho bylo 368 prodloužených a 393 nových účtů. Ze srovnání je patrné, že zájem o MetaCentrum stále roste, největší nápor nově příchozích bývá ve druhém pololetí roku, kdy se hlásí nově příchozí studenti.

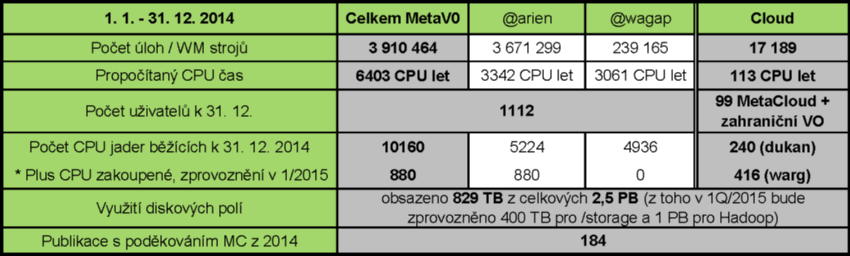

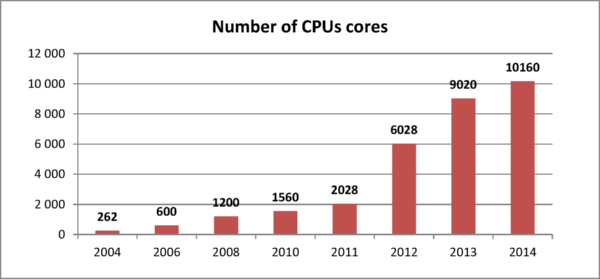

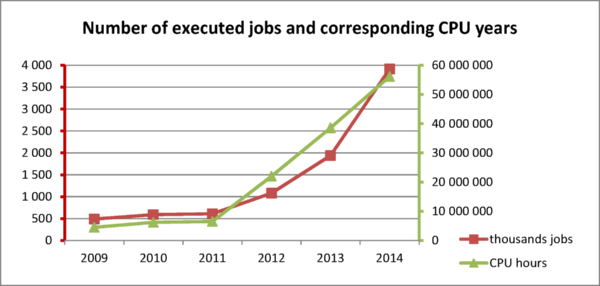

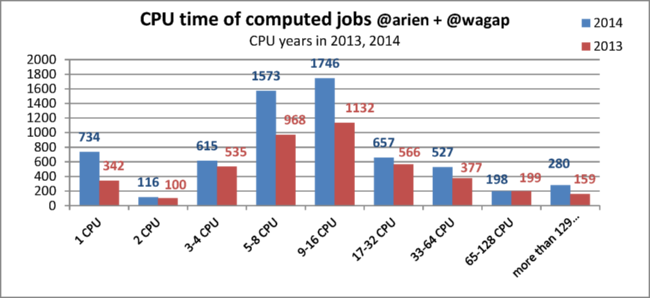

V roce 2014 uživatelé propočítali oproti loňskému roku v dávkovém systému téměř dvakrát více strojového času, celkem více než 6,4 tis. CPU let oproti 4,4 tis. CPU let za stejné období předchozího roku. Vzrostl rovněž počet spuštěných úloh oproti loňskému roku, z 1,9 mil. v roce 2013 na 3,9 mil. spuštěných úloh ve stejném období 2014. Tak výrazný nárůst propočítaného CPU času je důsledkem dalšího rozšíření výpočetní kapacity z OP VaVpI prostředků CESNETího projektu eIGeR a univerzitního projektu CERIT-SC (ÚVT MU). Meziročně vzrostl počet CPU o více než 1,1 tisíc CPU jader na celkový počet 10160 CPU jader (vloni 9020). Velká část nových zdrojů byla zprovozněna až ke konci roku, takže cekový propočítaný čas neodpovídá počtu propočítaných teoreticky propočítatelných CPU let. Část zdrojů je navíc zapojena v cloudu, accountingová data se sbírají zvlášť a nejsou zahrnuta v těchto číslech, nebo je vyhrazena pouze vlastníkům a celkové využití je pak výrazně nižší.

Mezi největší vlastníky patří:

MetaVO včetně cloudu a hadoop (včetně nově nakoupených a nezprovozněných strojů k 31.12. 2014)

Elixir VO

EGI

Následující statistiky pokrývají pouze běžící stroje a clustery zapojené ve VO MetaVO a ELIXIR VO (k 31.12.2014). Stroje zapojedné do mezinárodního prostředí EGI využívají jiné virtuální organizace a v této statistice nejsou zahrnuty. Je možné si jej prohlédnou v aplikaci EGI Accounting Portal (některé informace v databázi vyžadují účet v EGI). K dispozici je rovněž statistika využití projektem Belle II.

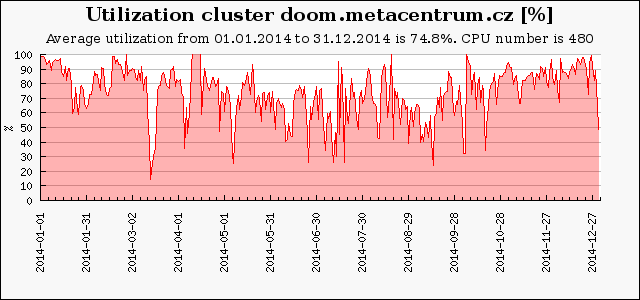

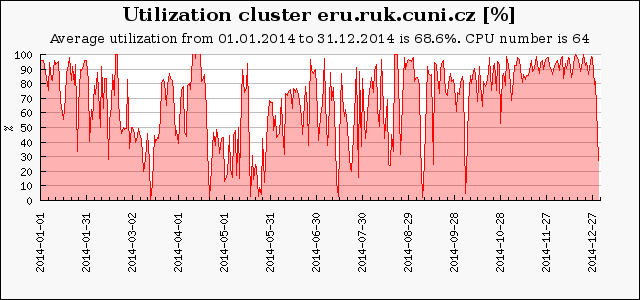

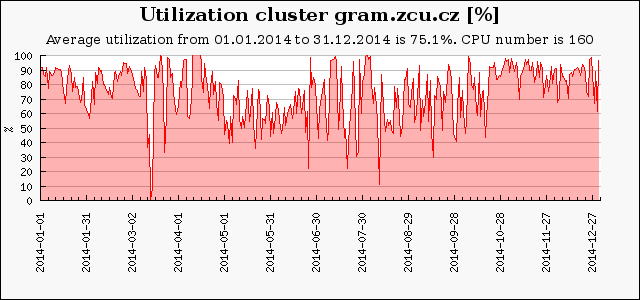

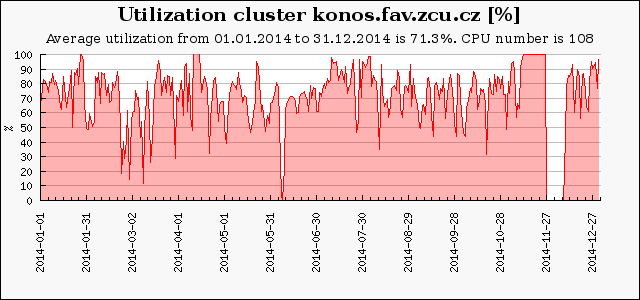

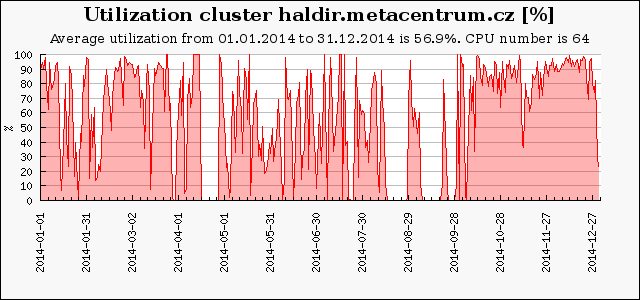

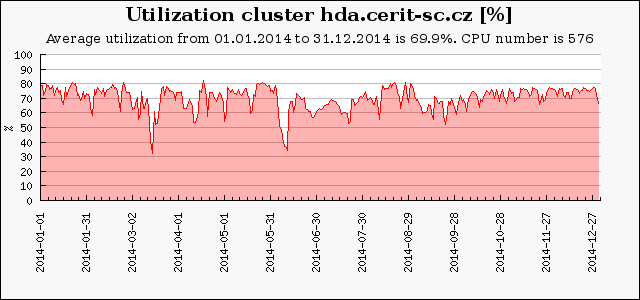

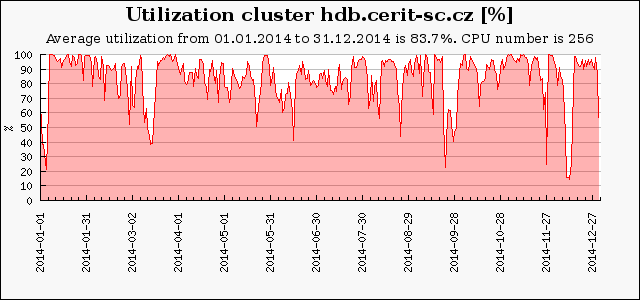

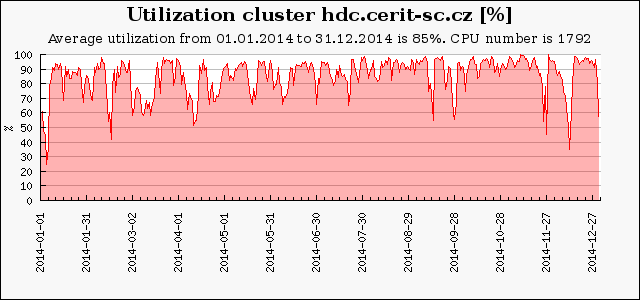

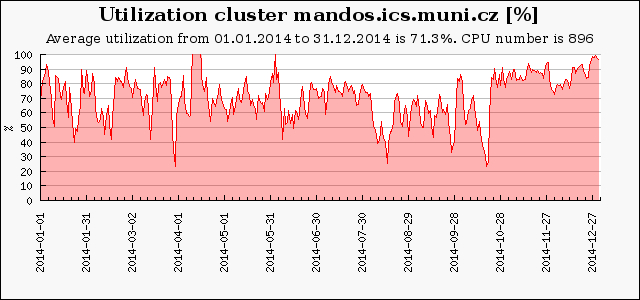

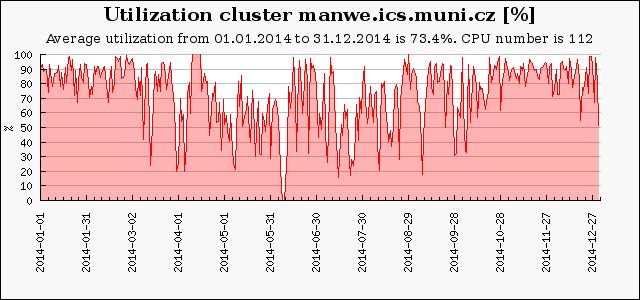

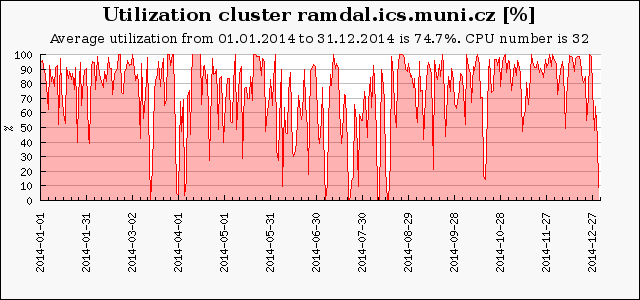

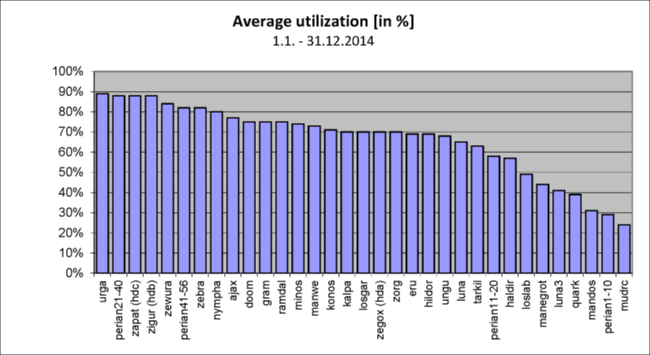

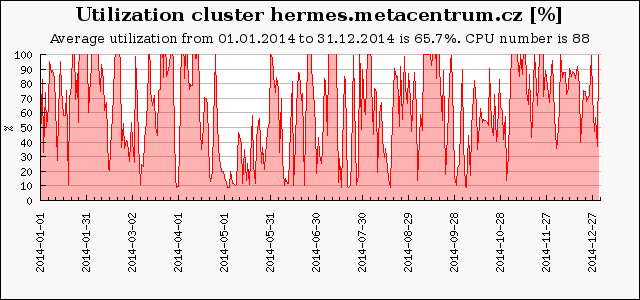

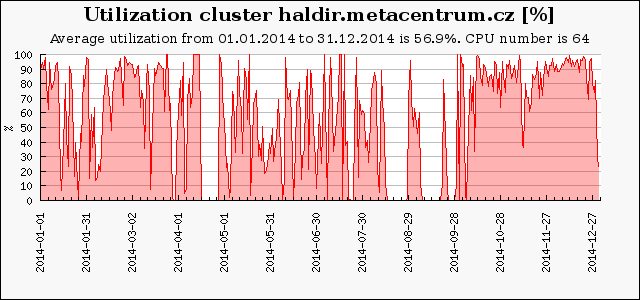

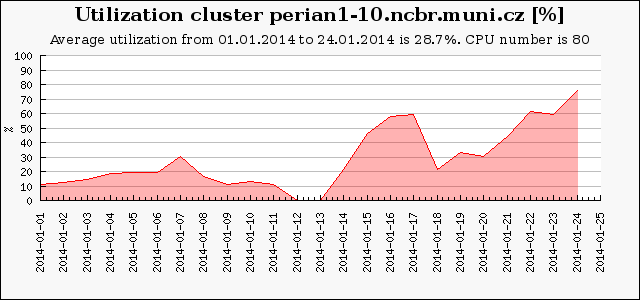

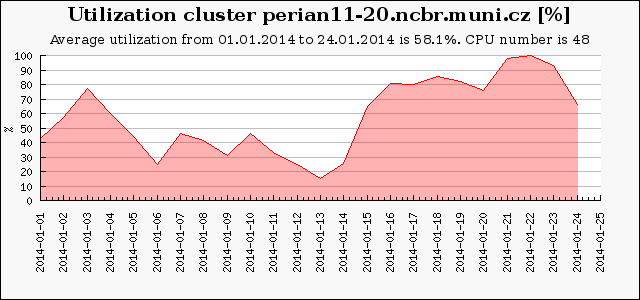

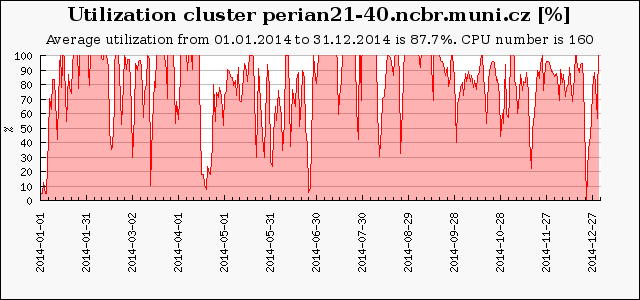

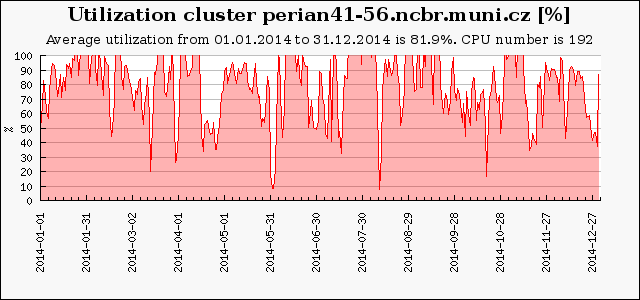

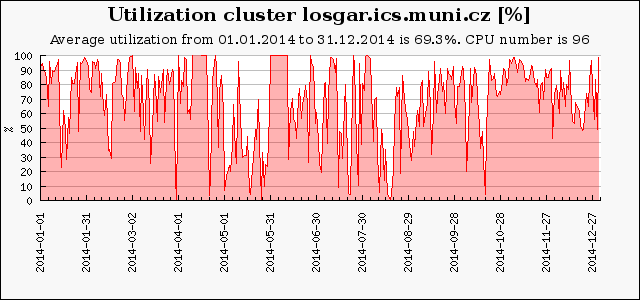

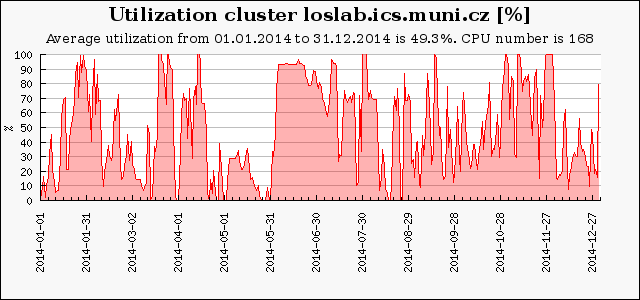

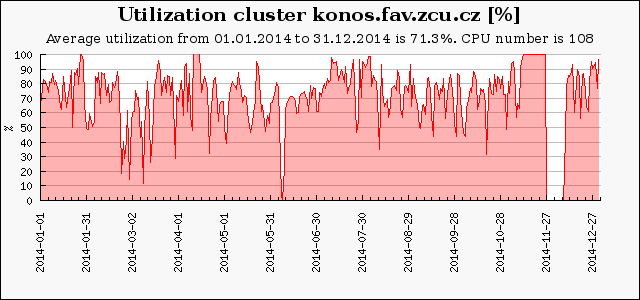

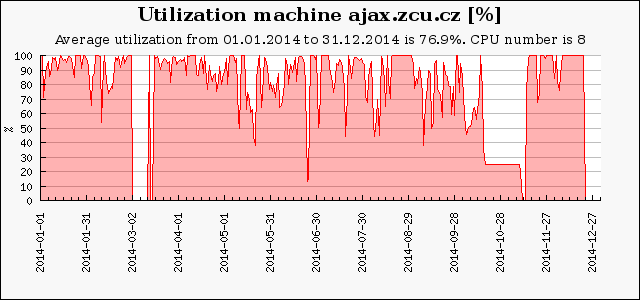

Následující graf ukazuje průměrné vytížení výpočetních clusterů a strojů v MetaVO v roce 2013. U některých zdrojů není započítaná část výpočetní kapacity, která byla přístupná experimentálním cloudovým rozhraním, ze kterého nemáme posbírána korektní provozní data. Základem pro výpočet průměrného vytížení (100%) je celkový počet dostupných CPU-core-seconds mínus počet CPU-core-seconds strojů, které nebyly v provozu. Rezervované stroje jsou započítané tak, jako by byly plně využity, bez ohledu na jejich skutečné využití. Údaj v závorce udává počet CPU v clusteru na konci roku. Nula značí, že cluster byl v průběhu roku vyřazen.

Průměrné vytížení volně dostupných strojů v MetaCentru se pohybovalo mezi 60 a 90 %. Vytížení okolo 70% je optimální, vyšší vytížení již znamená faktickou saturaci a způsobuje delší doby čekání úloh ve frontě. Nižší hodnoty vytížení vykazují stroje, které byly do MetaCentra zapojeny až v průběhu sledovaného období nebo jsou vyhrazené pro některou skupinu. Oproti loňskému roku se vytížení strojů zvýšilo jednak díky vyššímu zájmu uživatelů a výraznému nárůstu propočítaného času a také v důsledku nasazení rozvrhového plánovače na Torque serveru @wagap a otimalizace plánovače (spouštění výplňových úloh) pro Torque server @arien.

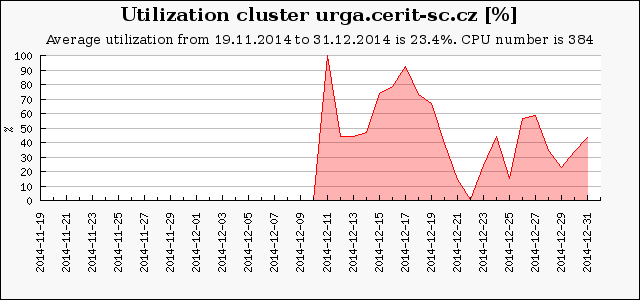

Stroj urga.cerit-sc.cz, v pořadí druhý NUMA server SGI UV2 (384 CPU jader, 6 TB paměti), byl pořízen ve spolupráci s FI MU a uveden do provozu v listopadu 2014. Je určen pro speciální typy vysoce paralelních úloh, které vyžadují mnoho paměti. Byl pořízen pro podporu výuky na Fakultě informatiky Masarykovy univerzity. Výkon každého uzlu naměřený během akceptačních testů je 13198 bodů benchmarku SPECfp2006 base rate (34,37 na jádro).

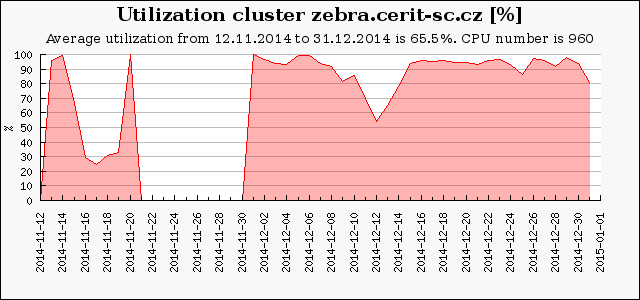

V červnu byla přestěhována část clusteru Zewura9-20 na nový sál CERIT-SC a přejmenován na zebra.cerit-sc.cz (12 uzlů, 960 CPU). Výkon každého uzlu naměřený během akceptačních testů je 1250 (resp. 1220) bodů benchmarku SPECfp2006 base rate, tj. 15.62 (respektive 15.25) na jádro.

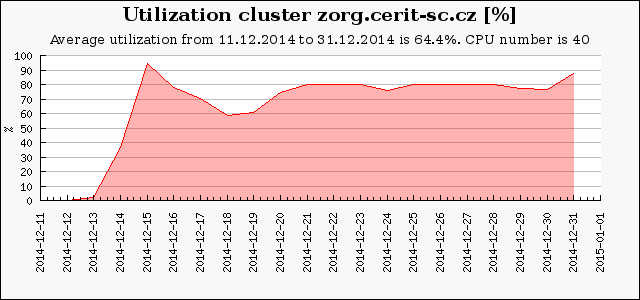

Stroj zorg.cerit-sc.cz s 1.5TB RAM a 4 uzly po 10 CPU jadrech, celkem 40 CPU, byl zprovozněn na konci roku 2014. Výkon každého uzlu naměřený během akceptačních testů je 1400 bodů benchmarku SPECfp2006 base rate 35 na jádro).

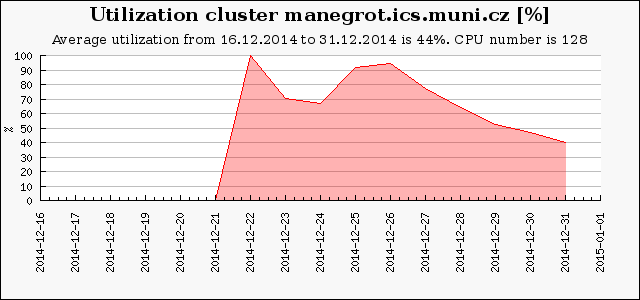

Nový cluster manegrot.ics.muni.cz 4 uzly po 8 CPU jádrech, celkem 32 jader byl zprovozněn v prosinci 2014. Byl přístupný všem uživatelům MetaCentra, kvůli otestování, pouze v krátkých frontách. Proto bylo jeho vytížení poměrně nízké. Výkon každého uzlu naměřený během akceptačních testů je 1100 bodů benchmarku SPECfp2006 base rate, tj. 34,4 na jádro.

V MetaCentru byly v roce 2014 k dispozici 3 clustery s GPU kartami:

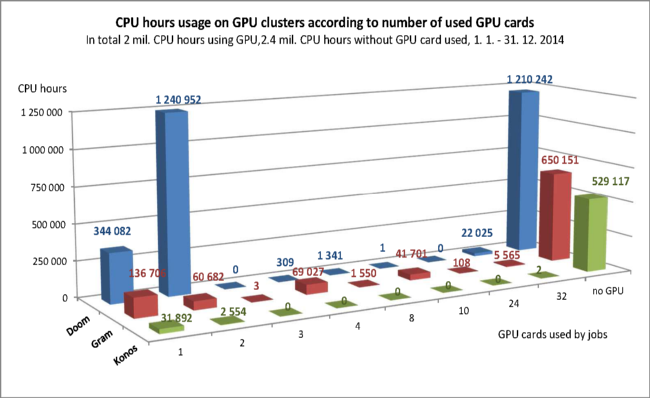

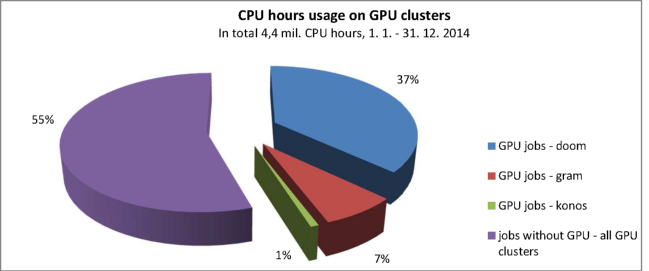

Na těchto GPU clusterech bylo v roce 2014 propočítáno celkem 4,4 mil. CPU hodin, z toho 2 mil. CPU hodin úlohami využívajícími GPU a 2,4 mil. CPU hodin úlohami bez GPU. Nejčastěji úlohy využívaly 1 nebo 2 karty, ale vyskytly se i úlohy požadující více uzlů a až 32 GPU karet. Na clusteru konos bylo propočítáno nejvíce úloh bez GPU, je to dáno tím, že cluster patří skupině ITI, která jej využívala i na běžné typy výpočtů. Druhým důvodem je skutečnost, že se jedná o nejstarší cluster s GPU s velmi starými a tedy méně oblíbenými GPU kartami.

Rozdělení propočítaných CPU hodin na jednotlivých clusterech vystihuje následující graf. Ne-GPU úloh bylo 55 % z celkových 4,4 mil. CPU hodin. Nejvíce propočítaly GPU úlohy na clusteru doom (37 % celkového CPU času propočítaného na GPU strojích) a nejméně na clusteru konos (1 %).

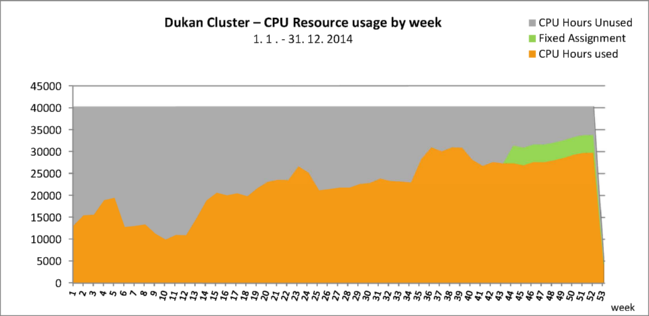

Na cloudových strojích MetaCentra (cluster dukan) byl v roce 2014 zkonzumován bezmála 1 milión CPU hodin. Cluster dukan zahrnuje celkem 240 CPU, 10 uzlů po 4x 6-core Intel Xeon E5649 2.53GHz a 96 GB RAM. Následující graf ukazuje využití cloudových strojů po týdnech, v průběhu roku se postupně zaplnění strojů zvyšovalo z 20 % v lednu až na 90 % ke konci roku.

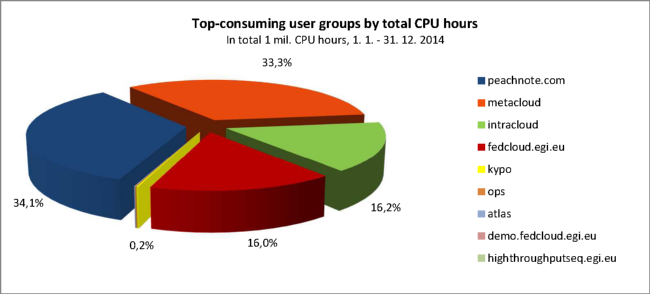

Cloud využívali nejvíce uživatelé z virtuálních organizací Peachnote, MetaCloud, Intracloud a Fedcloud.

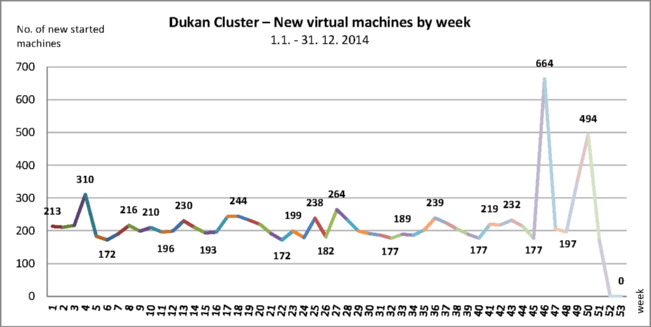

Počty nově spuštěných virtuálních serverů po týdnech ukazuje následující graf. Celkem bylo nastartováno na clusteru dukan 11445 virtuálních strojů, týdně pak průměrně 215.

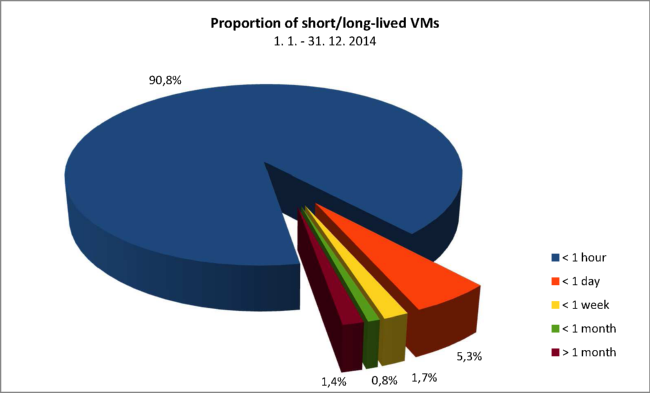

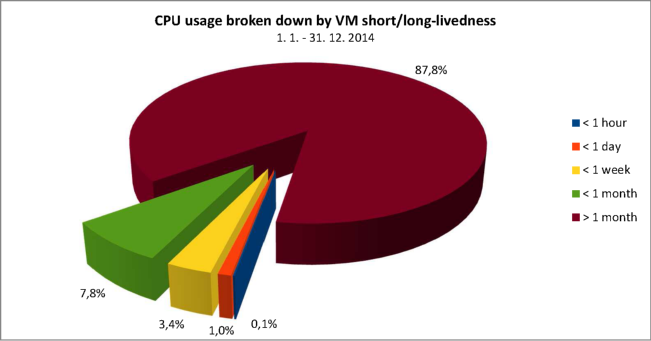

Krátkodobě běžící stroje spotřebovávají jen zlomek cloudové kapacity (CPU), nejvíce spotřebovávají dlouho běžící virtuální stroje. Konkrétně 90,8 % virtuálních strojů bylo spuštěno méně než hodinu, ale spotřebovaly jen 0,1 % zdrojů (CPU). Strojů běžících více než měsíc bylo jen 1,4 %, ale spotřebovaly 87,8 % CPU zdrojů.

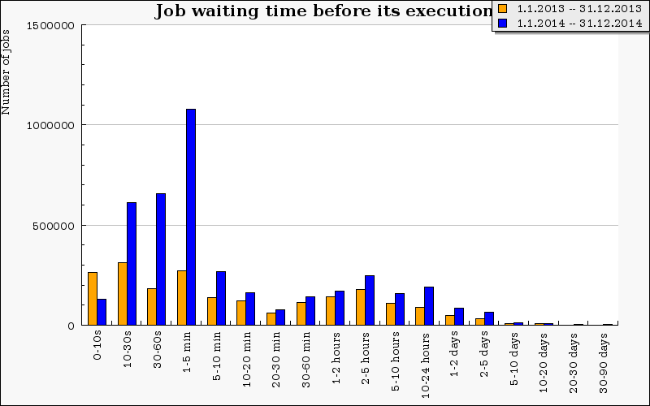

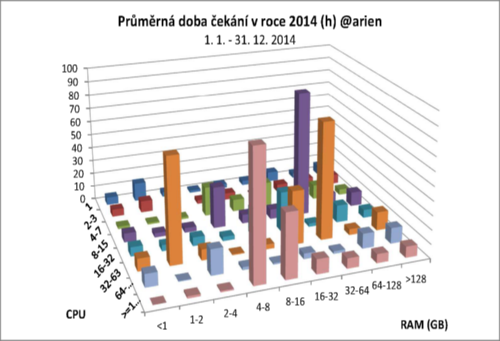

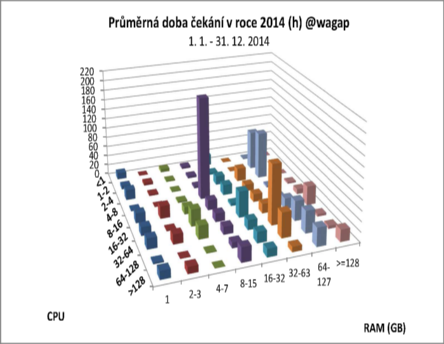

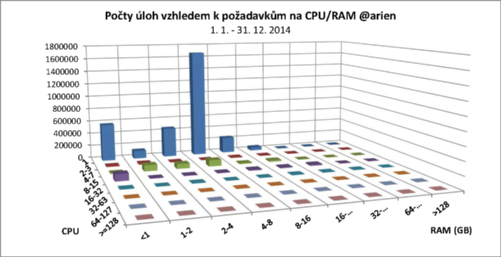

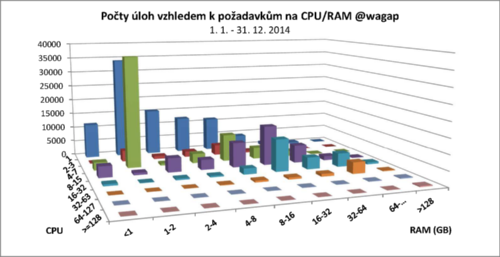

Celková doba čekání úloh se oproti minulému roku zvýšila kvůli výraznému nárůstu počtu úloh. Největší nárůst pozorujeme v čekání v rámci sekund až jednotek minut, naopak stagnaci až mírné snížení můžeme pozorovat v čekání v řádu desítek hodin a jednotek dní. V důsledku vysokého využití strojů, které dosahuje až 90 %, se doba čekání úloh oproti loňskému roku mírně zvýšila. Avšak díky úpravám v plánovači a zavedení rozvrhového plánovače bylo čekání optimalizováno tak, že kratší úlohy čekají méně dlouho a delší úlohy si mohou dovolit čekat déle. Tohle neplatí v případě, kdy do systému natečou tisíce takových úloh jednoho uživatele najednou, a systém spustí obranné mechanismy tak, aby jeden uživatel nevyužil příliš mnoho zdrojů pro sebe a na ostatní by nezbylo. Takové úlohy pak čekají déle. Mezi dlouho čekajícími úlohami se často jedná také o úlohy nesprávně zadané, kdy požadovaná kombinace vlastností buď neexistuje nebo je dlouhodobě nedostupná a ke změně parametrů úlohy dojde až po dnech až týdnech čekání.

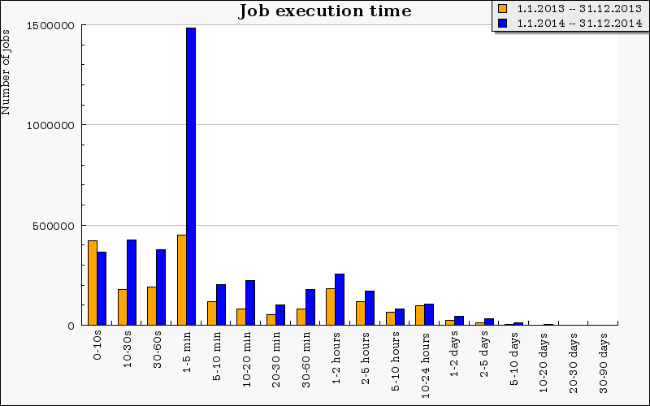

V důsledku nárůstu celkového počtu úloh přibylo úloh všech délek běhu. Nejvýrazněji pak přibylo úloh s délkou běhu do 5 minut, takové úlohy se velmi snadno spouštějí, vyplňují mezery v plánování.

Oproti stejnému období předchozího roku se opět výrazně zvýšil podíl propočítaného času víceprocesorovými úlohami. Důvodem nárůstu je zprovoznění dalších velkých SMP strojů a v druhé polovině roku 2014 dalšího NUMA stroje SGI UV2 a také nasazení nového plánovače. Velké úlohy přes více jader již tak dlouho nečekaly a proto je uživatelé začali více používat. Největšího nárustu zaznamenaly úlohy mezi 4 a 64 CPU a úlohy požadující více než 128 CPU.

V MetaCentru v roce 2014 počítalo 884 uživatelů z téměř 50 organizací, především univerzit nebo výzkumných center a 19 ústavů Akademie věd ČR. Můžeme sledovat nárůst propočítané doby téměř u všech dostupných organizací. Graf zahrnuje organizace, co propočítaly nejvíc CPU hodin. Měřítko grafu je logaritmické.

Dle propočítaného času je na prvním místě Masarykova univerzita, která propočítala celkem přes 11,4 milionů CPU hodin, cca čtvrtinu celkového skutečně propočítaného času, Univerzita Karlova propočítala 11 milonů CPU hodin (20 %), na třetím místě se umístilo České vysoké učení technické v Praze s téměř 8 miliony CPU hodin (9%).

V MetaCentru je pod každou organizací řada skupin, v souhrnu více než 150. V grafu jsou zachyceny ty nejaktivnější z nich a porovnání propočítaného času v CPU letech za letošní a loňský rok. U většiny skupin jsme zaznamenali významný nárůst aktivity, některé skupiny jsou úplně nové.

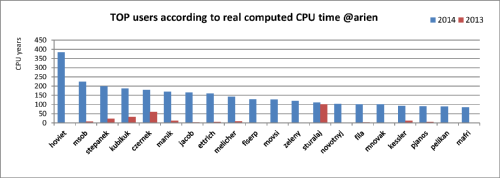

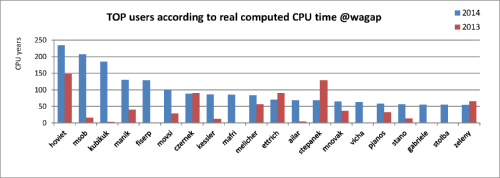

Žebříček největších počtářů na Torque serveru @arien a @wagap.

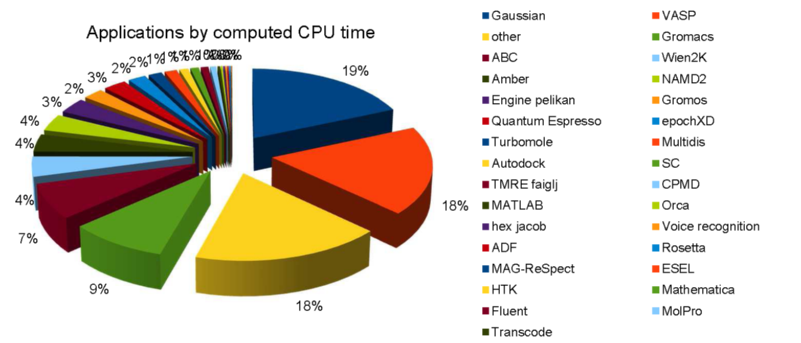

V roce 2014 bylo v MetaCentru nainstalováno nebo aktualizováno několik set aplikačních modulů. Veškeré změny v modulech jsou hlášeny na wiki a významnější SW rovněž fromou novinek.

Zde je přehled těch s největším propočítaným časem.

Ostatní grafy vytížení