Na konci roku 2024 mělo MetaCentrum VO celkem 3490 aktivních uživatelů. Pro srovnání, na konci roku 2023 byl počet aktivních účtů 3055, což znamená nárůst o 435 uživatelů. Tento trend potvrzuje rostoucí zájem o výpočetní zdroje a služby MetaCentra mezi akademickou a výzkumnou komunitou.

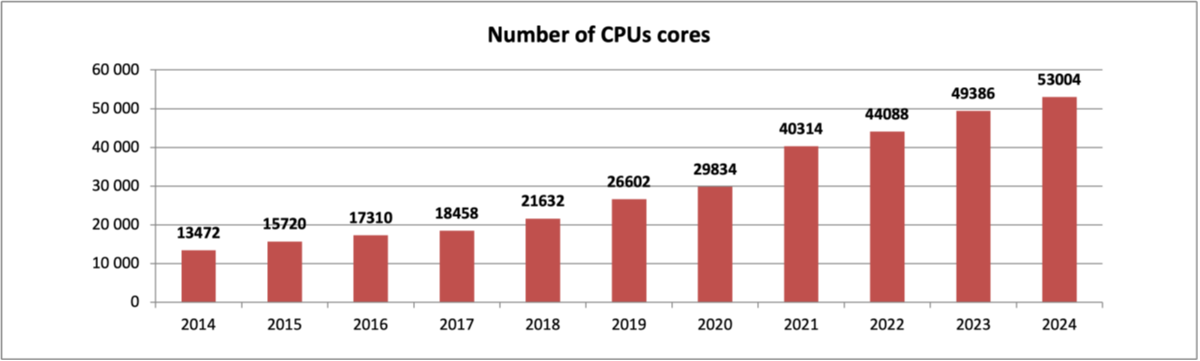

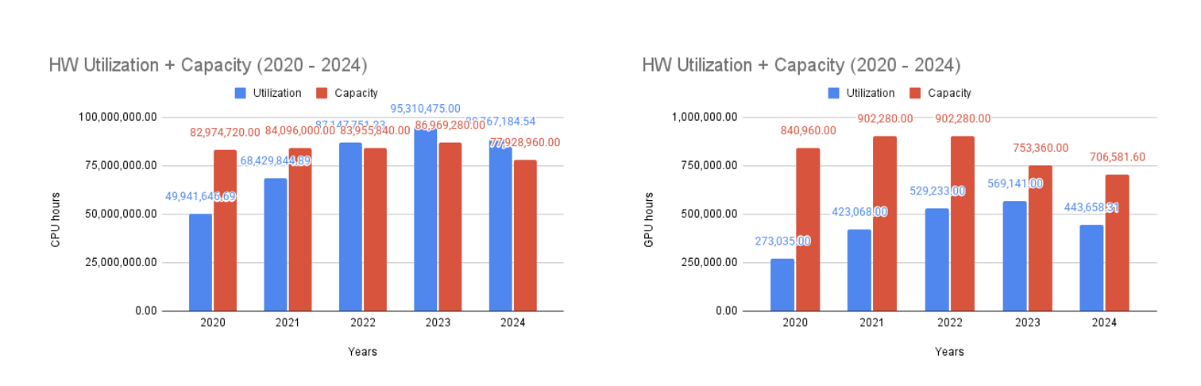

Meziročně došlo k nárůstu počtu dostupných CPU jader v rámci národního výpočetního prostředí MetaCentra, včetně zdrojů zapojených do mezinárodního prostředí EGI, na 53004 CPU jader (49386 CPU jader v roce 2023):

Vývoj počtu dostupných CPU jader v MetaCentru, včetně těch zapojených do EGI, v průběhu let:

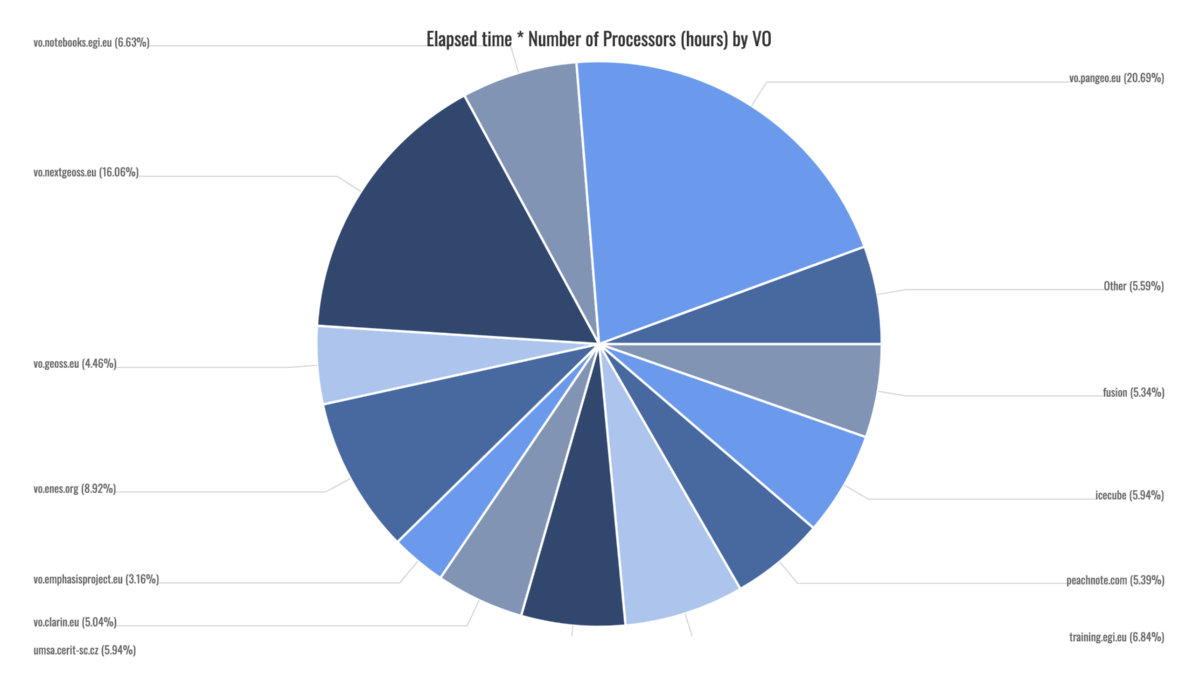

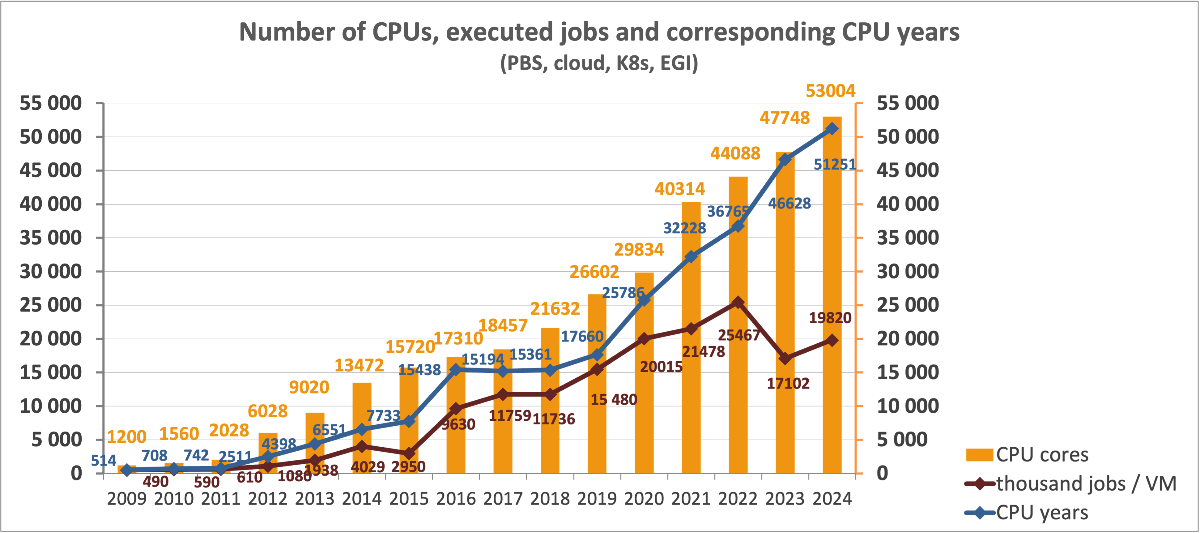

V roce 2024 uživatelé MetaVO, PBS, MetaCentrum Cloudu, SensitiveCloudu a Kubernetes dohromady propočítali 37552 CPU let, což představuje nárůst oproti roku 2023, kdy bylo propočítáno 31858 CPU let. Detailní rozdělení podle jednotlivých prostředí:

Dávkový systém (PBS): na 35804 jádrech se propočítalo více než 26,1 tisíce CPU let ve 11,4 milionech úloh. Více než 2,9 milionu úloh vyžadovalo výpočetní akceleraci pomocí GPU. Z toho 3448 CPU jader vlastnil projekt ELIXIR a propočítalo se na nich 1584 CPU let. Podrobnější statistiky zde.

MetaCentrum Cloud: v cloudu bylo na konci roku k dispozici 1368 CPU jader (v průběhu roku bylo k dispozici až 8895 CPU jader), propočítalo se na nich celkem 10,1 tis. CPU let na téměř 49 tisících virtuálních strojích. Výpočty zahrnují využití overcommitingu. Podrobnější statistiky zde.

Kubernetes: bylo v provozu 3008 CPU jader, které zpracovaly 1123 CPU let a celkem 3,2 milionu podů. Podrobnější statistiky zde.

SensitiveCloud: provozováno 952 CPU jader, které provedly výpočty odpovídající 185 CPU letům a 32 tisícům podů.

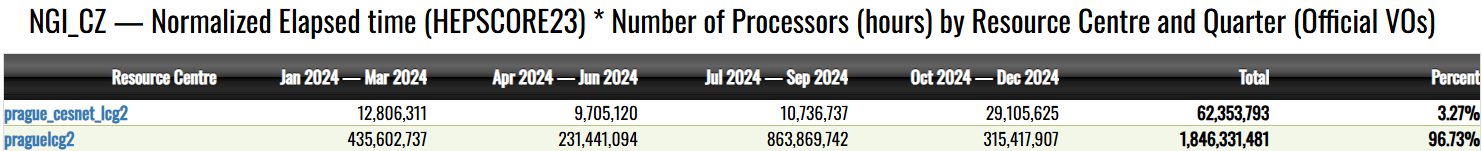

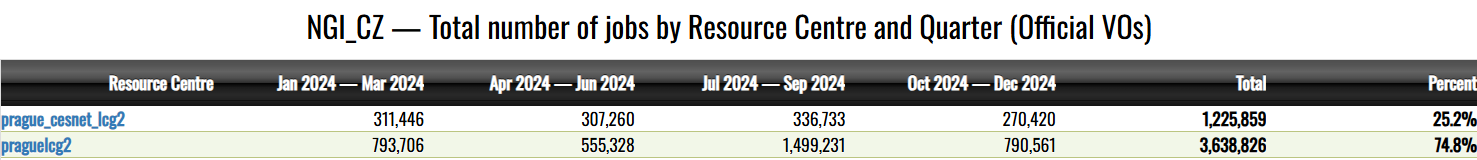

EGI: provozováni 6256 CPU jader (HTC) a další proměnlivá část jader je exportována do FedCloudu z MetaCentrumCloudu. Výpočet propočítaného času se EGI řídí jinou metrikou než v národním měřítku, používá se tzvn. HEPSCORE23. Podle tohoto skóre bylo propočítáno 217886 CPU let v HTC prostředí (ekvivalent naší PBS) a 1150 CPU let (dle naší metriky) se propočítalo v našem MetaCentruCloudu. Podrobnější statistiky zde.

Vývoj počtu jader, propočítaného času a počtu úloh ukazuje, že zatímco počet CPU jader, které jsou k dispozici a propočítaný čas (zahrnutý i EGI CPU čas aproximovaný naší metrikou) rostou proporčně, celkový počet propočítaných úloh roste pomaleji, a v posledních 2 letech klesl, protože příliš mnoho úloh nadměrně zatěžuje plánovač a doporučujeme tak sdružovat požadavky do větších úloh. Růst celkového propočítaného času kopíruje nárust počtu procesorů.

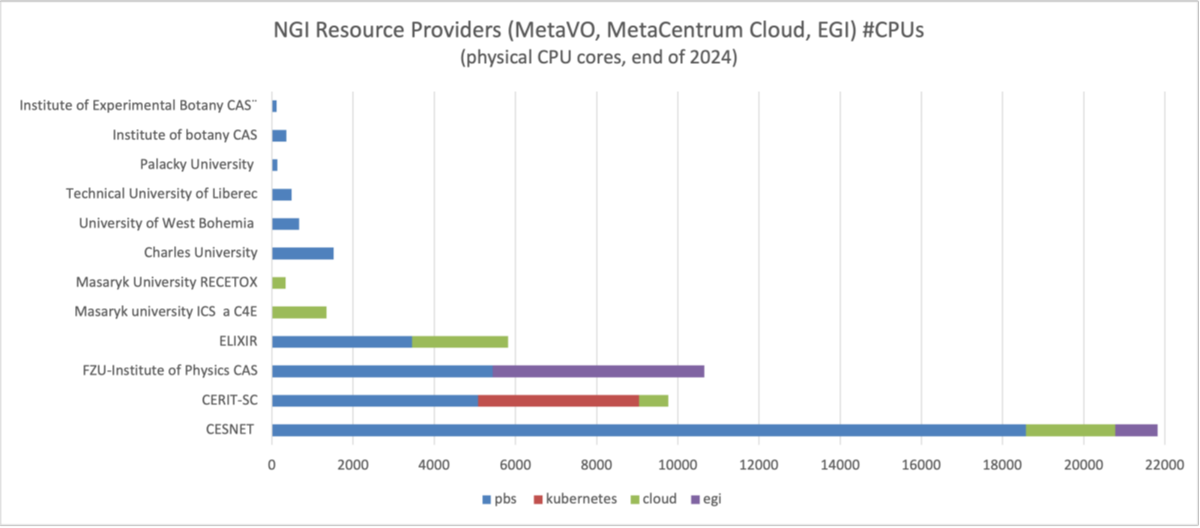

Vlastníci souhrnně:

21820 CPU jader patřilo CESNETu,

9768 CPU jader vlastnilo CERIT-SC,

21416 CPU jader bylo ve vlastnictví univerzit, Akademie věd ČR a velkých projektů.

Přehled dostupných clusterů podle množství CPU jader a platformy, na které jsou k dispozici, stav v prosinci 2024.

Na konci roku 2024 bylo v MetaCentru k dispozici celkem 53004 CPU jader v následujícím členění dle vlastníků a služeb:

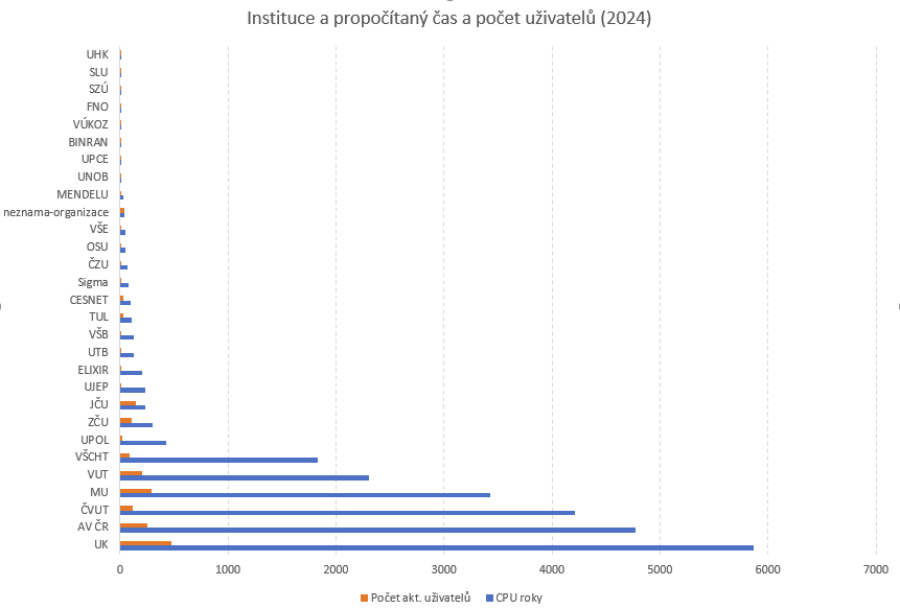

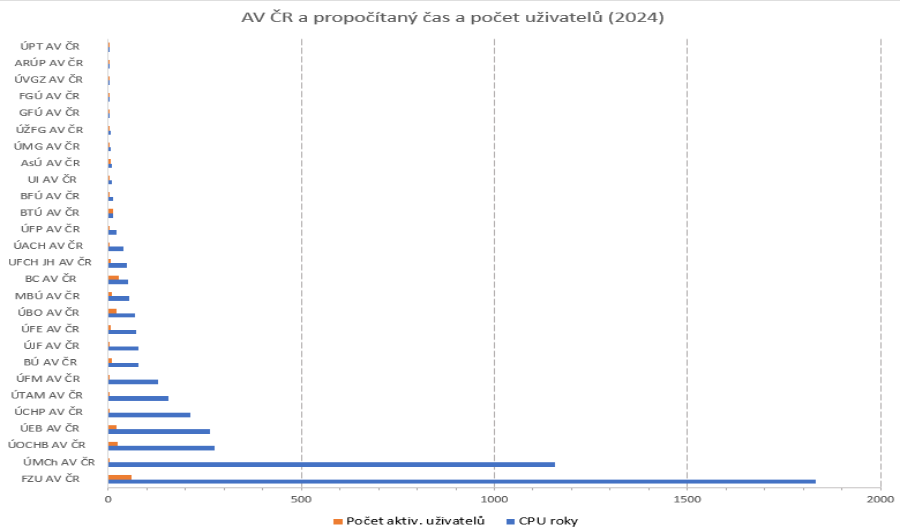

Využití MetaCentra organizacemi (Meta VO, PBS) dle propočítaného času. Na první grafu je Akademie věd započítána jako jedna organizace, na druhém pak jak počítaly jednotlivé ústavy v rámci Akademie věd. Do počtu uživatelů jsou započítáni pouze ti, kteří v roce 2024 spustili alespoň jednu úlohu.

V květnu 2024 došlo ke sjednocení plánovačů úloh (Meta, Elixir, CERIT-SC) do jednoho společného plánovače.

V PBS bylo k dispozici celkem 53 clusterů, 36452 CPU jader.

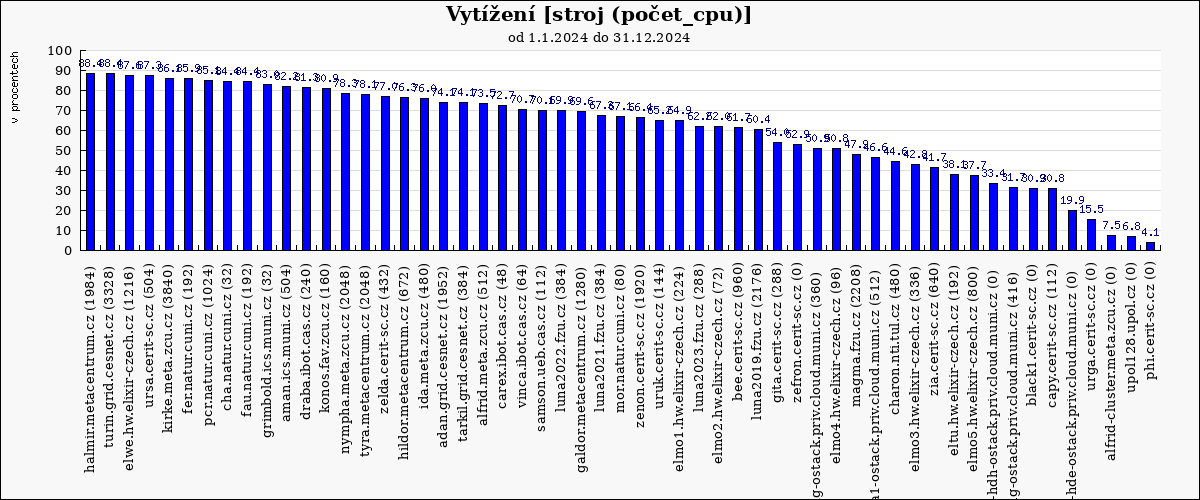

Následující graf ukazuje průměrné vytížení výpočetních clusterů a strojů v MetaVO v roce 2024. Základem pro výpočet průměrného vytížení (100%) je celkový počet dostupných CPU-core-seconds mínus počet CPU-core-seconds strojů, které nebyly v provozu. Rezervované stroje jsou započítané tak, jako by byly plně využity, bez ohledu na jejich skutečné využití. Údaj v závorce udává počet CPU v clusteru na konci roku. Nula značí, že cluster byl v průběhu roku vyřazen.

Průměrné vytížení strojů v MetaVO se v roce 2024 pohybovalo kolem 65–70 %, což je optimální úroveň. Vyšší vytížení by vedlo k delším čekacím dobám ve frontách, nižší vytížení mají typicky nové nebo specializované clustery (například GPU clustery nebo stroje rezervované pro konkrétní výzkumné projekty).

Následující graf ukazuje využití výpočetních uzlů (propočítaný CPU čas). Modrá čára označuje hranici, kolik CPU času mohlo být teoreticky v daný den propočítáno, kdyby byla využita všechna dostupná CPU jádra. Během jara 2024 proběhla migrace na nový plánovací systém a reinstalace výpočetních uzlů, což mělo dočasný vliv na průměrné vytížení.

![[2024]-CPU usage in time (CPU days) [2024]_(2024-01-01-2024-12-31)_1848096377](/export/sites/meta/images/statistiky/2024stats/x2024x-CPU_usage_in_time_xCPU_daysx_x2024x_x2024-01-01-2024-12-31x_1848096377.png)

Podobně lze ukázat využítí GPU karet (propočítané GPU dny), opět s propadem na přelomu března a dubna, kdy docházelo k reinstalaci všech clusterů a přechodu na nový plánovač:

![[2024]-GPU usage in time (GPU days) [2024]_(2024-01-01-2024-12-31)_1848096377](/export/sites/meta/images/statistiky/2024stats/x2024x-GPU_usage_in_time_xGPU_daysx_x2024x_x2024-01-01-2024-12-31x_1848096377.png)

Počet úloh příchozích do plánovač osciloval většinu roku okolo 35 tis. úloh denně. V dubnu, květnu a v říjnu bylo spuštěno mnoho malých obvykle zřetězených úloh několika málo uživatelů, které výrazně navýšily stadnardní denní počet úloh.

![[2024]-Jobs in time [2024]_(2024-01-01-2024-12-31)_1848096377](/export/sites/meta/images/statistiky/2024stats/x2024x-Jobs_in_time_x2024x_x2024-01-01-2024-12-31x_1848096377.png)

Nově pořízené stroje a clustery v roce 2024 a jejich využití:

Cluster Bee (Cerit-SC): obsahuje 960 CPU jader a 32× GPU NVIDIA H100 (96 GB GPU MEM).

10 uzlů dostupných v MetaCentrum PBS.

8 uzlů zapojených do Kubernetes.

2 uzly vyhrazené pro citlivé výpočty v Sensitive Cloudu.

Cluster Magma (Fyzikální ústav AV ČR): 23 uzlů, 2208 CPU jader, 1,5 TB RAM na uzel, bez GPU.

Server DGX H100 (CERIT-SC): 4× NVIDIA H100 (40 GB GPU RAM každá). Přístupný přes speciální frontu pouze pro optimalizované AI výpočty.

Využití výkonného stroje DGX H100

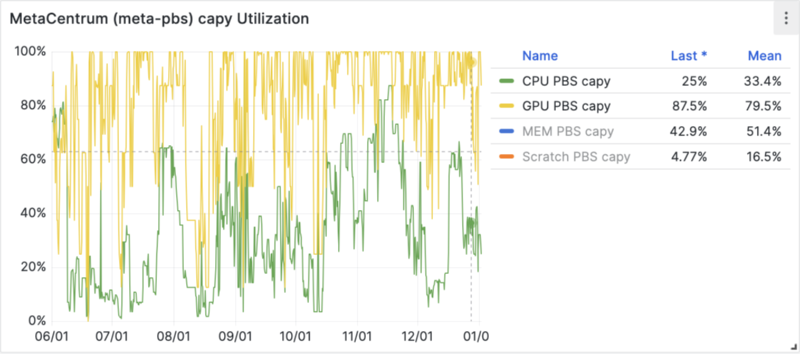

Stroj centra CERIT SC DGX H100 se 4 kartami NVIDIA H100 (GPU RAM 40 GB každá) byl pořízen v polovině roku (červen 2023). Je přístupný přes speciální frontu a jen pro uživatele, kteří doložili, že jej opravdu potřebují a umí využít. Standardní úlohy, které mohou být spočítány na méně výkonných kartách, na tento stroj vůbec nezařazujeme. I tak si získal velikou oblibu. Po prázdninách se využití GPU karet zvýšilo až ke 100 % a je prakticky stále obsazený.

Využití clusteru bee.cerit-sc.cz

Cluster bee s NVIDIA H100 (96 GB GPU MEM) byl pořízen v listopadu.

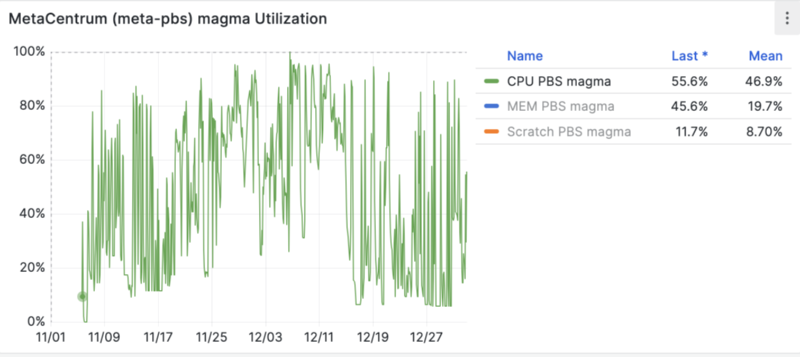

Využití clusteru magma.fzu.cz

Cluster magma s velkou RAM a bez grafických karet byl zprovozněn rovněž v listopadu. Stroj patří FZU AV ČR a byl přístupný ve speciální frontě vlastníků, čemuž odpovídá nížší vytížení.

Následující grafy vycházejí z dat ze syslogu o spouštěných modulech v úlohách běžících pod PBS od února do prosince 2024, za leden už data nejsou k dispozici.

Uživatelé MetaCentra využívali více než 3800 různých softwarových modulů v 11 milionech úloh. Nejčastěji používané moduly tvořily 87 % všech úloh s moduly. 100 nejčastěji spouštěných modulů tvoří 94 % všech úloh s moduly. Následují detailní grafy zobrazující:

Nejčastěji používané moduly.

Počet uživatelů jednotlivých modulů.

Využití komerčního software (počet spuštění, počet uživatelů, propočítaný čas).

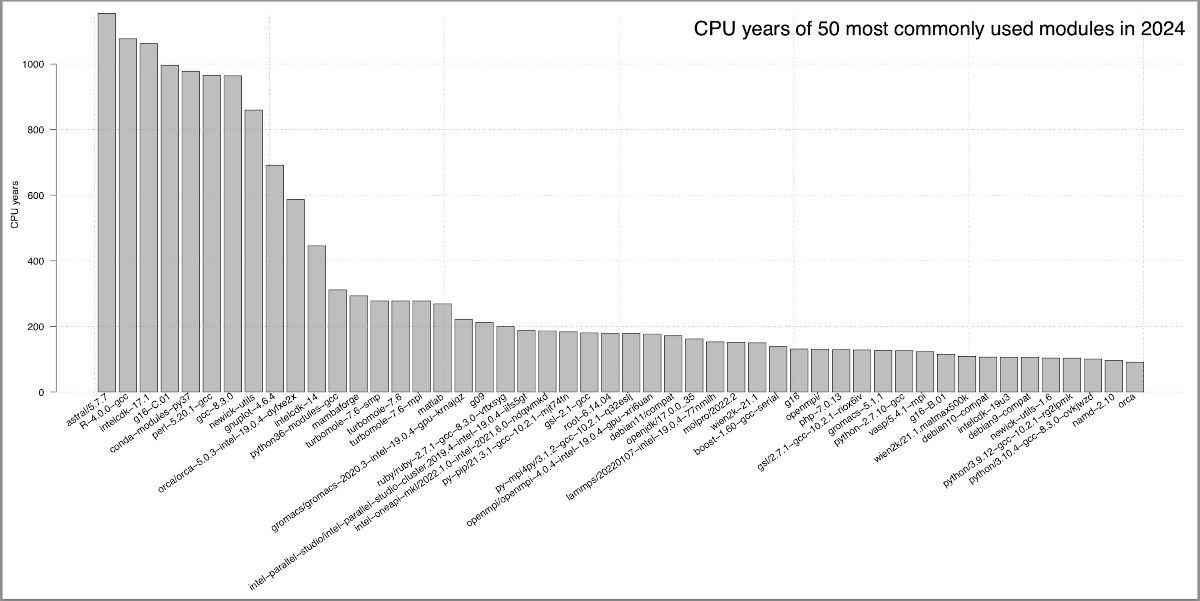

Následující graf ukazuje 50 nejčastěji použitých modulů podle CPU času.

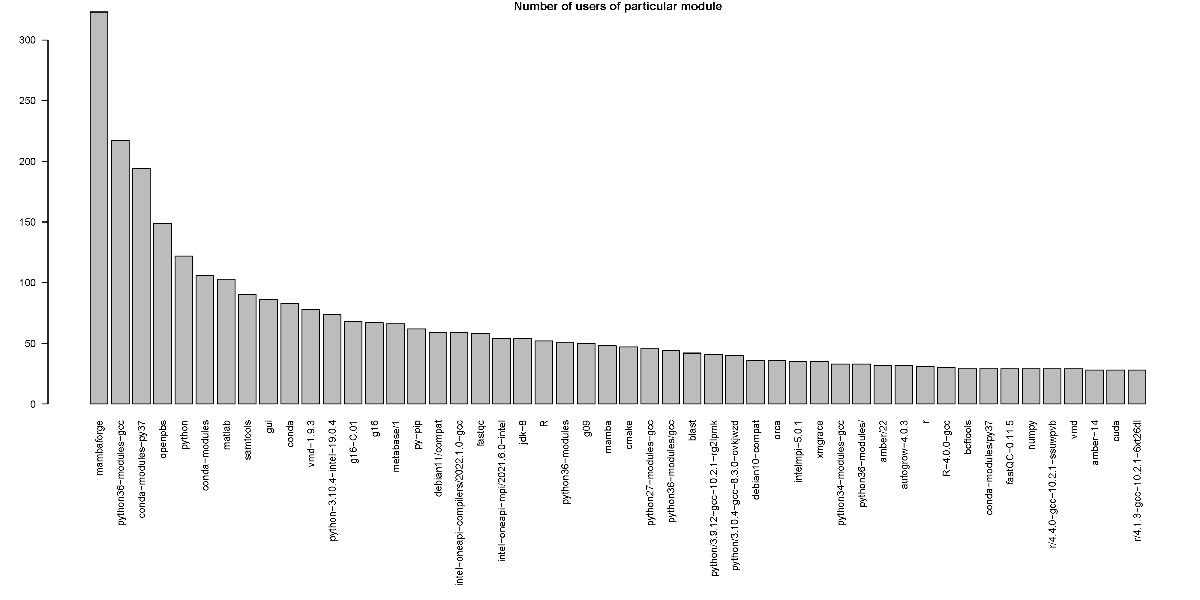

Následující graf ukazuje 50 nejoblíbenějších modulů používaných nejvíce uživateli (počet uživatelů, kteří modul použili).

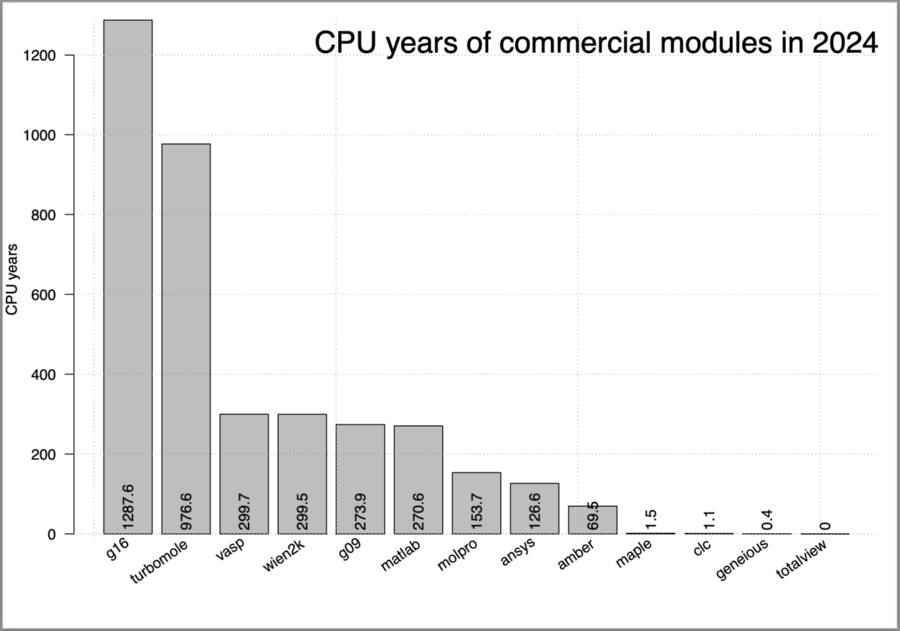

Využití komerčního SW podle CPU času vypadá následovně:

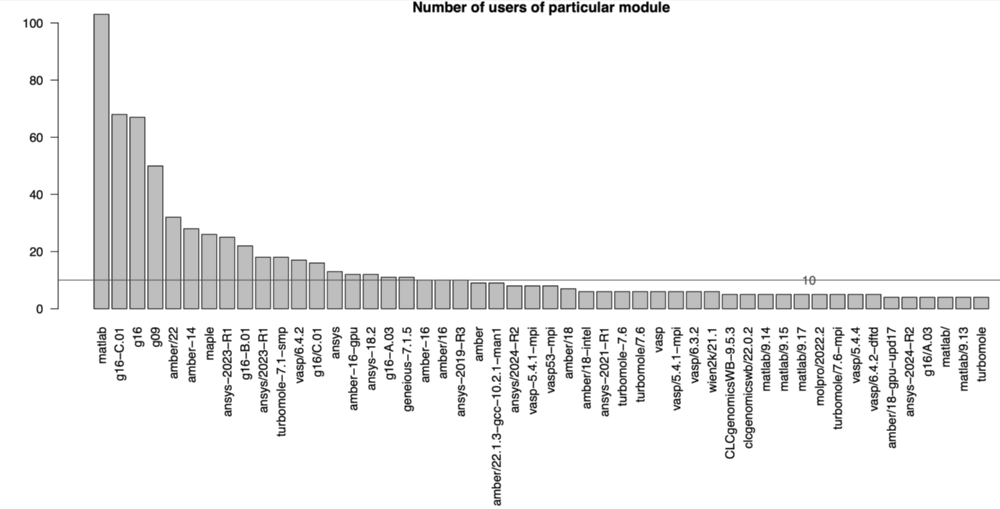

Využití komerčního SW podle počtu uživatelů, kteří jej použili ve svých úlohách.

Další podrobnější statistiky využití komerčních SW [PDF]

OpenOnDemand je grafické webové rozhraní pro spouštění interaktivních úloh, umožňující grafický náhled a manipulaci (Matlab, Ansys, apod.) a zároveň je zde možné jednoduše spouštět i dávkov úlohy. V obou případech úlohy běžely v PBS a jsou započítané v souhrnné statistice dávkového prostředí. Zde uvádíme jen počty uživatelů, úloh a propčítaný čas s využitím tohoto webového rozhraní:

350 uživatelů zadalo alespoň jednu úlohu.

Celkem 6155 úloh.

Celkový propočítaný čas: 63,5 CPU let.

Mezi nejčastěji používané aplikace patřily RStudio, Jupyter, Matlab, Ansys a další

Jednotlivé aplikace OnDemndu

| Aplikace | počet úloh | počet uživatelů | CPU let |

| RStudio | 2232 | 125 | 551,97 |

| Jupyter | 1683 | 144 | 273 |

| Desktop | 1018 | 146 | 264,7 |

| Matlab | 514 | 59 | 325,4 |

| Ansys | 483 | 27 | 108,5 |

| biop-desktop | 103 | 13 | 0,29 |

| VMD | 48 | 25 | 0,6 |

| CLC genomics | 2 | 2 | - |

| repet | 2 | 2 | - |

| Alphafold jobs | 99 | 3 | 124,4 |

106 uživatelů z projektu ELIXIR spustilo alespoň jednu úlohu a na dedikovaných strojích propočítali celkem 1584 CPU let ve 27 tis. úlohách.

Následují grafy ilustrující využití strojů uživateli z projektu ELIXIR. Kromě toho na strojích běžely výplňové úlohy jiných uživatelů, ty zde nejsou započítány.

Uživatelé projektu ELIXIR měli po celý rok k dispozici cca 3,5 tisíce CPU jader a využili je průměrně přibližně z poloviny. Jelikož ELIXIR nedisponuje GPU kartami, mnoho výpočtů uživatelé pouštěli v MetaCentru na ostatních strojích v běžných frontách.

![[Dedicated Elixir 2024]-CPU usage in time (CPU days) [Dedicated Elixir 2024]_(2024-01-01-2024-12-31)_-2032483053](/export/sites/meta/images/statistiky/2024stats/xDedicated_Elixir_2024x-CPU_usage_in_time_xCPU_daysx_xDedicated_Elixir_2024x_x2024-01-01-2024-12-31x_-2032483053.png)

Skutečné vytížení všech strojů bez ohledu na uživatele vlastníka je k dispoziciv Průměrném vytížení všech clusterů [PDF], jedná se o clustery elmo, eltu, eli a elwe.

Následující graf ilustruje počet úloh, které přicházely do systému. Od října 2024 došlo k velkému nárůstu počtu úloh, propočítaný čas se však nezměnil, což vypovídá o skutečnosti, že do systému přicházelo větší množství krátkých a malých úloh.

![[Dedicated Elixir 2024]-Jobs in time [Dedicated Elixir 2024]_(2024-01-01-2024-12-31)_-2032483053](/export/sites/meta/images/statistiky/2024stats/xDedicated_Elixir_2024x-Jobs_in_time_xDedicated_Elixir_2024x_x2024-01-01-2024-12-31x_-2032483053.png)

Počet úloh v systému podle požadované délky běhu a celkový propočítaný čas úlohami dané kategorie demonstruje následující graf. Je z něj patrné, že většina úloh běžela do 6 hodin, ale nejvíce CPU času propočítaly dlouhé úlohy s požadovanou délkou běhu alespoň týden.

![[Dedicated Elixir 2024]-Number of jobs and CPU years wrt. job types [Dedicated Elixir 2024]_(2024-01-01-2024-12-31)_-2032483053](/export/sites/meta/images/statistiky/2024stats/xDedicated_Elixir_2024x-Number_of_jobs_and_CPU_years_wrt._job_types_xDedicated_Elixir_2024x_x2024-01-01-2024-12-31x_-2032483053.png)

Podobně v swystém bylo nejvíce 1 CPU úloh a také 5-8 CPU úloh, ale nejvíce CPU času propočítaly úlohy požadující 32 a více CPU jader.

![[Dedicated Elixir 2024]-Number of jobs and CPU years wrt. job parallelism [Dedicated Elixir 2024]_(2024-01-01-2024-12-31)_-2032483053](/export/sites/meta/images/statistiky/2024stats/xDedicated_Elixir_2024x-Number_of_jobs_and_CPU_years_wrt._job_parallelism_xDedicated_Elixir_2024x_x2024-01-01-2024-12-31x_-2032483053.png_1204861542.png)

Graf doby čekání v závislosti na délce úlohy ukazuje, že nejdéle čekaly úlohy s dobou běhu alespoň týden. Půměrná doba čekání u krátkých úloh byla do 2 hodin, u těch delších byla průměrně do 30 hodin. GPU úlohy byly odbavovány okamžitě a směřovaly na jiné stroje v MetaCentru obsahující grafické karty.

![[Dedicated Elixir 2024]-Number of jobs and avg. Wait time wrt. job types [Dedicated Elixir 2024]_(2024-01-01-2024-12-31)_-2032483053](/export/sites/meta/images/statistiky/2024stats/xDedicated_Elixir_2024x-Number_of_jobs_and_avg._Wait_time_wrt._job_types_xDedicated_Elixir_2024x_x2024-01-01-2024-12-31x_-2032483053.png)

Obdobně graf doby čekání v závislosti na počtu požadovaných CPU jader ukazuje, že nejdéle čekaly úlohy požadující více než 64 CPU jader, kterých však bylo ojediněle. Půměrná doba čekání u krátkých úloh byla do 2 hodin.

![[Dedicated Elixir 2024]-Number of jobs and avg. Wait time wrt. job parallelism [Dedicated Elixir 2024]_(2024-01-01-2024-12-31)_-2032483053](/export/sites/meta/images/statistiky/2024stats/xDedicated_Elixir_2024x-Number_of_jobs_and_avg._Wait_time_wrt._job_parallelism_xDedicated_Elixir_2024x_x2024-01-01-2024-12-31x_-2032483053.png_1204861542.png)

Vytížení clusterů projektu ELIXIR podle prioritních front jednotlivých služeb ilustruje následující graf. Nejvíce CPU času bylo propočítáno běžnými uživateli ve 2+ týdenní frontě `elixir_2w`. Dále sem směřovaly úlohy z Galaxy serverů (usegalaxy.cz, umsa a RE galaxy).

![[Dedicated Elixir 2024]-Stacked Queue CPU usage in time (CPU days) [Dedicated Elixir 2024]_(2024-01-01-2024-12-31)_-2032483053](/export/sites/meta/images/statistiky/2024stats/xDedicated_Elixir_2024x-Stacked_Queue_CPU_usage_in_time_xCPU_daysx_xDedicated_Elixir_2024x_x2024-01-01-2024-12-31x_-2032483053.png)

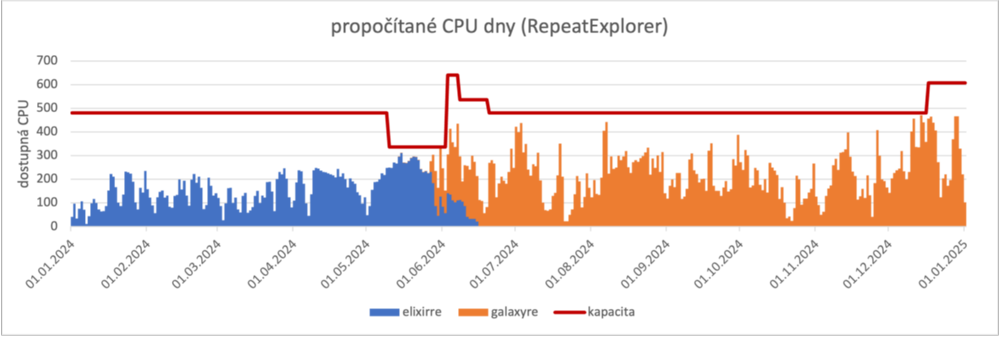

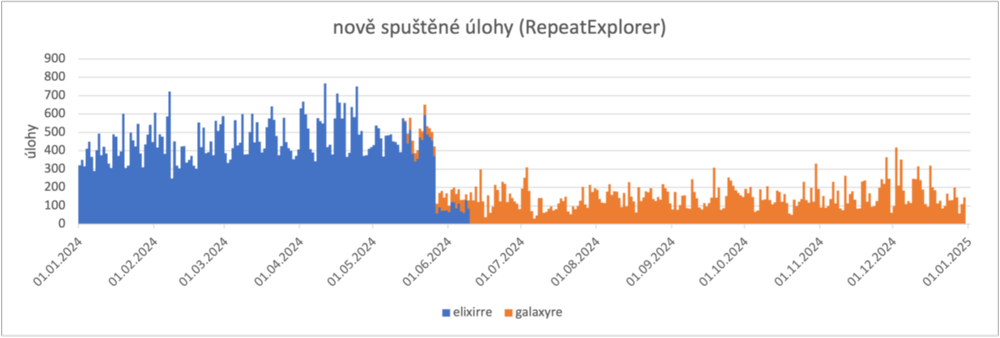

Službě RE Galaxy bylo vyhrazeno po většinu roku průměrně 500 CPU jader se 2 peaky v červnu a v prosinci, kdy do systému najednou přišlo mnoho požadavků najednou. V obou případech jsme na danou situaci reagovali navýšením počtu jader dedikovaných této službe. V květnu probíhala migrace na jiný plánovací systém, kdy došlo k dočasnému omezení počtu jader k dispozici, protože všechny výpočetní uzly bylo potřeba reinstalovat a přesunout na nový plánovací systém.

Na následujících grafech je znázorněné vytížení těchto dedikovaných výpočetních prostředků. Červená čára ukazuje kolik bylo zdrojů k dispozici v čase, modrá část grafu jsou úlohy běžící ve starém plánovači ve frontě `elixirre` a oranžová část jsou úlohy běžící už v novém plánovači ve frontě `galaxyre`. V červnu došlo k překryvu, ve starém plánovači dobíhaly úlohy čekající ve frontě a již běžící a ve stejném čase už v novém plánovači se spouštěly nově příchozí úlohy.

Následující graf demonstruje počet úloh přicházejících do systému a propočítaný čas. V polovině roku došlo ke změně politiky na straně RE Galaxy, kdy začaly být preferované delší úlohy a snížil se tak jejich počet. Propočítané CPU dny (předchozí graf) se naopak i po této změně zvýšil.

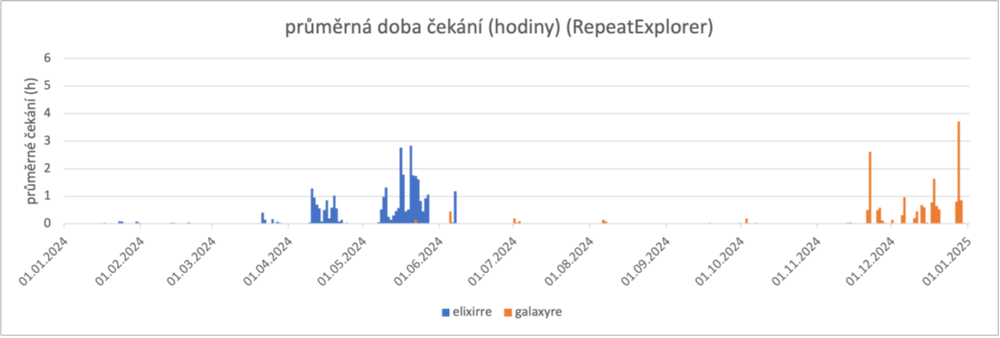

Graf průměrné doby čekání dokládá jak se snížení počtu úloh v systému pozitivně promítlo do rychlosti plánování a čekání úloh se v polovině roku velmi snížilo. Delší doba čekání se vyskytla v prosinci, kdy do systému přicházelo více požadavků na dlouhé úlohy nebo na úlohy vyžadující mnoho CPU jader.

Z grafu níže je zřejmé, že vyšší doba čekání byla zaznamenána u úloh požadujících týdenní a další čas běhu. Úloh s dobou běhu do 24 hodin bylo nejvíce a prakticky nečekaly, byly spouštěny ihned po příchodu, případně čekaly na spuštění jen pár minut.

![[RepeatExplorer 2024]-Number of jobs and avg. Wait time wrt. job types [RepeatExplorer 2024]_(2024-01-01-2024-12-31)_1523489601](/export/sites/meta/images/statistiky/2024stats/xRepeatExplorer_2024x-Number_of_jobs_and_avg._Wait_time_wrt._job_types_xRepeatExplorer_2024x_x2024-01-01-2024-12-31x_1523489601.png)

Podobně déle čekaly paralelní úlohy požadující více než 16 CPU jader. Těch sice bylo v systému poměrně málo, ale čekaly průměrně až 2,5 hodiny. Úlohy do 4 CPU byly odbavovány téměř okamžitě.

![[RepeatExplorer 2024]-Number of jobs and avg. Wait time wrt. job parallelism [RepeatExplorer 2024]_(2024-01-01-2024-12-31)_1523489601](/export/sites/meta/images/statistiky/2024stats/xRepeatExplorer_2024x-Number_of_jobs_and_avg._Wait_time_wrt._job_parallelism_xRepeatExplorer_2024x_x2024-01-01-2024-12-31x_1523489601.png_1204861542.png)

na konci roku 2024 bylo v provozu 3008 CPU jader (vloni 2432), z toho 736 CPU jader bylo zprovozněno na konci listopadu.

K dispozici bylo 47 GPU karet různých typů:

| Typ GPU karty | počet |

| NVIDIA H100 96 GB NVL | 8 |

| NVIDIA H100 PCIe | 2 |

| NVIDIA A40 | 21 |

| NVIDIA L4 | 1 |

| NVIDIA A10 | 5 |

| NVIDA A100 80GB PCIe | 10 |

Za celý rok bylo propočítáno celkem 1123 CPU let ve 3,2 mil. podech. Rancher použilo 200 uživatelů, 428 uživatelů vyzkoušelo jupyter + alphafold/foldify.

Využití významných aplikací běžících v Kubernetes

Běžící projekty (měřeno od srpna 2024)

V roce 2024 MetaCentrum Cloud provozoval 8896 CPU jader, během roku byly staré stroje vyřazené a v prosinci zůstalo v provozu 7368 CPU jader a 76 GPU karet.

Nastavení over-commitu vede k optimálnímu využití cloudu a reálné využití pak převyšuje teoretickou kapacitu fyzických jader. V průběhu roku 2024 poklesl počet CPU jader k dispozici (capacity) oproti roku 2023, takže se snížil i celkový propočítaný čas. V roce 2024 disponoval cloud až 81 grafickými kartami s teoretickou roční kapacitou 706 581 hodin. Skutečné využití dosáhlo 34 %. Na konci roku bylo k dispozici 76 GPU karet.Výkon GPU karet je k dispozici pouze skupinovým projektům.

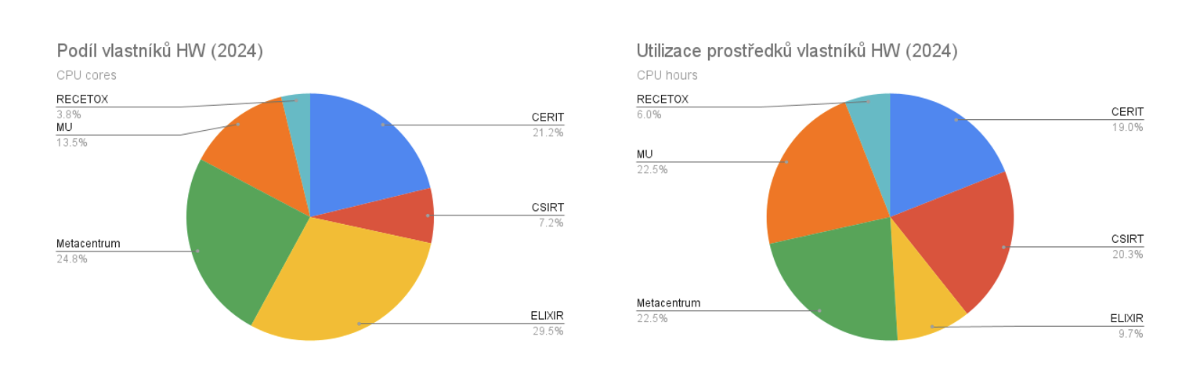

Cloud je tvořen desítkami strojů organizovaných do clusterů, které financují různé organizace a kterých jsou vlastníky. Podíl vlastníků dle počtu pořízených CPU jader vyjadřuje následující graf.

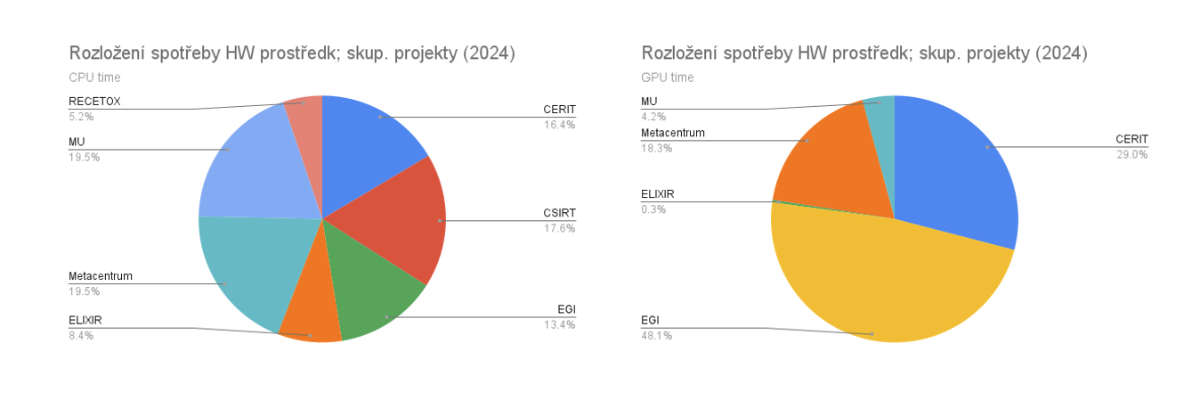

Využití CPU času posuzujeme v rovině skupinových projektů a v ideálním případě každá organizace využije CPU čas adekvátně tomu, kolik CPU jader vlastní.

Srovnáním podílu na celkovém množství spotřebovaného času CPU jader (sloupec 2024 CPU hours) a vlastnickém podílu v celkovém objemu clusterů (sloupec 2024 CPU hw - cores) lze posoudit, zda zákazníci využívají CPU čas adekvátně vzhledem ke svému podílu investic do tohoto typu HW.

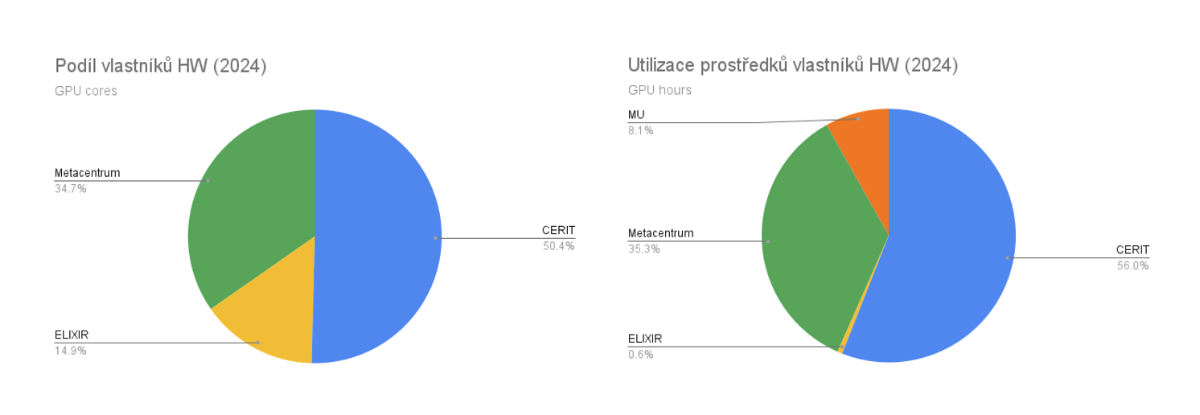

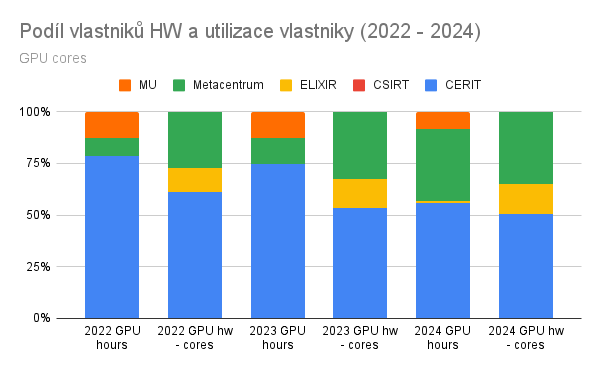

I v případě GPU kapacity cloudu evidujeme podíl vlastnictví jednotlivých organizací (spíše infrastrukturních projektů), které karty zakoupili. Využití GPU času posuzujeme v rovině skupinových projektů (osobní projekty k výkonu GPU karet přístup neamají) a v ideálním případě každá organizace využije GPU čas adekvátně tomu, kolik GPU karet vlastní.

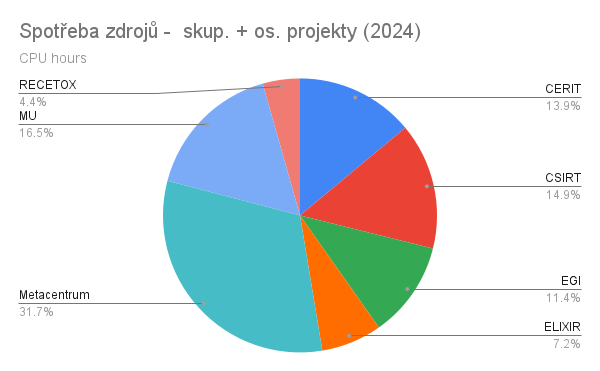

Z hlediska využití zdrojů v rovině CPU bylo nejvíce aktivní MetaCentrum. MetaCentrum zaštiťuje, kromě skupinových projektů, i 99% všech osobních projektů uživatelů MetaCentra běžících v cloudu, což výrazně zvyšuje podíl utilizace zdrojů ve prospěch MetaCentra, jako poskytovatele infrastrukturních služeb. Podobně CERIT-SC vkládá do cloudu infrastrukturní zdroje, ze kterých část je poskytnuta jako další výpočetní kapacita v PBS. Další projekty jsou spoušťeny pod hlavičkou Masarykovy univerzity, z těch větších je pak samostatně vyčílena aktivita univerzitního CSIRT týmu a projektu RECETOX, část kapacity připadá na velký projekt ELIXIR a část zdrojů je vyhražena pro potřeby evropského výpočetního prostředí EGI.

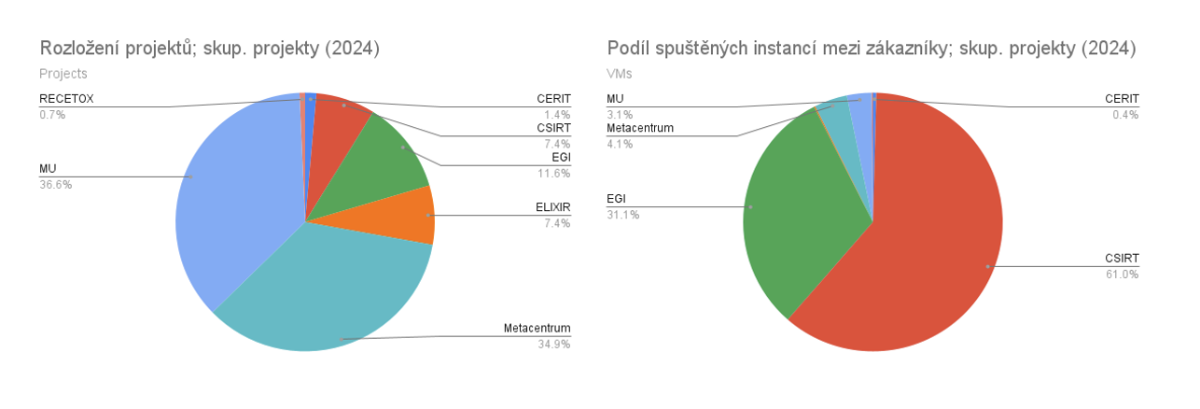

Z hlediska využití zdrojů v rovině CPU při provozu skupinových projektů je nejvíce aktivní MU a Metacentrum. MU zároveň provozuje nejvíce skupinových projektů s celkovým podílem 36.6 %, následována Metacentrem s podílem projektů 34.9 %. S ohledem na využití jader GPU, nejvíce GPU času propočítaly skupinové projekty EGI (v roce 2024 celkem 32 projektů). Mezi deseti projekty s nejvyšší spotřebou GPU času je právě sedm projektů zákazníka EGI.

Největší počet skupinových projektů provozovala v roce 2024 Masarykova univerzita a Metacentrum v celkovém úhrnu 71.5 %. Největší podíl na počtu spuštěných virtuálních strojů má CSIRT pod, MU, který staví významné množství virtuálních strojů pro potřeby školení a cvičení v kybernetické bezpečnosti.

Využití cloudových zdrojů organizacemi

Bližší vhled do využití zdrojů zákazníků (CPU time) lze získat pohledem do jejich organizací, pod kterými jsou projekty řešeny.

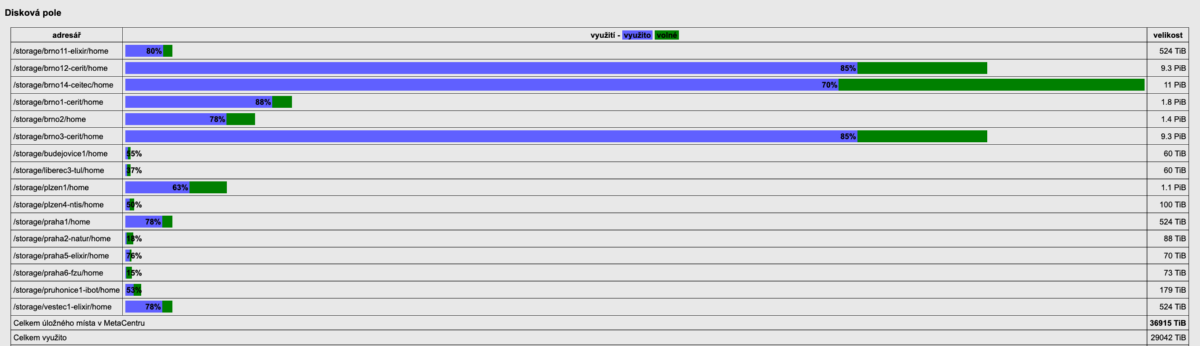

Meziročně opět vzrostlo zaplnění diskových polích v MetaCentru i v CERIT-SC. Mimo to, se podařilo integrovat diskové pole jiných vlastníků do infrastruktury MetaCentra (CEITEC, ELIXIR). Přístup na taková pole je dedikován vlastníkům, po dohodě s nimi může být přístupný i pro další uživatele.

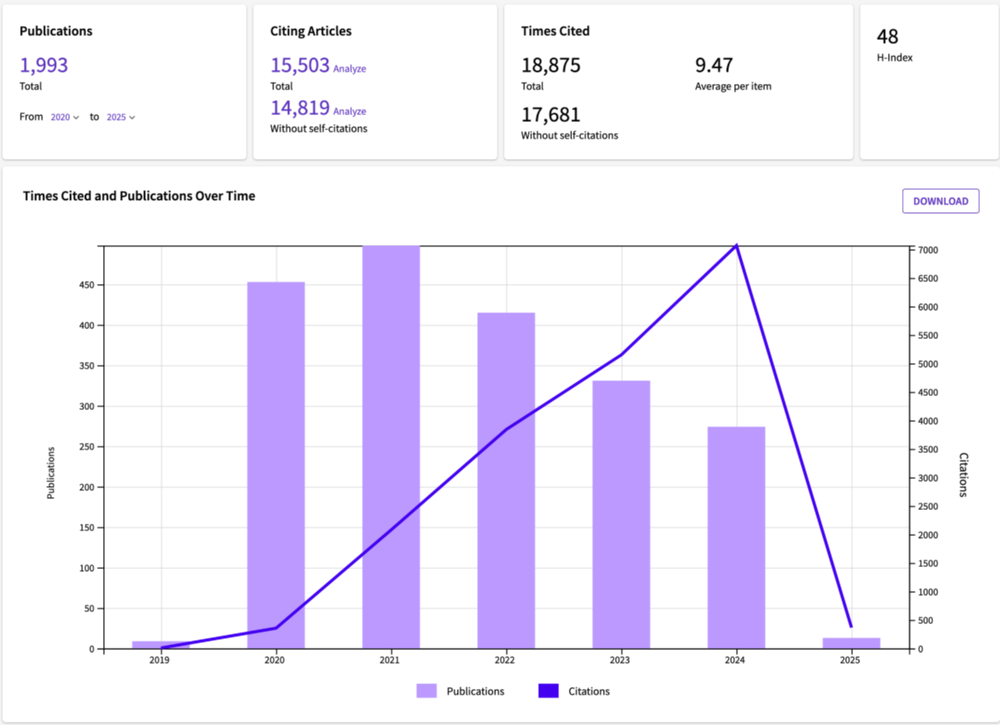

Seznam publikací s poděkováním e-INFRA CZ infrastruktuře z WoS je k dispozici v samostatném dokumentu [PDF].

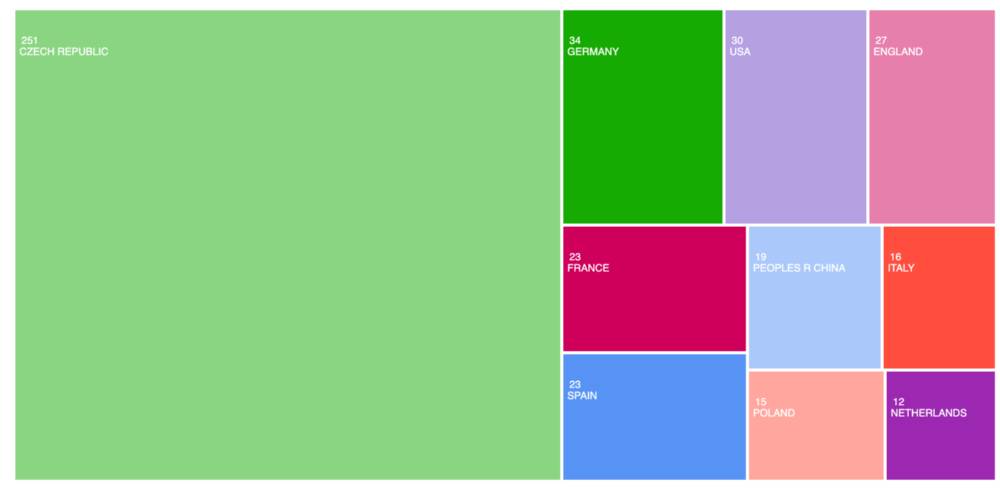

Následující grafy jsou pořízené z portálu WoS.

Organizace u publikací s poděkováním e-INFRA CZ (WoS):

Typy publikací

Kategorie publikací

Publikace podle zemí autorů

Publikace podle oborů

Citece (WoS)

Podrobné HTC statistiky [PDF]

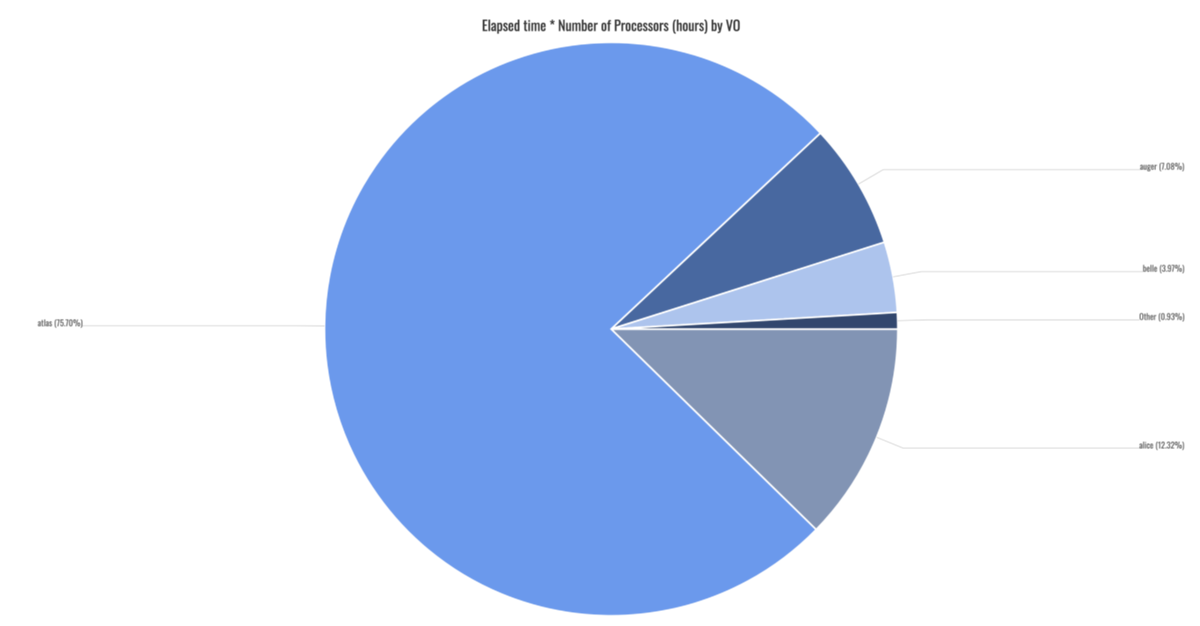

Za celý rok bylo na klasteru skurut spuštěno 1,2 milionu gridových úloh [2], normovaný propočítaný čas činil 62 milionů hodin (v jednotkách HS23) [3]. Do tohoto čísla byly započítané i zdroje zapůjčené IT4Innovation (60% celkově propočítaného času).

[2] https://accounting.egi.eu/egi/site/prague_cesnet_lcg2/elap_processors/VO/DATE/2024/1/2025/1/egi/onlyinfrajobs/

[3] https://accounting.egi.eu/egi/site/prague_cesnet_lcg2/normelap_processors/VO/Year/2024/1/2024/12/egi/onlyinfrajobs/

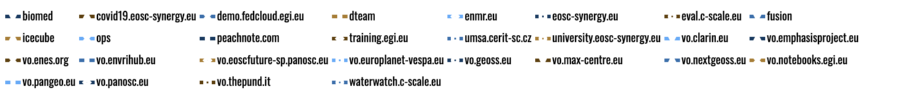

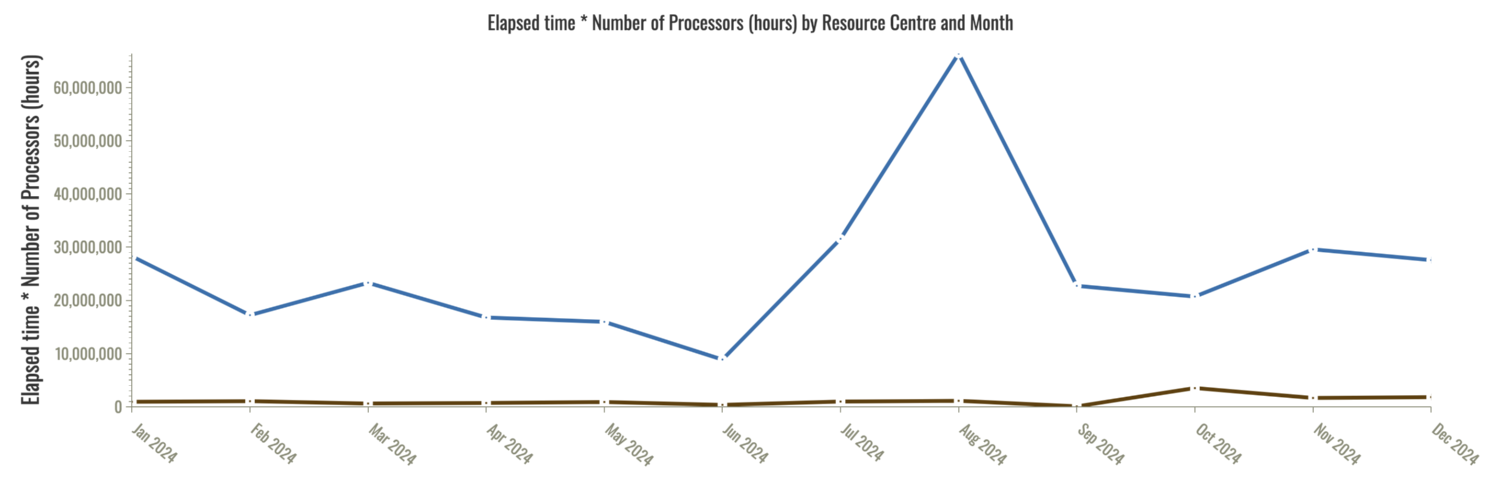

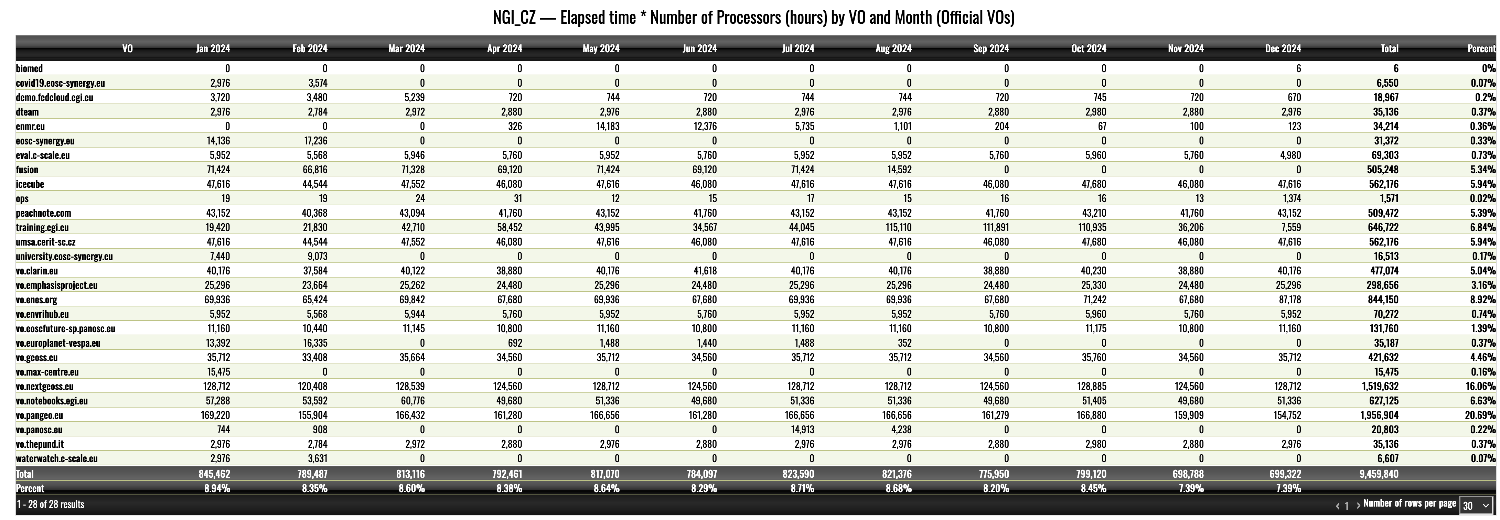

Statistiky převzaté z EGI accountingu: VO, které počítaly na strojích MetaCentra v rámci cloudové aktivity FedCloud

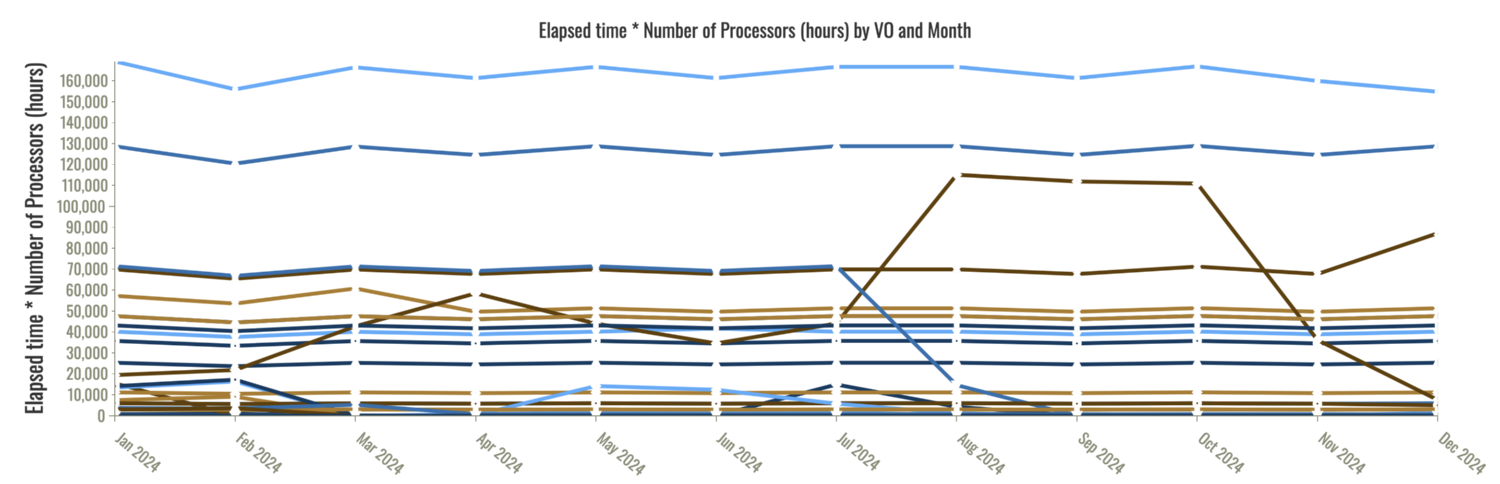

Propočítaný čas po měsích jednotlivými VO: