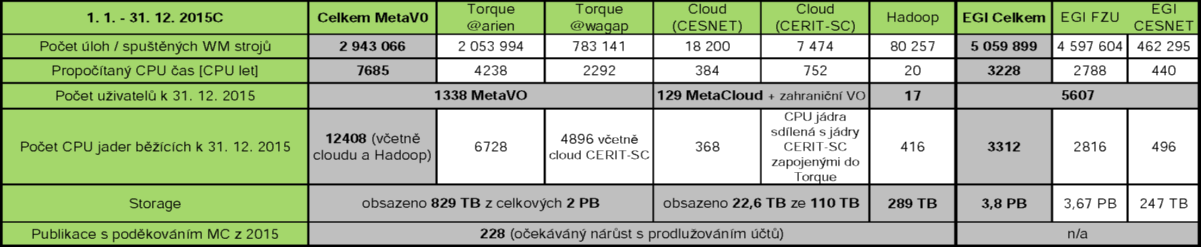

Celkový počet aktivních uživatelů v MetaVO na konci roku 2015 byl 1338. Pro srovnání, koncem roku 2014 mělo v MetaVO účet 1112 uživatelů. Cloudové prostředí MetaCloud využívá 129 uživatelů z českých akademických a výzkumných institucí. Cloudové zdroje jsou dále nabízeny v rámci EGI zahraničním výzkumníkům (FedCloud apod.). Prostředí Hadoop vyzkoušelo 36 uživatelů.

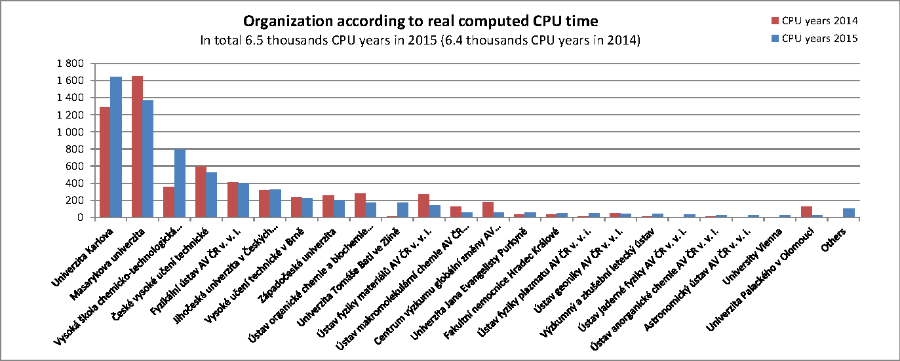

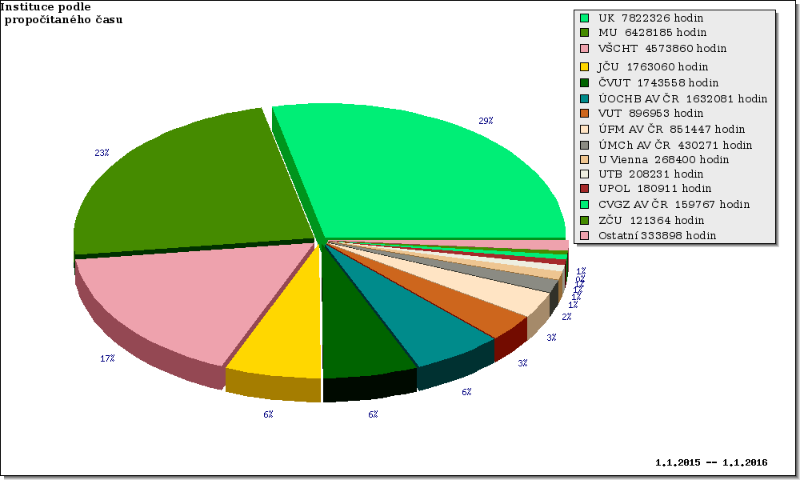

V roce 2015 uživatelé MetaVO propočítali celkové 7,5 tis. CPU let. Z toho v dávkovém systému (PBS Torque) bylo propočítáno přibližně stejně, jako vpředchozím roce, celkem více než 6,5 tis. CPU let (oproti 6,4 tis. CPU let v roce 2014). Dalších 999 CPU let bylo propočítáno v cloudovém prostředí a 20 CPU let v prostředí Hadoop.

Meziročně vzrostl počet CPU jader v MetaVO na 12408 CPU jader (vloni 10160, obě hodnoty jsou uvedené včetně cloudových strojů a Hadoop). Počet disponibilních CPU jader v Torque prostředí (PBS servery arien i wagap) zůstal přibližně stejný jako v předchozím roce. Kvůli zvýšené poptávce byla posílena cloudová část MetaVO. Stroje ve vlastnictví centra CERIT-SC běží, díky důsledné virtualizaci, v obojetném režimu (cloud i Torque), počty jader se přidělují podle aktuální poptávky v obou prostředích.

Meziročně doslo k poklesu počtu spuštěných úloh a virtuálních strojů ze 3,9 mil. v roce 2014 na 2,9 mil. spuštěných úloh ve stejném období 2015. Celkový propočítaný čas zůstal zachován, takže pokles úloh lze vysvětlit spouštěním více delších a masivněji paralelních úloh.

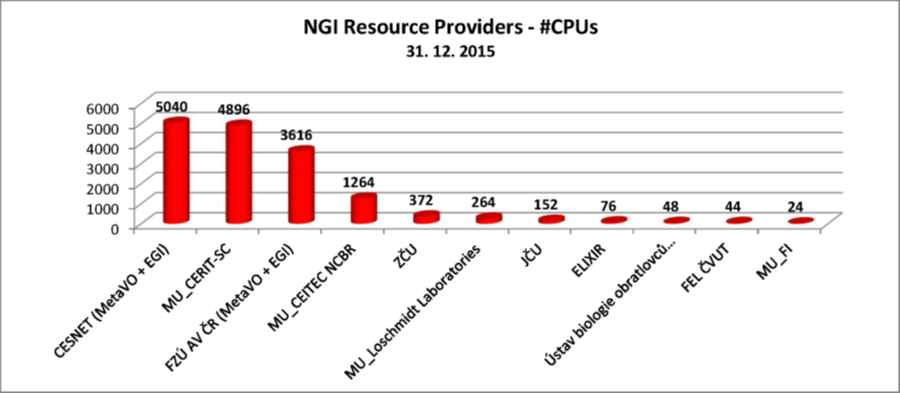

Do mezinárodním výpočetní infrastruktury EGI jsou zapojené zdroje CESNETU (496 CPU jader) a FZÚ AV ČR (2816 CPU jader). Na těchto strojích bylo v roce 2015 propočítáno 3228 CPU let ve více než 5 mil. úloh.

V MetaCentrum NGI jsou zapojeny tři skupiny zdrojů. Národní výpočetní a úložné kapacity zapojené v MetaVO, které jsou k dipsozici pro zaměstnance a studenty akademických a výzkumných organizací v ČR a jejich výzkumné partnery. Sem patří zdroje využívající dávkový systémPBS Torque, cloudové stroje z MetaCloudu a specializovaná výpočetní platforma Hadoop. Kromě toho MetaCentrum NGI spravuje rovněž stroje dedikované projektu ELIXIR a stroje zapojené do mezinárodní výpočetní infrastruktury EGI.

MetaVO včetně Torque, MetaCloudu a Hadoop

Elixir VO

EGI

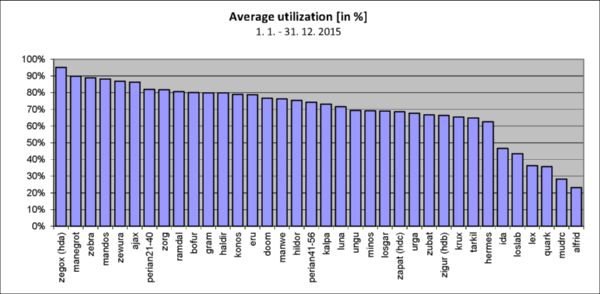

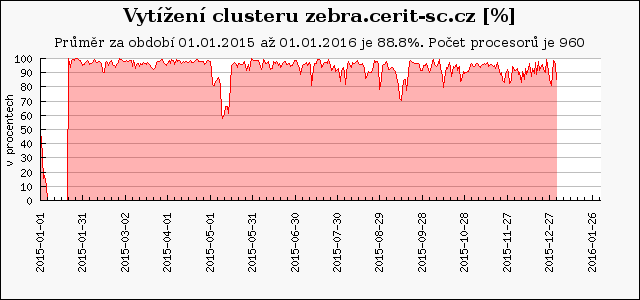

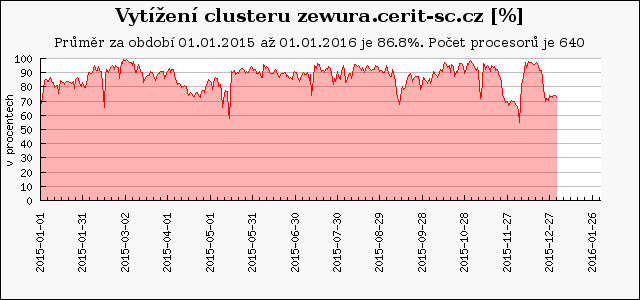

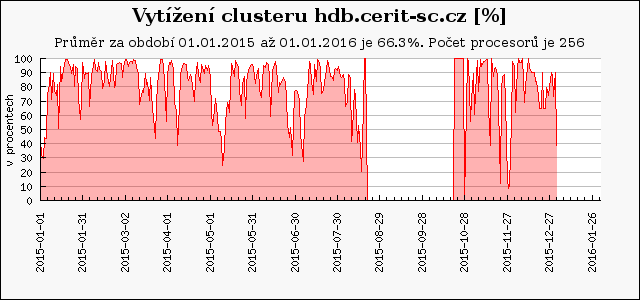

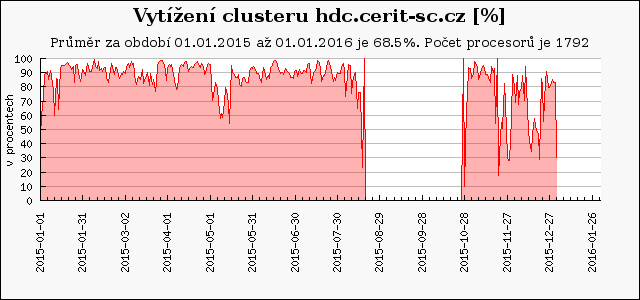

Následující graf ukazuje průměrné vytížení výpočetních clusterů a strojů v MetaVO v roce 2015. Základem pro výpočet průměrného vytížení (100%) je celkový počet dostupných CPU-core-seconds mínus počet CPU-core-seconds strojů, které nebyly v provozu. Rezervované stroje jsou započítané tak, jako by byly plně využity, bez ohledu na jejich skutečné využití. Údaj v závorce udává počet CPU v clusteru na konci roku. Nula značí, že cluster byl v průběhu roku vyřazen.

Průměrné vytížení volně dostupných strojů v MetaCentru se pohybovalo mezi 60 a 95 %. Vytížení okolo 70% je optimální, vyšší vytížení již znamená faktickou saturaci a způsobuje delší doby čekání úloh ve frontě. Nižší hodnoty vytížení vykazují stroje, které byly do MetaCentra zapojeny až v průběhu sledovaného období nebo jsou unikátní vyhrazené pro specifický typ výpočtů nebo vyhrazené pro některou skupinu. Oproti loňskému roku se vytížení strojů zvýšilo jednak díky vyššímu zájmu uživatelů a také v důsledku nasazení optimalizace plánovače (spouštění výplňových úloh) pro Torque server @arien.

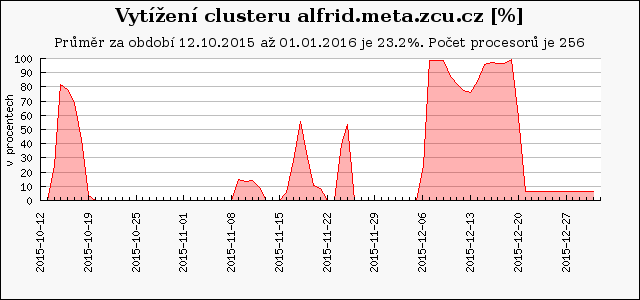

V průběhu roku byl uveden do provozu nový vSMP cluster (ScaleMP) alfrid.meta.zcu.cz -- 16 uzlů, 256 CPU jader, 4 TB paměti. Cluster je provozován ve zvláštním režimu. Více informací na https://wiki.metacentrum.cz/wiki/ScaleMP

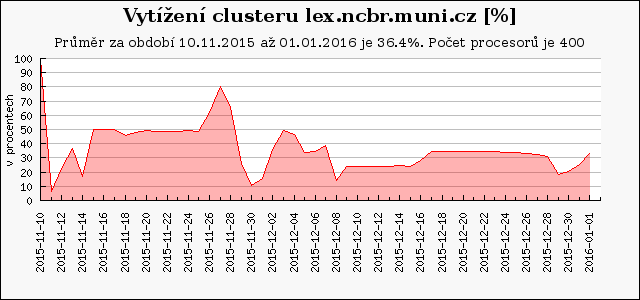

Koncem roku 2015 byly do MetaVO přidány tři nové clustery patřící CEITEC-NCBR, včechny 3 clustery jsou přístupné přes Torque server arien.ics.muni.cz, s priviligovaným přístupem vlastníků. První, HD cluster lex.ncbr.muni.cz -- 25 uzlů, 400 CPU jader (Intel Xeon), 128 GB RAM na uzel, výkon každého uzlu dle SPECfp2006 je 556. Cluster lex je přístupný všem zájemcům MetaCentra prostřednictvím front preemptible a backfill (Torque server arien.ics.muni.cz). Uživatelé z CEITEC MU a NCBR mají privilegovaný přístup. Do provozu byl uveden 10. listopadu, díky testovacímu režimu se vytížení pohybovalo okolo 36%.

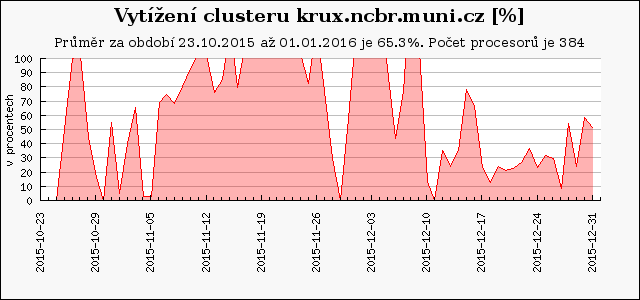

Druhým nově pořízeným clusterem této skupiny je výkonnější HD cluster krux.ncbr.muni.cz -- 6 uzlů, 384 CPU jader (AMD Opteron), 128 GB RAM na uzel, výkon každého uzlu dle SPECfp2006 je 726. Cluster byl zprovozněn koncem října a jeho obliba byla vyšší (díky rychlejším procesorům), jeho průměrné vytížení přesáhlo 65 %.

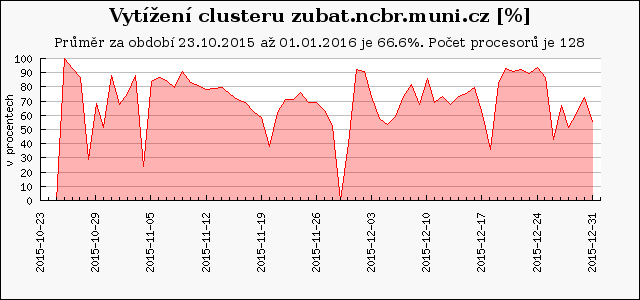

A do třetice skupina pořídila a zapojila nový GPU cluster zubat.ncbr.muni.cz -- 8 uzlů, 128 CPU jader, (Intel Xeon), 128 GB RAM na uzel, výkon každého uzlu dle SPECfp2006 je 556. Každý uzel obsahuje 2x nVidia Tesla K20Xm 6GB (aka Kepler). Rovněž tento cluster se, díky GPU kartám, těšil mezi uživateli velké oblibě, jeho průměrné vytížení taktéž přesáhlo 65 %.

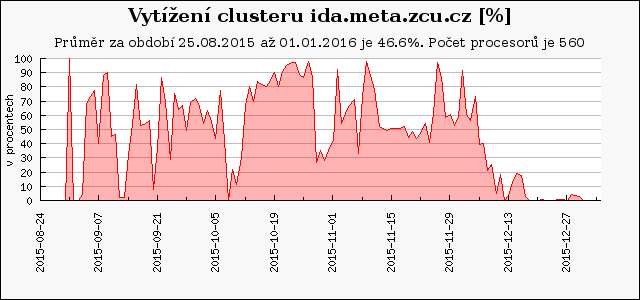

Nový cluster ida.meta.zcu.cz, obsahující celkem 28 strojů (560 CPU jader), pořídil CESNET do lokality Plzeň ZČU. Stroje jsou přístupné přes Torque server arien.ics.muni.cz. Cluster byl zprovozněn na konci srpna a jeho průměrné vytížení přesáhlo 46 %.

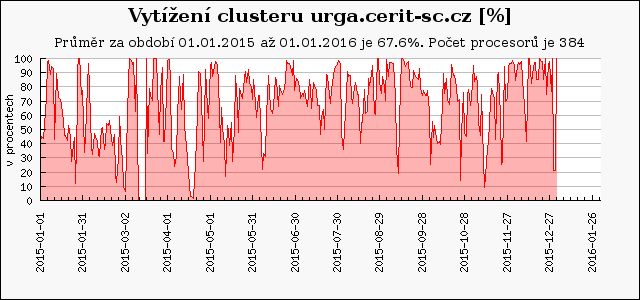

Na sklonku roku 2014 byl uveden do provozu pořadí druhý unikátní NUMA server SGI UV2 urga.cerit-sc.cz (384 CPU jader a 6TB RAM), který byl pořízen ve spolupráci s Fakultou informatiky MU a je určen rovněž pro výuku na FI. Jeho průměrné vytížení dosáhlo téměř 70 %.

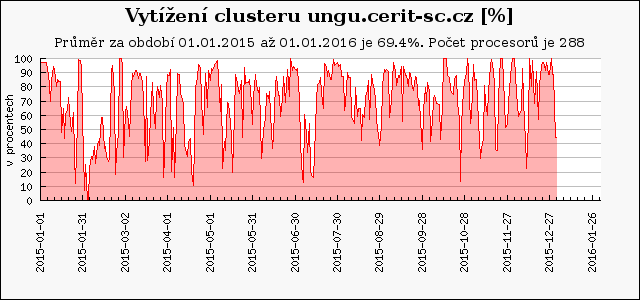

Podobně je na tom typově stejný stroj ungu.cerit-sc.cz (288 CPU jader, 6 TB RAM), pořízený o rok dříve. Jeho průměrné vytížení bylo rovněž na hranici 70 %.

Průměrné vytížení SMP clusterů zebra.cerit-sc.cz a zewura.cerit-sc.cz (20 uzlů po 80 CPU jádrech a až 1,5 TB paměti) bylo 89 a 87 %.

Průměrné vytížení HD clusterů zigur.cerit-sc.cz a zapat.cerit-sc.cz (144 uzlů po 8 - 16 CPU jadrech a 128 GB RAM) dosáhlo 66 a 69 %, nižší vytížení bylo způsobené stěhováním a následnými problémy při zapojování clusterů na novém sále (vyžádalo si zásah dodavatele). Od konce srpna do konce října stroje nebyly v provozu, je to vidět i na následujících grafech.

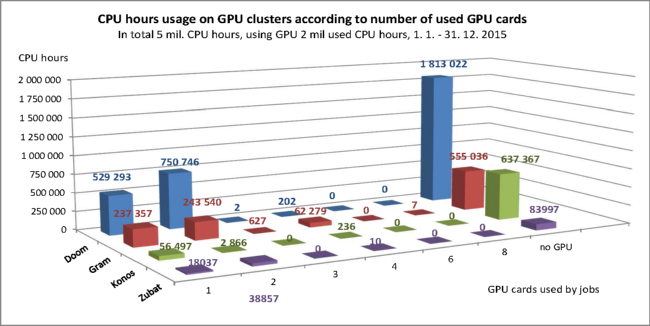

V MetaCentru byly v roce 2015 k dispozici 4 clustery s GPU kartami:

Na těchto GPU clusterech bylo v roce 2014 propočítáno celkem 5 mil. CPU hodin, z toho 2 mil. CPU hodin úlohami využívajícími GPU a 3 mil. CPU hodin úlohami bez GPU. Nejčastěji úlohy využívaly 1 nebo 2 karty, ale vyskytly se i úlohy požadující více uzlů a až 8 GPU karet. GPU úlohy se na těchto clusterech spouštějí v privilegovaných frontách gpu a gpu_long. Pokud není o GPU karty zájem nebo GPU úloha neobsadí všechny CPU jádra, na strojích se spouštějí kratší výplňové úlohy z běžných front.

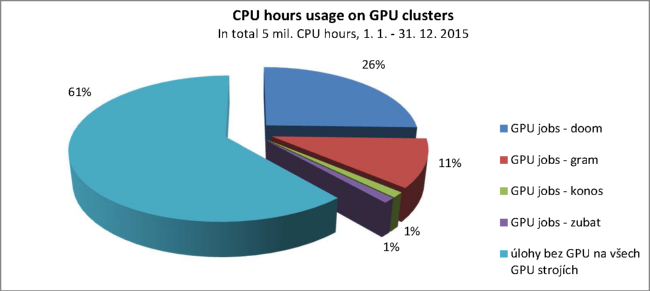

Rozdělení propočítaných CPU hodin na jednotlivých clusterech vystihuje následující graf. Ne-GPU úloh bylo 61 % z celkových 5 mil. CPU hodin. Nejvíce propočítaly GPU úlohy na clusteru doom (26 % celkového CPU času propočítaného na GPU strojích) a nejméně na clusteru konos a zubat (po 1 %). Cluster konos je nejstarší, s nejméně výkonnými GPU kartami. Cluster zubat je naopak nejnovější, daný do provozu až v průběhu prosince 2015.

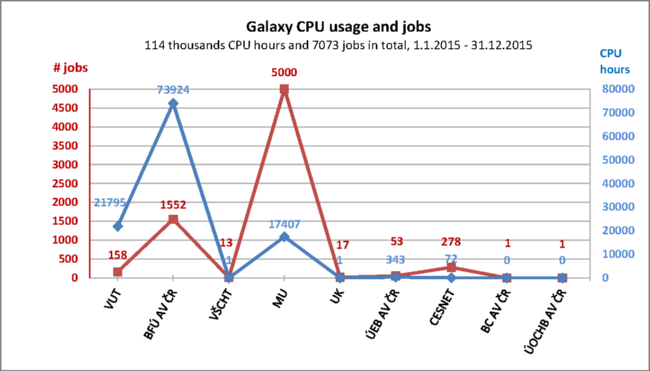

Přes webové rozhraní galaxy.metacentrum.cz bylo propočítáno 114 tisíc CPU hodin v 7 tisících úlohách. Alespoň jednu úlohu v portálu Galaxy spustilo 22 uživatelů MetaCentra z 9 organizací. Nejvíce Galaxy využívali uživatelé z Biofizikálního ústavu AV ČR a Masarykovy univerzity.

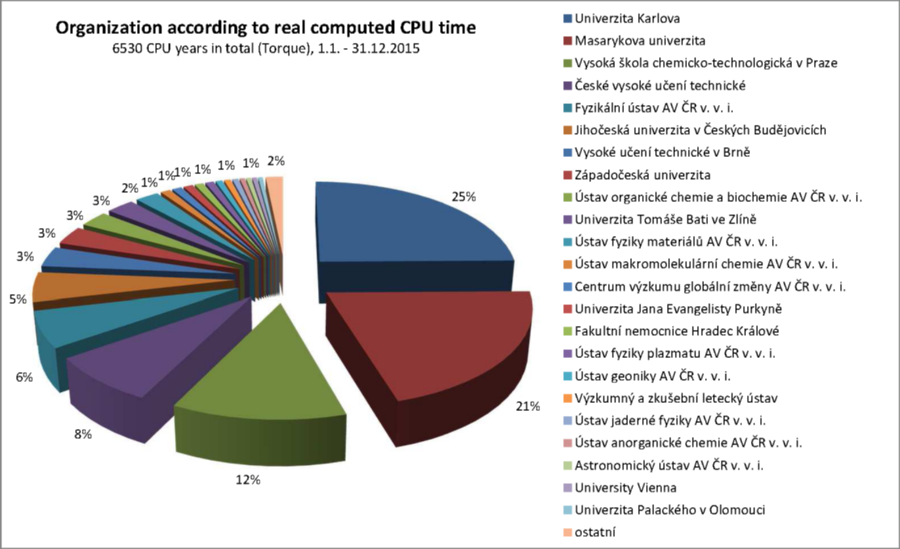

Propočítaný čas organizacemi na všech strojích zapojených v MetaCentru v dávkovém režimu (plánovací servery arien + wagap).

Propočítaný čas organizacemi na strojích centra CERIT-SC (plánovací server wagap).

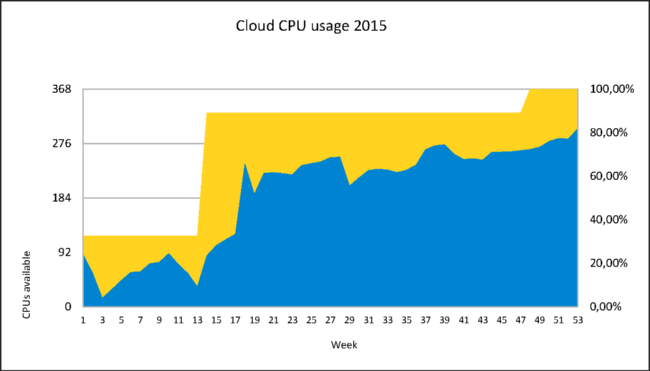

Na cloudových strojích MetaCentra (cluster dukan a warg) bylo v roce 2015 zkonzumováno více než 1100 CPU let. Cluster dukan.ics.muni.cz zahrnuje celkem 120 CPU jader (240 s HT), 10 uzlů po 4x 6-core Intel Xeon E5649 2.53GHz a 96 GB RAM. Cluster warg.meta.zcu.cz zahrnuje celkem 208 CPU jader (416 HT), 13 uzlů po 2x 8-core Intel Xeon E5-2650 v2 2.60GHz a 64 GB RAM. Následující graf ukazuje využití cloudových strojů po týdnech. Žlutá oblast označuje kapacitu k dispozici v daném období, modrá pak její zaplnění.

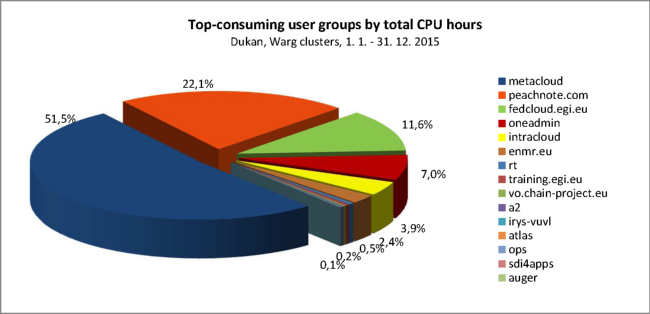

Cloudové stroje CESNETu využívali nejvíce uživatelé z virtuálních organizací MetaCloud (MetaVO 52 %), Peachnote (22 %), Fedcloud (12%) a Oneadmin (7%). Celkem cloud využívají uživatelé z 15 virtuálních organizací a skupin.

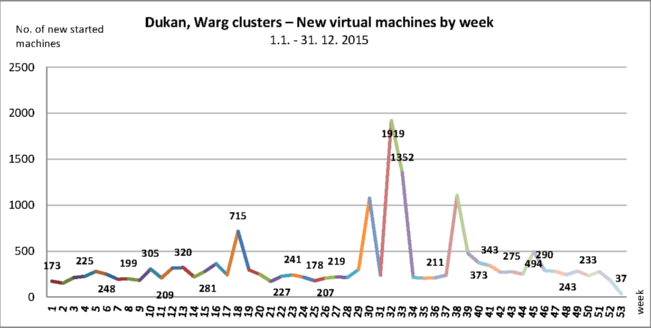

Počty nově spuštěných virtuálních serverů po týdnech ukazuje následující graf. Celkem bylo nastartováno na clusteru dukan 18200 virtuálních strojů, týdně pak průměrně více než 300.

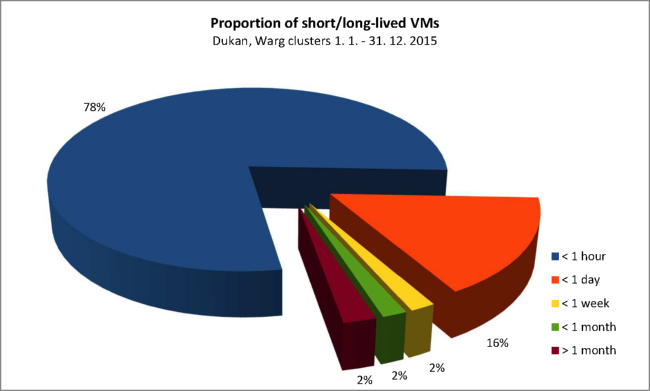

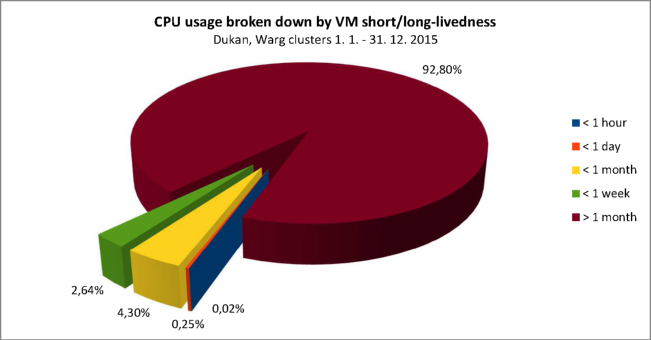

Krátkodobě běžící stroje spotřebovávají jen zlomek cloudové kapacity (CPU), nejvíce spotřebovávají dlouho běžící virtuální stroje. Konkrétně 78% (loni 90,8%) virtuálních strojů bylo spuštěno méně než hodinu, ale spotřebovaly jen 0,0 % (loni 0,1%) CPU času. Strojů běžících více než měsíc byla jen 2% (loni 1,4%), ale spotřebovaly 92,8% (loni 87,8%) CPU času.

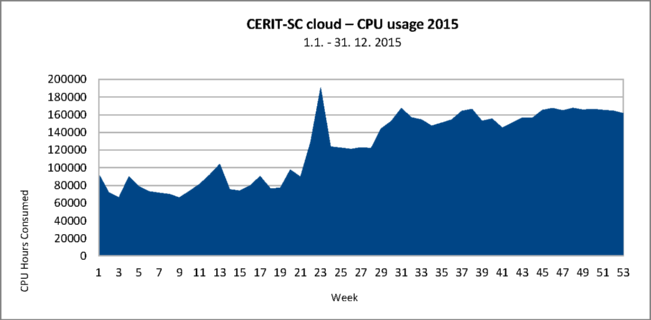

Na cloudových strojích CERIT-SC bylo v roce 2015 zkonzumováno více než 752 CPU let. Stroje ve vlastnictví centra CERIT-SC běží, díky důsledné virtualizaci, v obojetném režimu (cloud i Torque), počty jader se cloudu přidělují podle aktuální poptávky v obou prostředích. Využití cloudu je znázorněno na následujícím grafu.

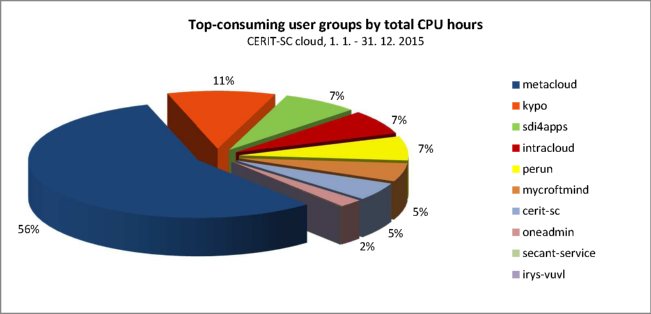

Cloudové stroje CERIT-SC využívali nejvíce uživatelé z virtuálních organizací MetaCloud (MetaVO 56 %), KYPO (11%), SDI4APPS (7%) IntraCloud (7%) atd., viz následující graf.

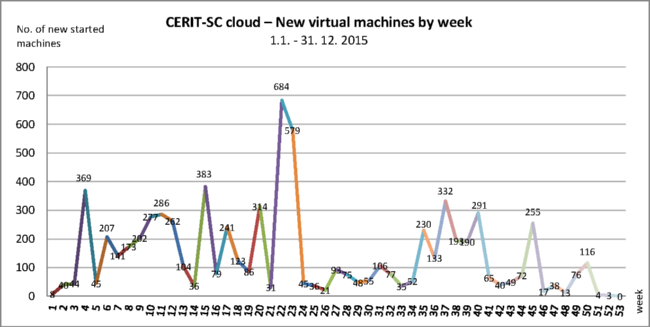

Počty nově spuštěných virtuálních serverů po týdnech ukazuje následující graf. Celkem bylo nastartováno na clusterech CERIT-SC 7474 virtuálních strojů, týdně pak průměrně více než 130.

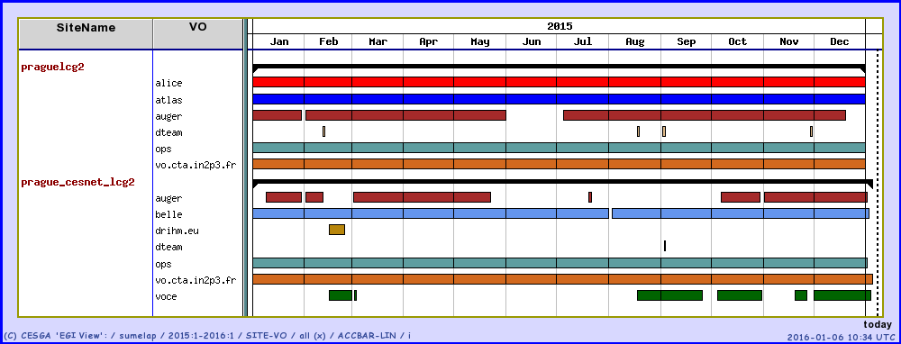

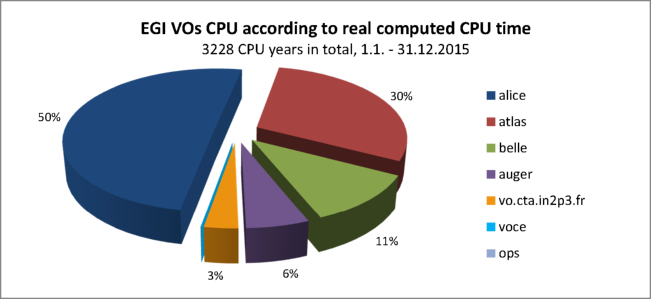

Do EGI jsme v roce 2015 poskytli celkem 3312 CPU jader. Z toho 2816 CPU jader poskytlo FZÚ AV ČR (pragelcg2) a 496 CPU jader poskytl CESNET (prague_cesnet_lcg2). Uživatelé z virtuálních organizací v EGI celkem propočítali 3228 CPU let, z toho 2788 CPU let na pragelcg2 a 440 CPU let na prague_cesnet_lcg2. Následující graf zobrazuje rozvrstvení výpočetních úloh jednotlivých virtuálních organizací v čase.

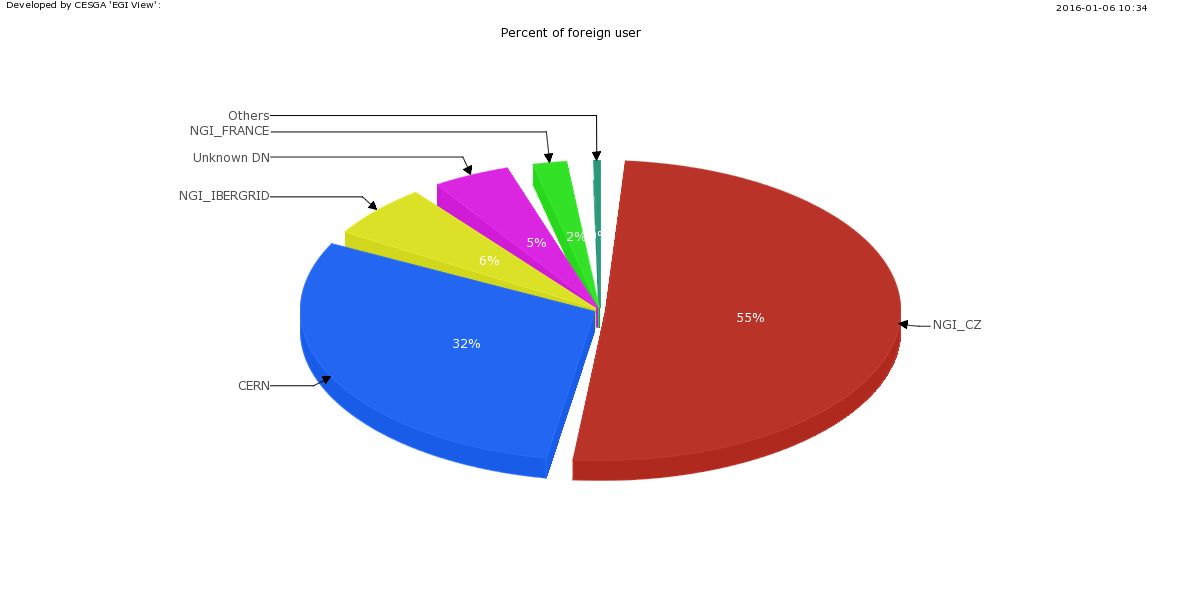

Na strojích propočítali domácí vědci z České republiky 55% celkově propočítaného času. Zbývajících 45% propočítali zahraniční uživatelé.

Nejvíce strojového času využily projekty ALICE, ATLAS, BELLE a AUGER.

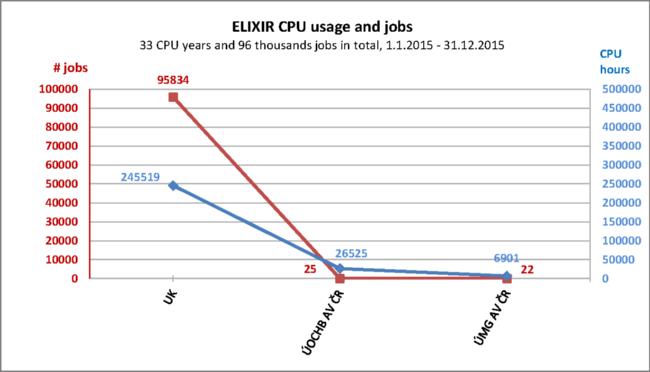

Pro VO ELIXIR spravujeme celkem 76 CPU jader umístěných na UOCHB AV ČR v Praze a PřF JU v Českých Budějovících a 100 TB diskové pole. Na clusterech se v roce 2015 propočítalo 33 CPU let v necelých 100 tisících úlohách.

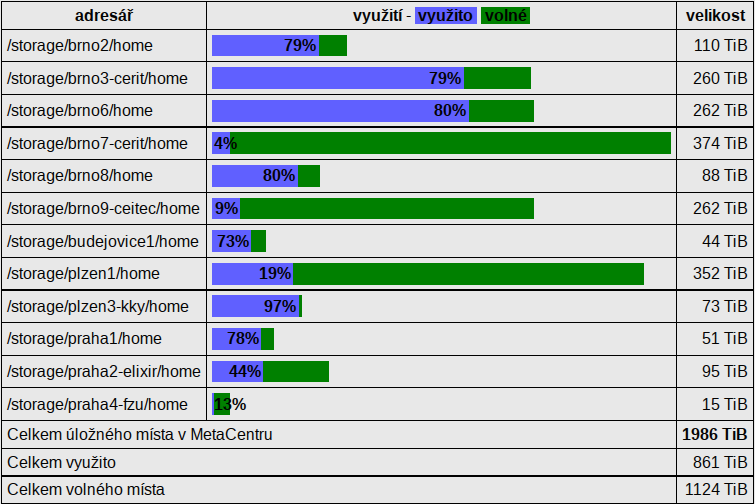

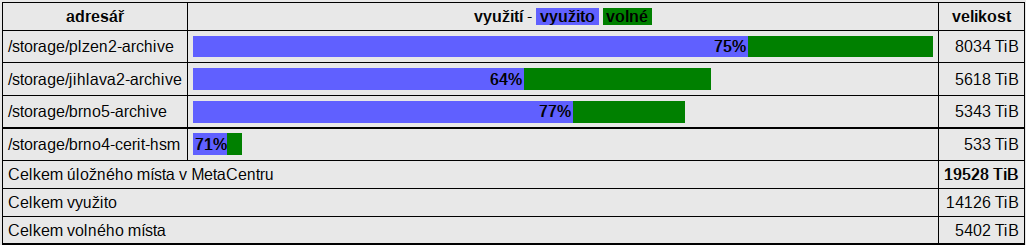

Meziročně opět vzrostlo zaplnění diskových polích v MetaCentru i v CERIT-SC. Mimo to, se podařilo integrovat diskové pole jiných vlastníků do infrastruktury MetaCentra (CEITEC, ELIXIR). Přístup na taková pole je dedikován vlastníkům, po dohodě s nimi může býrt přístupný i pro další uživatele.

Na prvním grafu je vidět míra zaplnění diskových polí, na dalším pak využití přidělených prostor na archivních úložištích typu HSM.