Statistiky provozu MetaCentra VO za období 1.1.2012 – 30.11.2012.

Následující přehled sumarizuje využití výpočetních i úložných zdrojů v MetaCentru k 31.12.2012. Data z předchozího roku jsou v závorkách.

K 30. 11. 2011 MetaCentrum VO eviduje 613 uživatelů s aktivním účtem (pro srovnání koncem roku 2010 to bylo 491 uživatelů). Z tohoto čísla bylo prodlouženo 301 účtů a díky aktivnímu náboru nových uživatelů na VŠ a ústavech Akademie věd ČR jsme v roce 2012 získali 312 nových uživatelů (v předchozím roce jen 177).

Alespoň jednu úlohu v tomto období spustilo 322 uživatelů, část uživatelů využívá registraci v MetaCentru pouze pro přístup k úložným kapacitám a dalším službám, část nikdy nebyla skutečně aktivní.

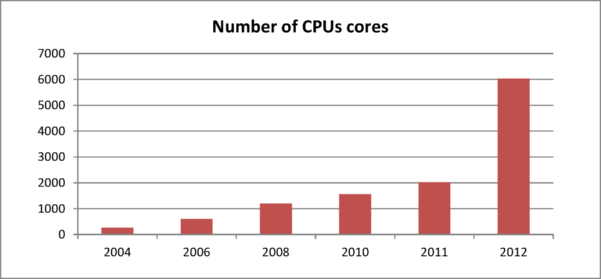

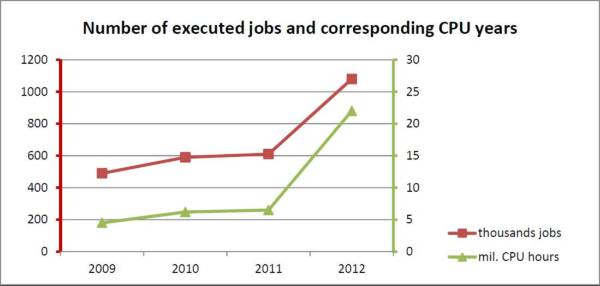

V období leden až prosinec 2012 uživatelé propočítali 22 milionů CPU hodin (2.5 tis. CPU let) ve více než milionu úloh. Ve srovnání s rokem 2011 trojnásobně narostl celkový propočítaný čas, což koresponduje s trojnásobným nárůstem dostupné výpočetní kapacity.

Je to silným důkazem, že masivní investice do nákupu výpočetních prostředků, na konci roku 2011 a především v roce 2012, koresponduje s nárůstem poptávky po výpočetní kapacitě ze strany uživatelů. Nárůst výpočetní kapacity ilustruje následující graf, který porovnává objem dostupných CPU jader v letech 2004 - 2012.

Kvantitativní skok ve výpočetní kapacitě mezi roky 2011 a 2012 jsme zaznamenali především díky projektům CERIT-SC, CEITEC (oba MU) a eIGer (CESNET) z operačních programy OP VaVpI ve druhé a třetí ose.

Na konci roku 2012 byli největšími vlastníky výpočetní kapacity CESNET (2600 CPU) a CERIT-SC (2200 CPU), kteří dohromady vlastnili 80% celkové výpočetní kapacity dostupné v MetaCentru. Další, menší vlastníci zdrojů jsou z řad dalších akademických nebo výzkumných institucí,většina těchto zdrojů je v přímé správě MetaCentra: NCBR/CEITEC, MU Brno (580 CPUs), Loschmidt Laboratories, MU Brno (260 CPUs), ZČU, Plzeň (140 CPUs), FEKT VUT, Brno (100 CPUs), Jihočeská univerzita, České Budějovice (100 CPUs), FZU, Akademie věd ČR, Prague (70 CPUs), Fakulta informatiky MU, Brno (60 CPUs).

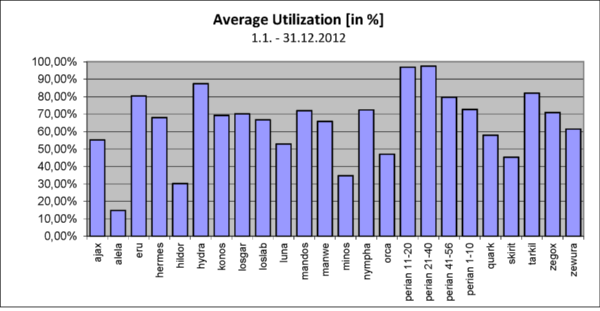

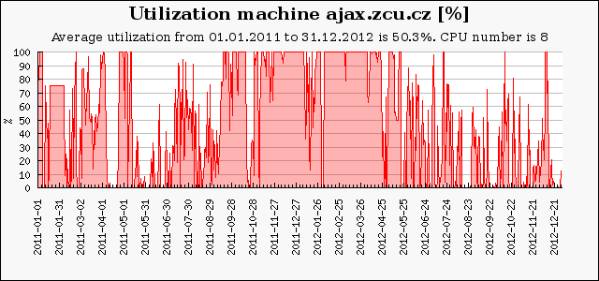

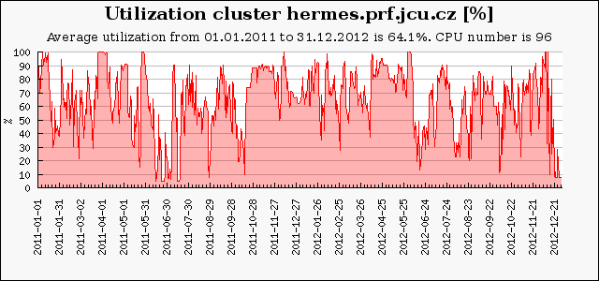

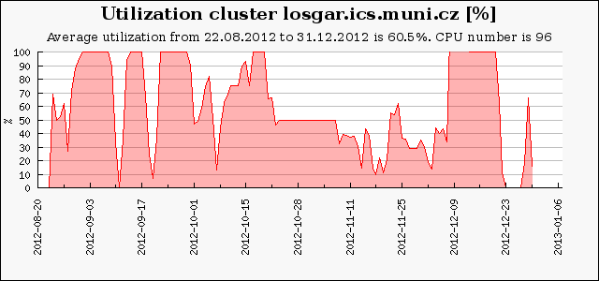

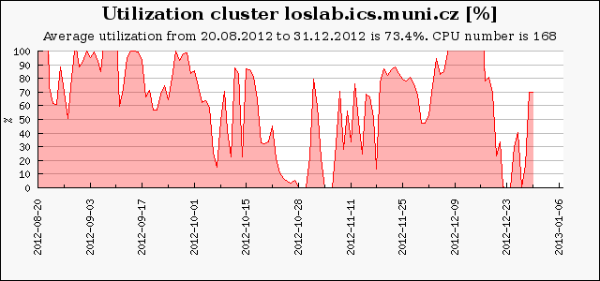

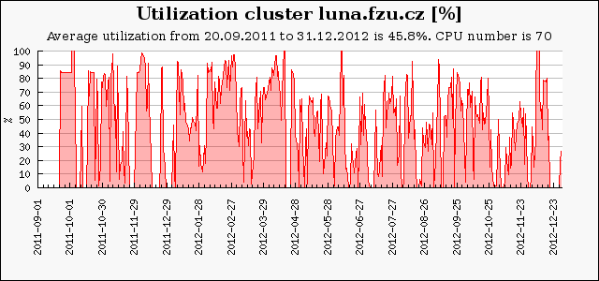

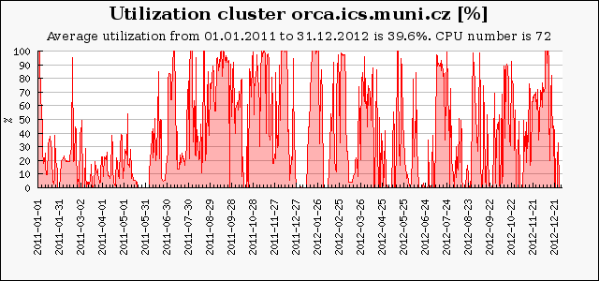

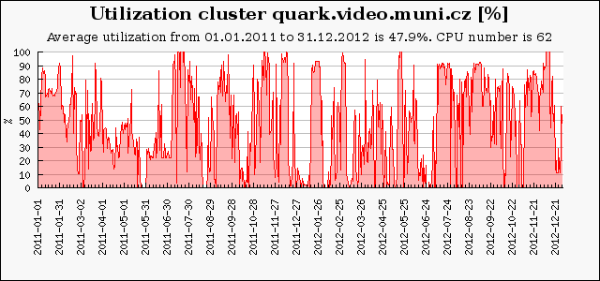

Následující graf ukazuje průměrné vytížení výpočetních clusterů a strojů v roce 2012. U některých zdrojů není započítaná část výpočetní kapacity, která byla přístupná experimentálním cloudovým rozhraním, ze kterého nemáme posbírána korektní provozní data. Základem pro výpočet průměrného vytížení (100%) je celkový počet dostupných CPU-core-seconds mínus počet CPU-core-seconds strojů, které nebyly v provozu. Rezervované stroje jsou započítané tak, jako by byly plně využity, bez ohledu na jejich skutečné využití.

Průměrné vytížení volně dostupných strojů v MetaCentru se pohybovalo mezi 60 a 95 %. Vytížení okolo 70% je optimální, vyšší vytížení již znamená faktickou saturaci a způsobuje delší doby čekání úloh ve frontě. Nižší hodnoty vytížení vykazují stroje, které byly do MetaCentra zapojeny až v průběhu sledovaného období nebo jsou vyhrazené pro některou skupinu.

Jako každý rok jsme zaznamenali největší zájem o nejnovější a nejvýkonnější stroje s dostatečně velkou pamětí. Na druhou stranu, plánování výpočetně náročných úloh požadující desítky CPU nebo stovky GB paměti je velmi náročné. Plánovací systém uvolňuje zdroje pro takové úlohy postupně a ty se jeví, až do spuštění velké úlohy, jako volné. Takové úlohy obvykle směřují na velké SMP sroje (mandos, zewura) s mnoha CPU jádry a velkou sdílenou pamětí, které pak vykazují, oproti klasickým HD clusterům, nižší průměrné vytížení.

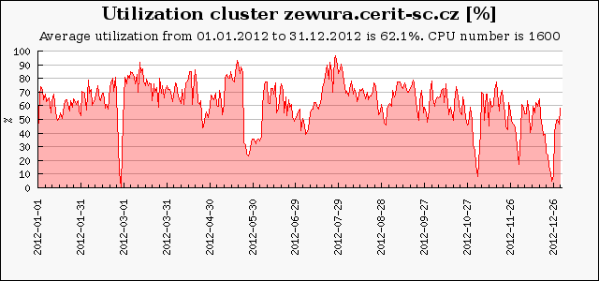

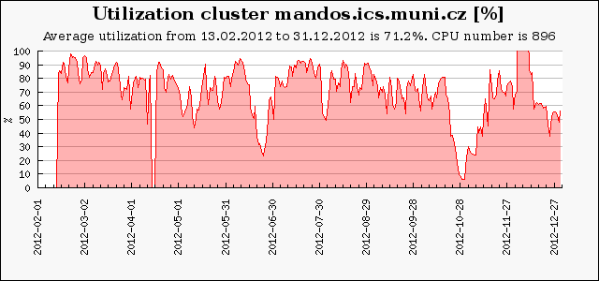

Zewura je se svými 1600 (20x80) CPU a sdílenou pamětí 512 GB na uzel největším clusterem v MetaCentru. Patří centru CERIT-SC (MU). Byla pořizovaná na etapy, menší část, 8 uzlů, byla pořízena v prosinci 2011, druhá část o půl roku později. Mandos je druhý největší cluster, má 896 (14x64) CPU jader a 256 GB RAM v každém uzlu. Zewura a Mandos reprezentují SMP-clustery (Symmetric MultiProcessing) s jedinou velkou sdílenou pamětí. Jsou vhodné pro aplikace s velkými paměťováými nároky nebo pro aplikace vyžadující větší počet procesorů komunikujících pomocí sdílené paměti.

SMP clustery velmi často rovněž obsadí úloha s velkým nárokem na paměť (stovky GB) a s požadavkem využití několika málo procesorů. Často se tak stane, že taková úloha obsadí celou paměť, využije jen část procesorů, ostatní se zdají být volné, ale na stroj už není možné naplánovat žádnou další úlohu z důvodu nedostatku paměti. Uzel se pak v accountingu jeví jako téměř nevyužitý - zaočítává se použitý čas, nikoliv paměť.

Využití clusteru Mandos byla o něco vyšší než u Zewury. Je to zapřičiněno dvěma důvody, uživatelé spouštěli na Zewurách paměťově náročné úlohy mnohem častěji, než na Mandosech. Navíc část Zewur byla k dispozici dodavateli k vyřešení HW problémů způsobujících nestabilitu a v důsledku odlišné metodiky výpočtu průměrného vytížení se neodečítaly uzly, které byly mimo provoz.

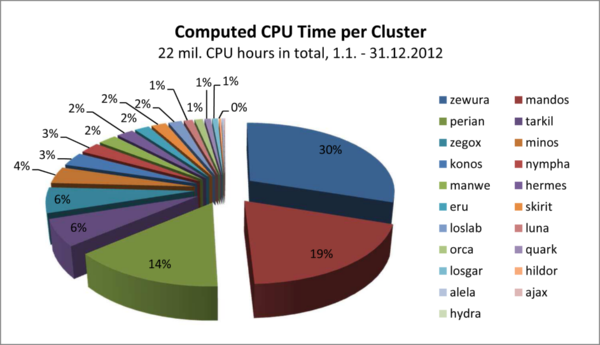

Následující graf ukazuje celkový propočítaný čas na jednotlivých clusterech v roce 2012. Je z něj patrný velký zájem o oba nové SMP clustery. Na Zewurách se propočítalo 30% na Mandosech téměř 20%, tj. skoro 50% celkově propočítaného času v uplynulém roce.

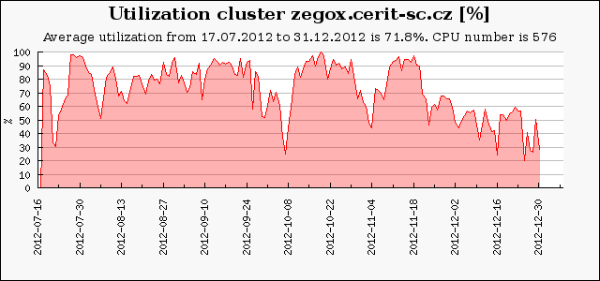

Zegox je druhý experimentální cluster centra CERIT-SC. Disponuje 576 (48x12) CPU jádry a 90GB RAM na každý uzel.Byl zprovozněn v polovině roku 2012. Je zajímavý tím, že je celý plně virtualizován, všechny nody jsou vloženy do OpenNebula cloudu a podle zájmu uživatelů se na něm spouštějí úlohy zadané z OpenNebula cloudu. Zbývající volné uzly jsou k dispozici plánavacímu systému Torque a jsou na nich spouštěny úlohy zadané dávkovým způsobem. V důsledku plné vyrzualizace a častého bootování image se pohybuje průměrné vytížení těsně nad hranicí 70%.

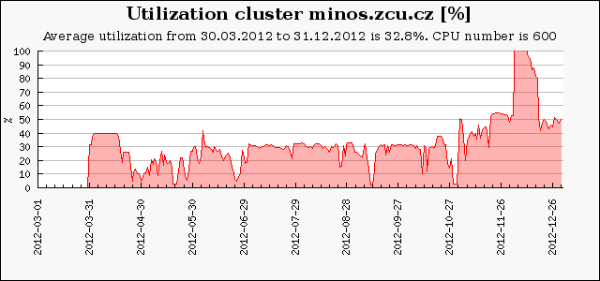

Minos je třetí největší cluster v MataCentru, disponuje 600 (50x12) CPU jádry a 24GB RAM na ukaždý zel. Byl částečně vyhrazen virtualizačním experimentům a část úloh nebyla započítána v accountingu. Průměrné využití je proto hluboce pod průměrem MetaCentra.

Clustery vlastněné výzkumnými skupinami vykazují obvykle nižší průměrné vytížení. Je to dáno tím, že na strojích vlastníků je nastavena obvykle prioritní fronta vlastníků a ostatní uživatelé mají na tyto zdroje přístup jen pomocí speciální fronty preemptible, ve ktere mohou být úlohy zamrazeny, odstěhovány jinam a znovu spuštěny až po doběhnutí prioritních úloh. O tuto frontu není příliš velký zájem ze strany ostatních uživatelů. Na některé zdroje mají přístup i krátké fronty, s délkou úloh do jednoho dne.

Na druhou stranu, výjimkou je cluster Perian vlastněný skupinou NCBR/CEITEC, který na některých částech dosahuje průměrného vytížení neuvěřitelných 95 %. Je to dáno především tím, že skupina je schopna celý cluster vytěžovat pernamentně a navíc, úlohy jsou odladěné přesně na počet CPU (nebo násobky) a paměť v uzlu tak, aby vždy bylo zajištěno optimální využití všech procesorů uzlu..

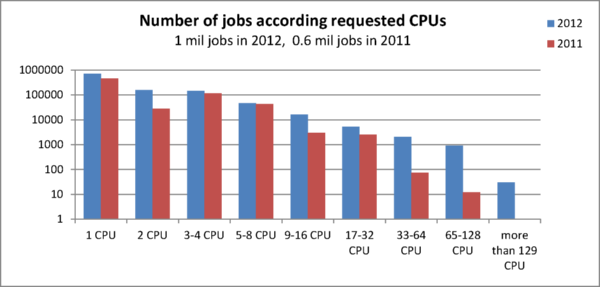

V roce 2012 uživatelé propočítali 22 milionů CPU hodin ve více než milionu úloh (609 tis. ve 2011). Ve srovnání s rokem 2011 trojnásobně narostl celkový propočítaný čas, počet úloh však vzrostl pouze 1,7 násobně.

Výše uvedené lze vysvětlit pomocí dalšího grafu. Meziročně došlo k výraznému nárůstu počtu paralelních úloh. V roce 2011 uživatelé zřídkakdy požadovali více než 16 CPU, což bylo dáno strukturou HW. Větší úlohy čekaly nepřiměřeně dlouho na spuštění a proto o ně nebyl tak velký zájem. V roce 2012 se situace změnila s nákupem SMP strojů. Uživatelé velmi rychle rozpoznali výhodu velkých SMP strojů a začali je používat především pro vysoce paralalení úlohy. Největší úlohy žádaly více než 500 CPU.

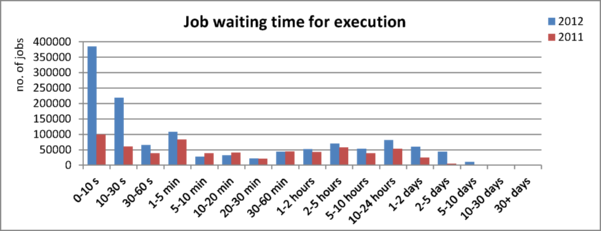

Nyní se podíváme na dobu čekáí úloh na spuštění. Z následujícího grafu je patrné, že většina úloh (více něž 65%) se v roce 2012 spustila do 60 vteřin. Téměř 80% všech úloh se rozběhlo do 24 hodin. I tak jsme ale zaznamenali, ve srovnání s předchozím rokem, nárust doby čekání nad 1 hodinu.

Tento nárůst je možné vysvětlit vyšší popularitou paralelních a MPI úloh, pro které musí plánovač rezervovat zdroje, které pak nemohou být využity. Dalšími důvody dlouhého čekání bývá neobvyklá či dokonce vzácná nebo neexistující kombinace požadovaných vlastností, překročení limitu počtu úloh na uživatele ve frontě (limity brání vyčerpání zdrojů jediným uživatelem), atd.

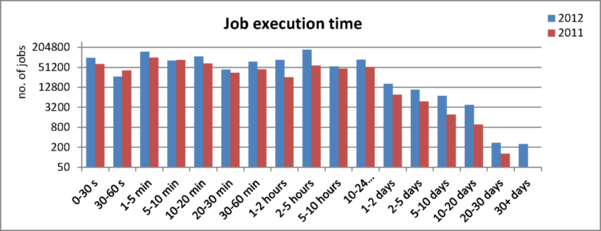

Následující graf ukazuje trend zvyšování délky běhu úloh oproti předchozímu roku. Měřítko osy Y (počet úloh) je logaritmické, ale i tak je velmi dobře patrný výrazný nárůst úloh s délkou trvání nad 1 den. Objevily se i úlohy nad 30 dnů, které jsou oblíbené na zdrojích centra CERIT-SC (Torque server wagap). Na ostatních zdrojích (Torque server arien) takto dlouhé úlohy nejsou povoleny.

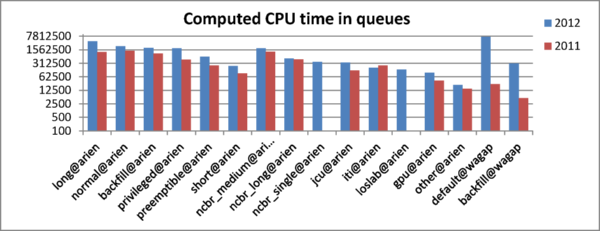

Podíváme-li se na využití jednotlivých front, podle propočítaného času jsou nejoblíbenější fronty long@arien a default@wagap. Ve frontě long se spouštějí úlohy s předpokládanou délkou trvání 24 hodin až 30 dnů.

Narozdíl od zvyklostí zbytku MetaCentra (arien), kde uživatelé úlohy posílají do front podle předpokládané doby trvání úlohy (short, normal, long, atd.), uživatelé CERIT-SC (wagap) všechny úlohy posílají do jediné defaultní fronty (kromě výplňových úloh nízkoprioritní fronty backfill) a zadávají jen parametr určující maximální dobu trvání úlohy. Plánovač pak podle této doby sám rozřazuje úlohy na jednotlivé zdroje.

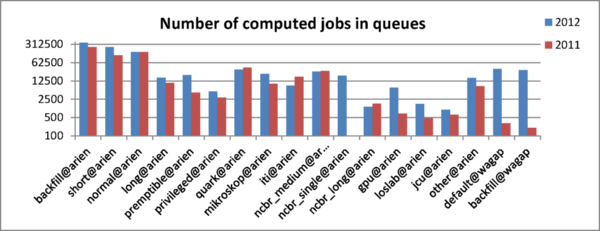

Co do počtu úloh je nejoblíbenější frontou backfill@arien, nízkoprioritní fronta pro tzv. výplňové úlohy, která je určena pro zadávání velkého počtu nenáročných úloh s délkou trvání do 24 hodin.

Úlohy z fronty bacfill vyplňují volné CPU na zdrojích, v případě nutnosti mohou být ze strany správců HW pozastaveny nebo ukončeny. Tato fronta je proto nastavena na většině strojích patřících výzkumným skupinám.

K 30. 11. 2012 MetaCentrum VO eviduje 613 uživatelů s aktivním účtem (pro srovnání koncem roku 2010 to bylo 491 uživatelů). Z tohoto čísla bylo prodlouženo 301 účtů a díky aktivnímu náboru nových uživatelů na VŠ a ústavech Akademie věd ČR jsme v roce 2012 získali 312 nových uživatelů (v předchozím roce jen 177). Alespoň jednu úlohu spustilo 322 uživatelů - oproti loňskému roku počet aktivně počítajících uživatelů výrazně narostl (240 v roce 2011). Na druhou stranu každoročně ztrácíme stovky uživatelů, především z řad absolvujících studentů. Dlouhodobě se nám však daří udržovat trvalý nárůst počtu uživatelů.

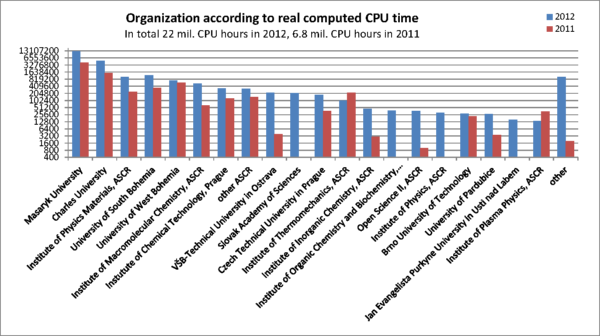

MetaCentrum využívají uživatelé 28 organizací a 14 ústavů Akademie věd. Následující graf ukazuje využití výpočetní kapacity MetaCentra jednotlivými institucemi podle propočítaného času.

Nejaktivnější uživatelé s největším propočítaným časem jsou z Masarykovy univerzity, propočítali dohromady více než 12 mil. CPU hodin, což představuje více než 50% celkově propočítaného času v MetaCentru. Z této instituce aktivně MetaCentrum využívá ořes 90 uživatelů, velká část z nich patří k vělkým výpočetním skupinám NCBR (část CEITECu) nebo Loschmidt laboratories. Obě skupiny zapojily do MetaCentra vlastní clustery, na kterých mají prioritní přístup, ale které jsou zároveň k dispozici ostatním uživatelům v méně prioritních frontách. Za MU následuje Karlova univerzita (32 živatelů, téměř 5 mil. CPU hodin), IPM AV ČR (15 uživatelů, 1 mil. CPU hodin), Jihočeská univerzita (15 uživatelů, 1 mil. CPU hodin, Západočeská univerzita (38 uživatelů, 730 Tis. CPU hodin).

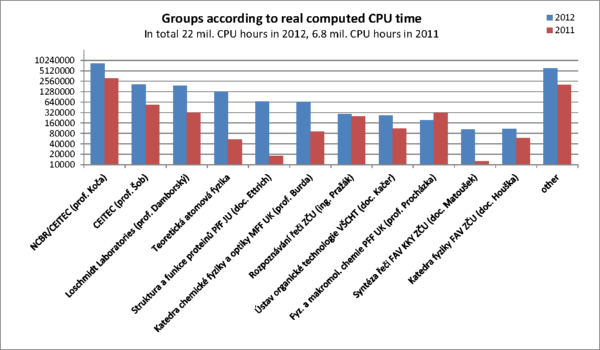

S výše uvedeným trendem koresponduje rozdělení propočítaného času ve výzkumných skupiných. Největší krajíc z propočítaného času vykousla opět NCBR/CEITEC (8,4 mil. CPU hodin, 38 %), následuje část CEITECu vedená profesorem Šobem (2,1 mil. CPU hodin, 10%) a Loschmidt Laboratories PřF Masarykovy univerzity (1,9 mil. CPU hodin, 9%).

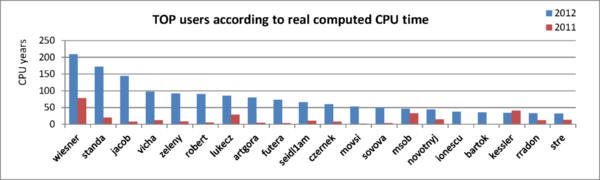

Prvních 10 uživatelů s největším propočítaným časem propočítalo více 10 mil. CPU hodin (téměř 50% celkového výpočetního času celého MateCentra) v téměř 800 tisíc úlohách (téměř 70% všech úloch). Mezi těmito nejaktivnějšími uživateli jsou 4 uživatelé z NCBR/CEITEC, 2 z Loschmidt Laboratories (obě skupiny fungují na Přirodovědecké fakultě Masarykovy univerzity).

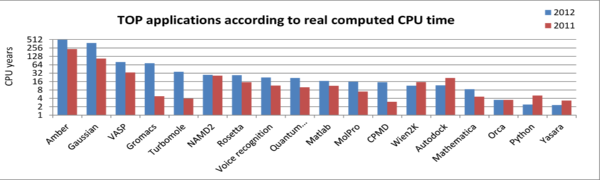

Většina z applikací, uvedených v následujícím žebříčku nejpoužívanějších aplikácí v MetaCentru, spadá do kategorie LifeScience. Některé z uvedených aplikací jsou vlastní aplikace vytvořené uživateli.

Celková kapacita datového úložiště byla 600 TB na 5 polích a 3 lokalitách (124 TB v loňském roce). Jedno z brněnských diskových polí patří CERIT-SC (260 TB), zbytek je ve vlastnictví CESNETu.

Uživatelská data zabírají cca 380 TB (tj. 60 % celkové kapacity datového úložiště) ve 233 milionech souborů (pro srovnání loni jen 155 milionů souborů). Všechna disková pole jsou přístupná prostřednictvím svazku /storage.