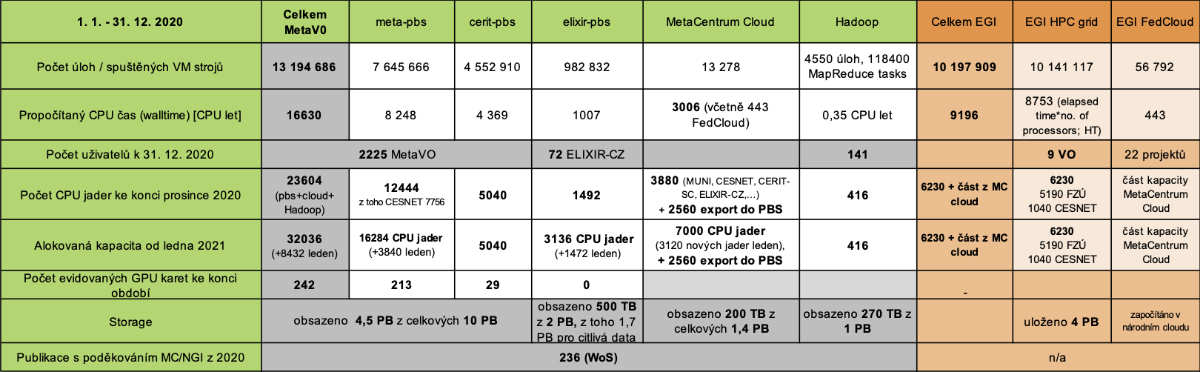

MetaCentrum mělo na konci roku 2020 2225 uživatelů s aktivním účtem. Pro srovnání, koncem roku 2019 mělo v MetaCentru účet 2185 uživatelů. Ke cloudovému prostředí MetaCloud bylo registrováno 470 (258 v 2019) projektových skupin uživatelů z českých akademických a výzkumných institucí a 22 1ze zahraničí. Do prostředí Hadoop mělo přístup 141 (162) uživatelů.

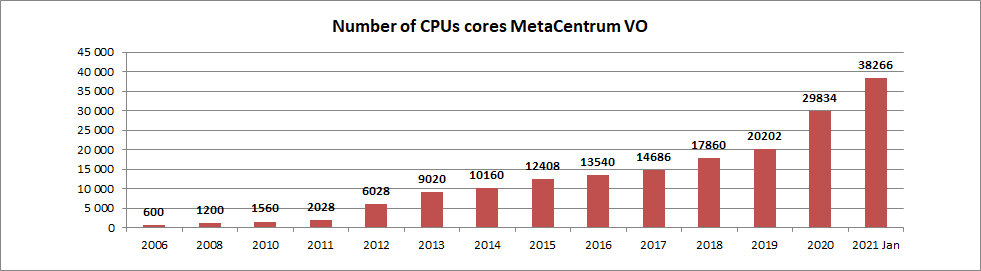

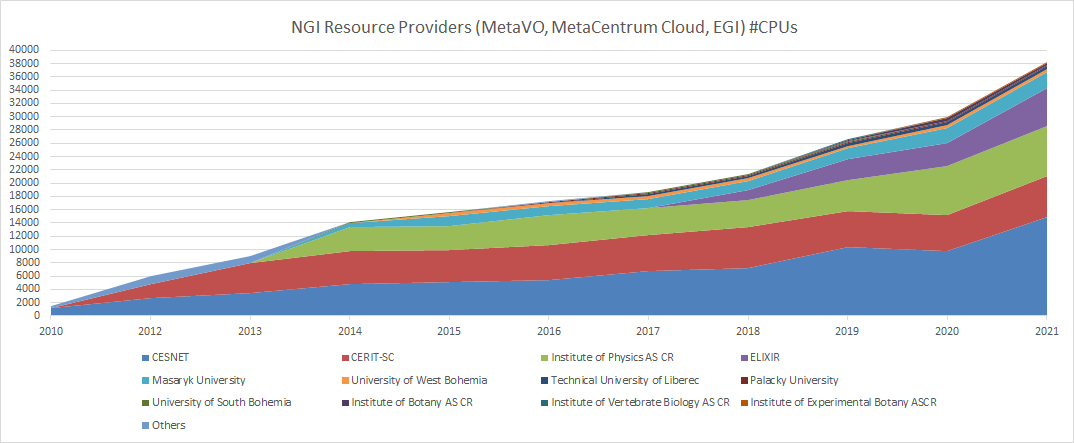

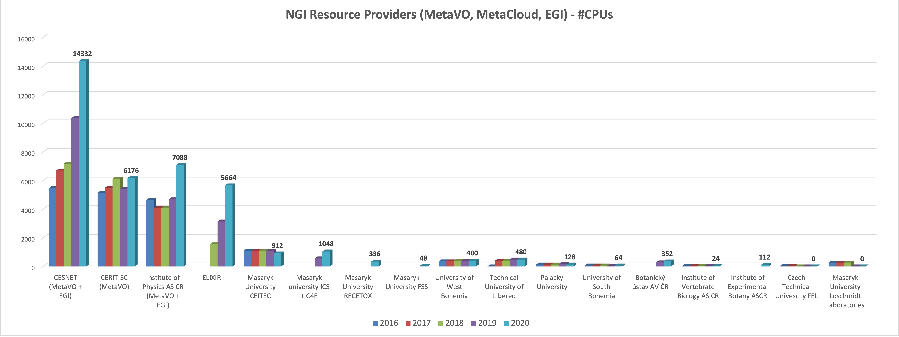

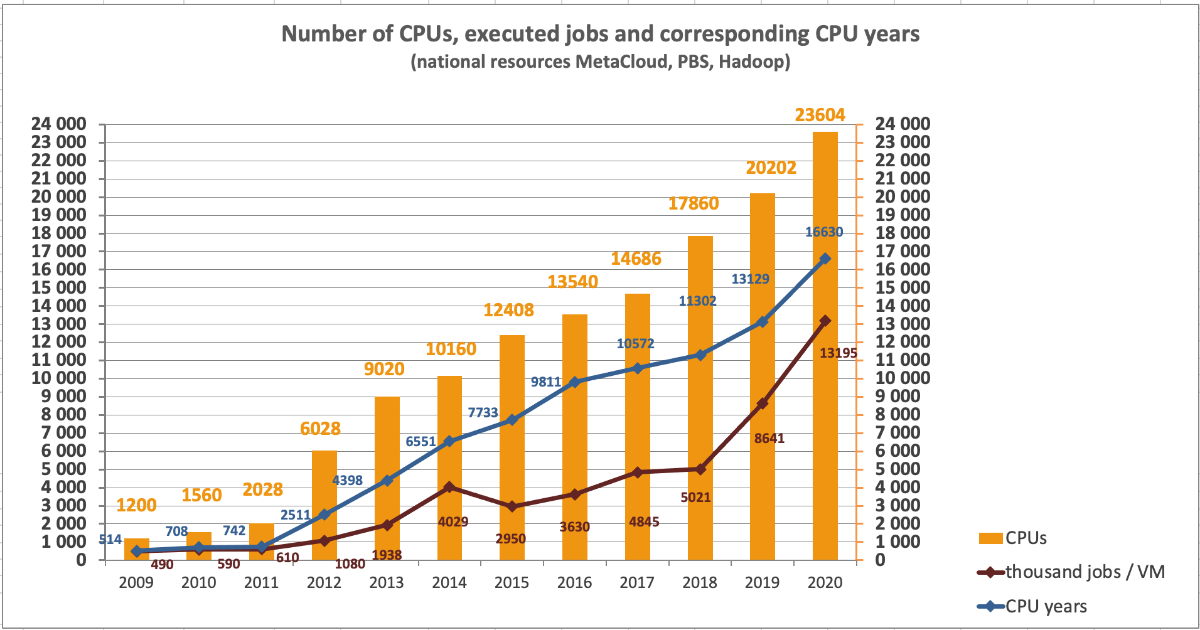

Meziročně vzrostl počet CPU jader pořízených v národním výpočetním prostředí MetaVO (grid + cloud) na 32036 CPU jader (vloni 22334), z toho 13876 CPU jader patřilo CESNETu (bez EGI) a 6176 CPU jader Centru CERIT-SC. Zbývajících 11984 CPU jader (bez EGI) vlastnily univerzity, Akademie věd ČR a velké projekty. Z toho 8432 CPU jader bylo pořízeno až koncem roku 2020 a bude zprovozněno v průběhu ledna 2021.

Dalších 6230 CPU jader bylo k dispozici v mezinárodním prostředí EGI. V dávkovém režimu (HTC) byly zapojené zdroje CESNETU (1040 CPU jader) a FZÚ AV ČR (5190 CPU jader) a část kapacity MetaCentrum Cloudu bylo k dispozici v EGI FedCloudu.

V roce 2020 uživatelé MetaVO a MetaCentrum cloudu propočítali celkem 16630 CPU let (13129 v roce 2019).

PBS

celkem PBS 13624 CPU let, 13,2 mil. úloh

MetaCentrumCloud

celkem 5701 CPU let, instancí 13544 (včetně FedCloud)

Mezinárodní výpočetní infrastruktuře EGI

celkem 8196 CPU hodin, 10197909 úloh/virtuálních strojů (zdroj EGI accounting portál)

V MetaCentrum NGI jsou zapojeny tři skupiny zdrojů.

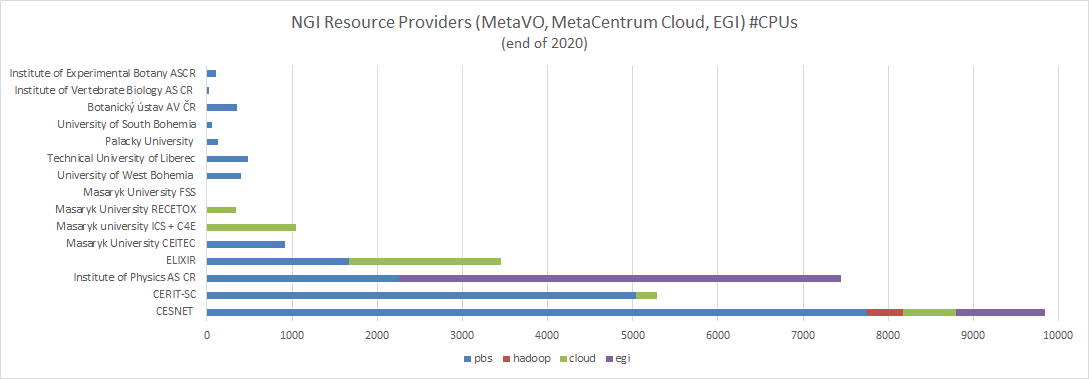

Rozdělení výpočetních zdrojů mezi výpočetními centry (vlastníky HW). První graf ukazuje stroje běžící na konci roku 2020.

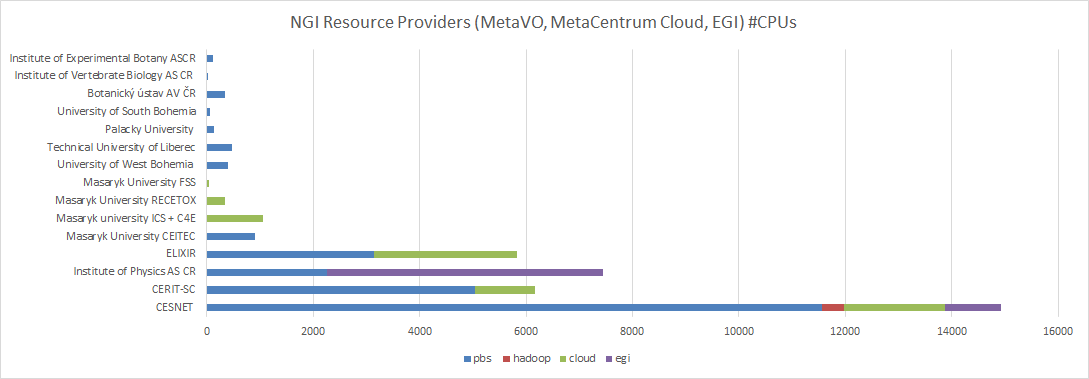

Následující graf zahrnuje, oproti grafu předchozímu, stroje také zakoupené na konci roku 2020 a zprovozněné až na začátku roku 2021.

Celkem 38266 CPU jader (prosinec 2020), z toho 8432 CPU jader pořízeno koncem roku a zprovozněno v lednu 2021

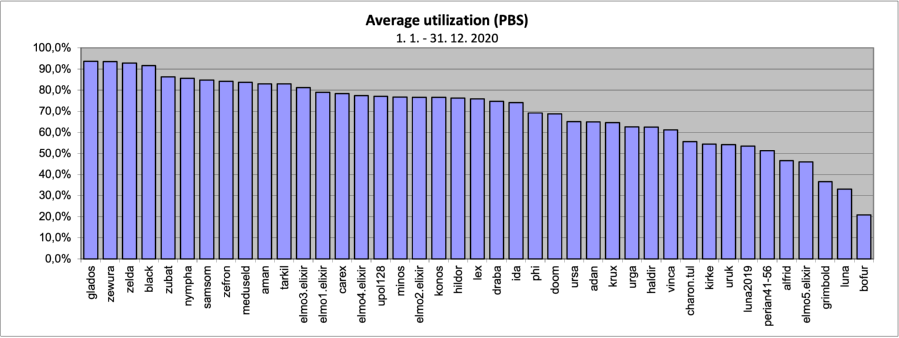

Následující graf ukazuje průměrné vytížení výpočetních clusterů a strojů v MetaVO v roce 2019. Základem pro výpočet průměrného vytížení (100%) je celkový počet dostupných CPU-core-seconds mínus počet CPU-core-seconds strojů, které nebyly v provozu. Rezervované stroje jsou započítané tak, jako by byly plně využity, bez ohledu na jejich skutečné využití. Údaj v závorce udává počet CPU v clusteru na konci roku. Nula značí, že cluster byl v průběhu roku vyřazen.

Průměrné vytížení volně dostupných strojů v MetaCentru se pohybovalo v roce 2020 mezi 65 a 95 %. Vytížení okolo 70% je optimální, vyšší vytížení již znamená faktickou saturaci a způsobuje delší doby čekání úloh ve frontě. Nižší hodnoty vytížení vykazují stroje, které byly do MetaCentra zapojeny až v průběhu sledovaného období nebo jsou unikátní, vyhrazené pro specifický typ výpočtů nebo vyhrazené pro některou skupinu.

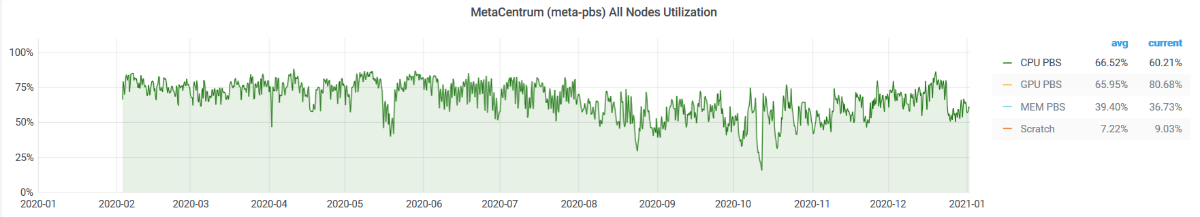

Vytížení strojů zapojených v meta-pbs v průběhu celého roku 2020. Průměrné vytížení se pohybovalo okolo 66 %. Do průměru jsou započítany všechny výpočetní clustery, i ty, které jsou vyhrazeny s přednostním právem vlastníkům a jejichž vytížení obvykle bývá nižší.

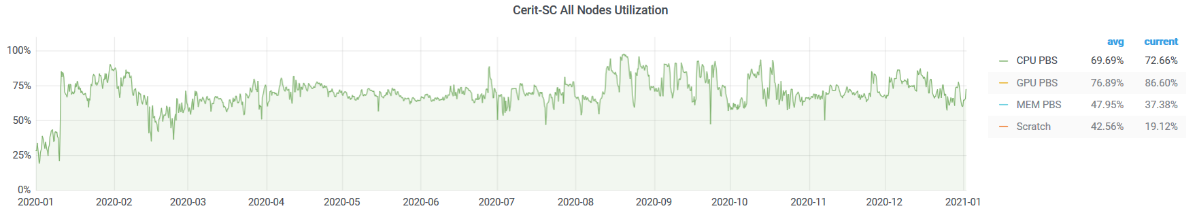

Vytížení strojů zapojených v cerit-pbs v průběhu celého roku 2020. Průměrné vytížení všech strojů (průměř přes všechny stroje) se pohybovalo okolo 70 %. Průměrné vytížení jednotlivých strojů je znázorněné na druhém grafu. Speciální stroje (XeonPhi -- phi a UV stroje -- urga, ursa, uruk) mají vytížení nižší.

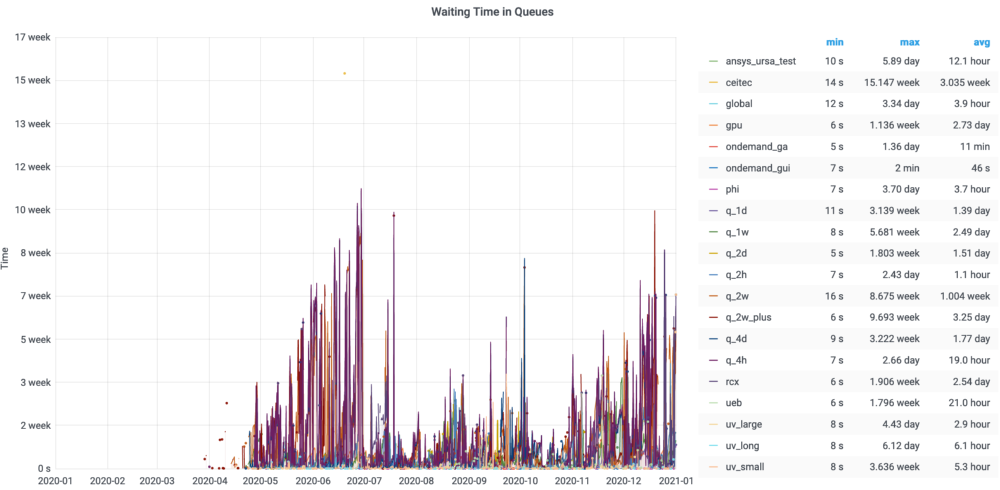

Doba čekání úloh na spuštění v jednotlivých frontách PBS cerit-pbs. Jsou započítané i úlohy, které nemohly být spuštěné kvůli chybě v zadání ma byly odstraněny až po delší době čekání.

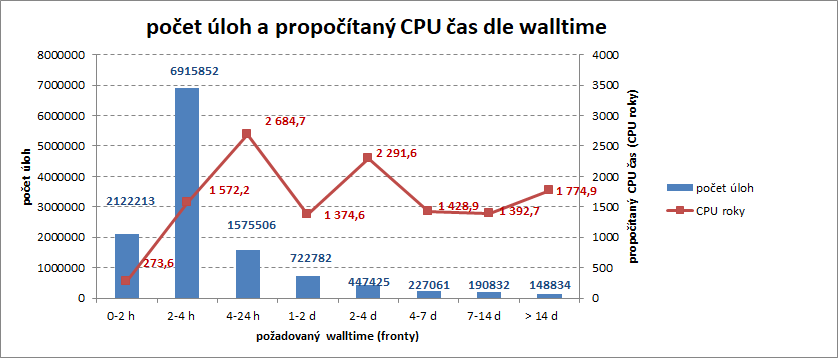

Rozložení počtu úloh dle požadované doby běhu úlohy (walltime) ukazuje, že nejvíce úloh běželo do 4 hodin. Delších úloh bylo na počet méně, ale propočítaný čas byl srovnatelný s propočítaným časem kratších úloh.

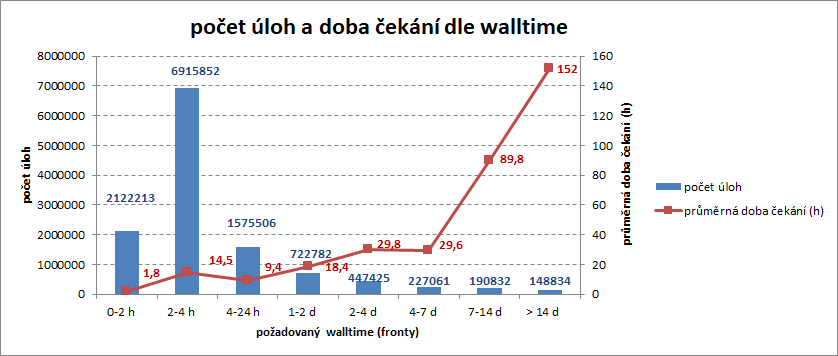

Rozložení průměrné doby čekání na spuštění úlohy dle požadované doby běhu ukazuje, že krátké úlohy čekaly krátce a dlouhé úlohy čekaly déle, což svědčí o správném nastavní plánovače.

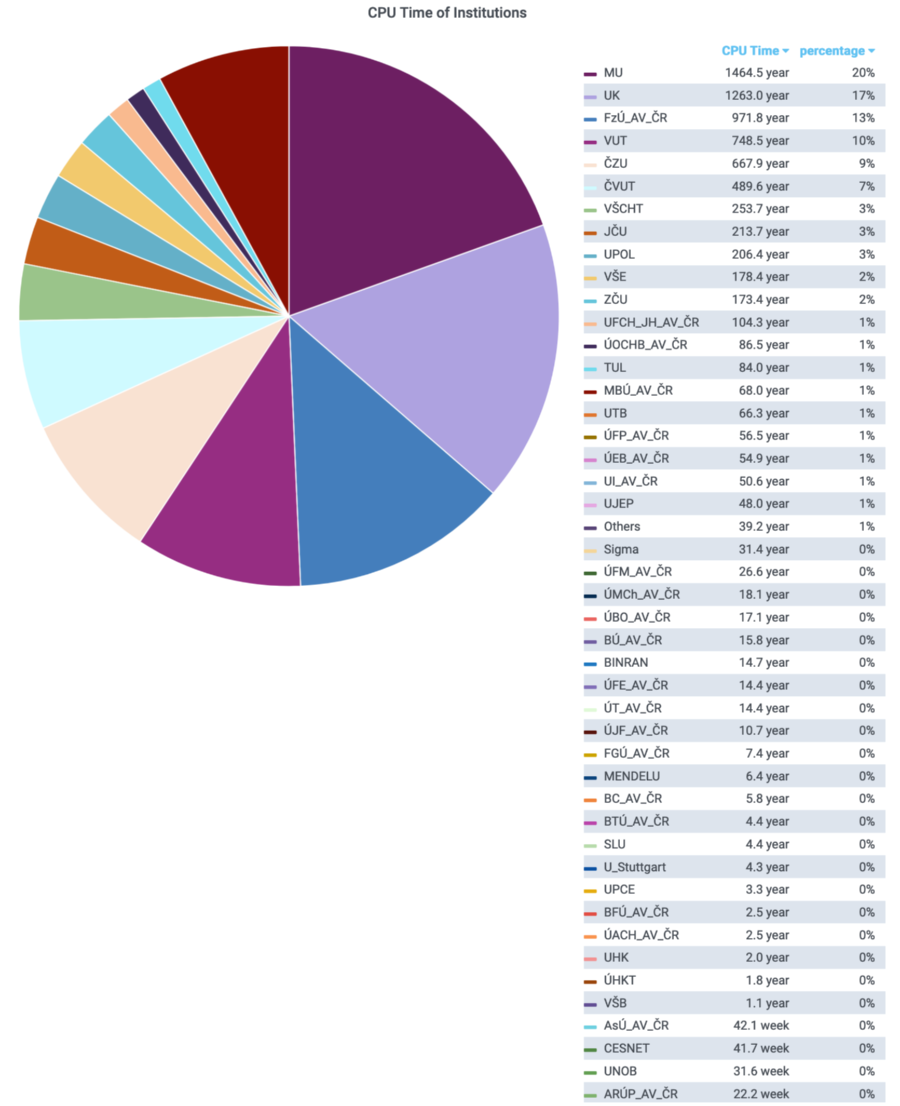

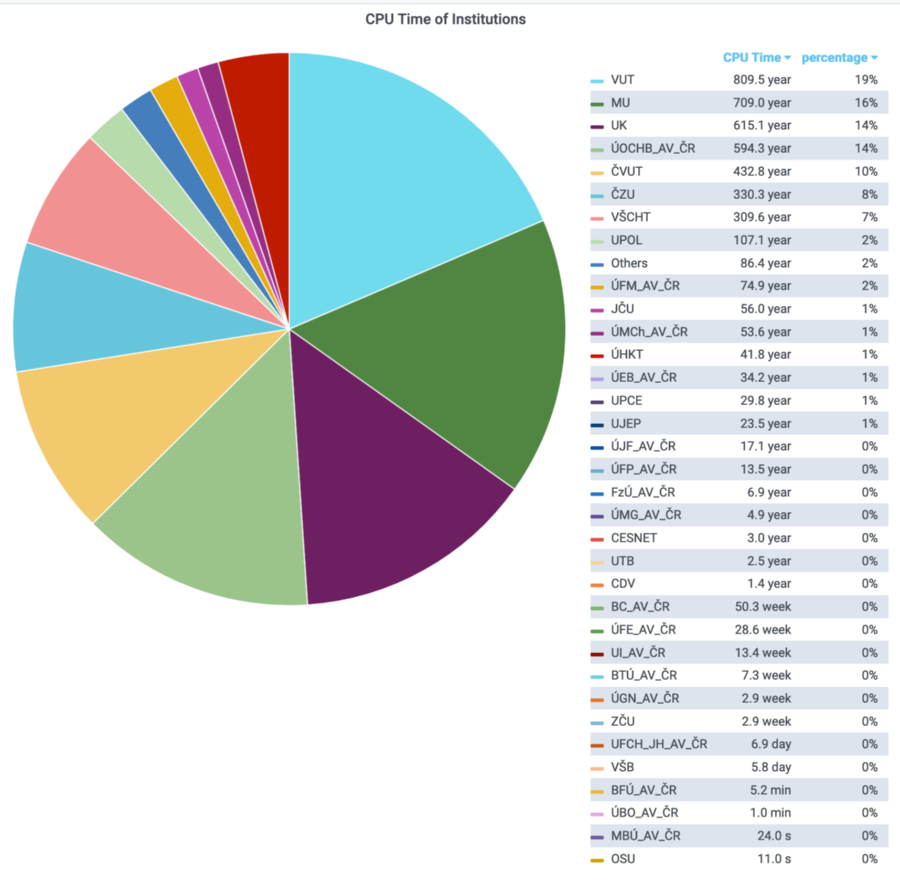

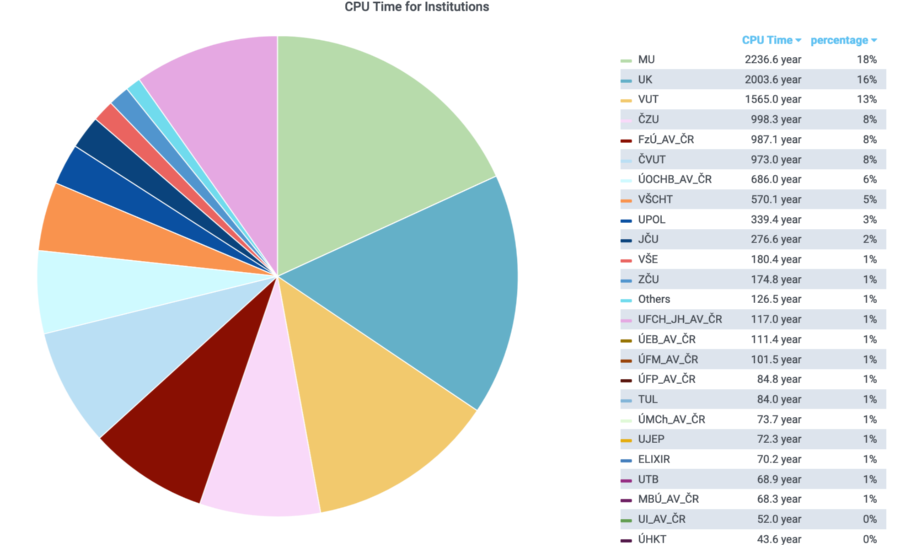

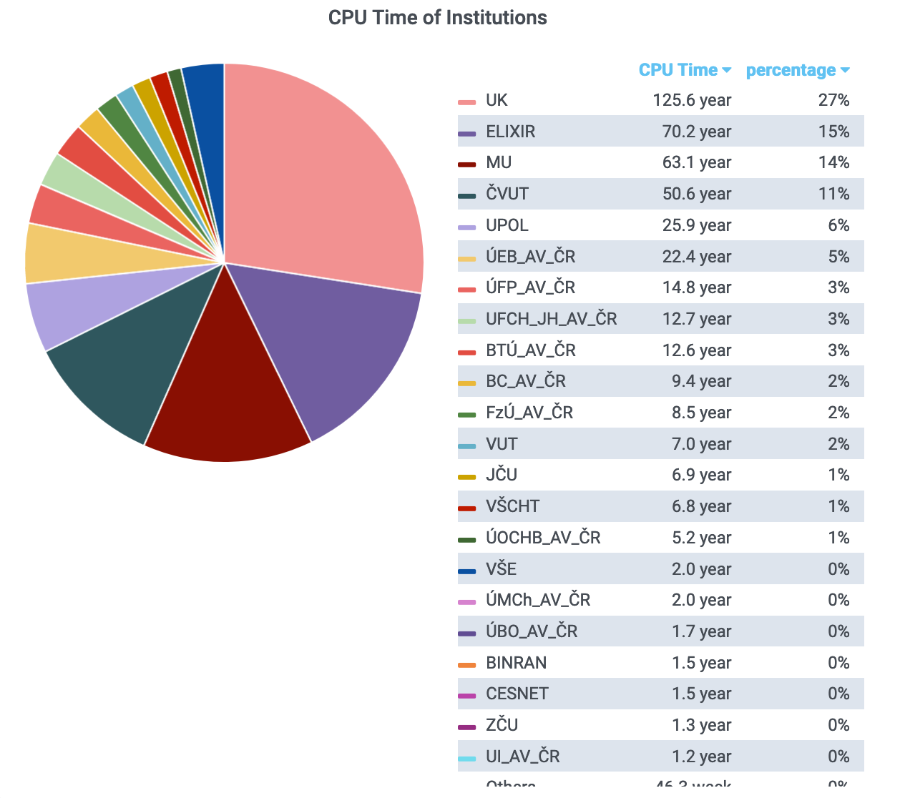

Využití MetaCentra organizacemi (Meta VO, PBS) dle propočítaného času

PBS server meta-pbs

PBS server cerit-pbs

PBS servery meta-pbs + cerit-pbs + elixir-pbs

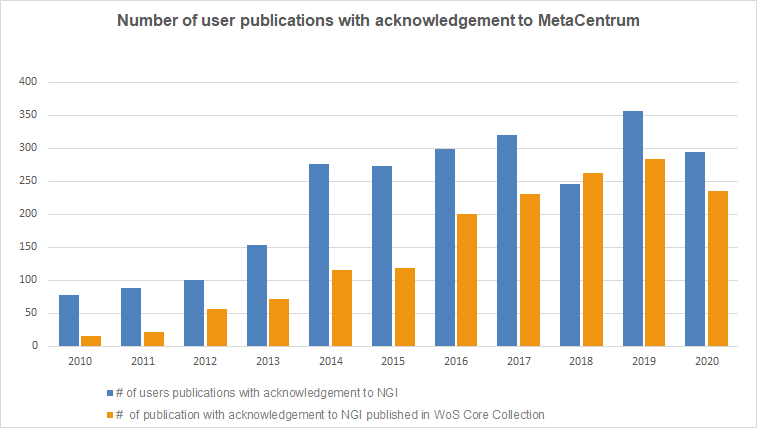

Následující graf ukazuje počty uživatelských publikací s poděkováním e-infrastruktuře vykázaných v systému Perun (modrý sloupec) a převzatých z veřejné databáze Web of Science (WoS, oranžový sloupec). V Perunovi evidujeme všechny typy publikací, včetně publikací neimportovaných do RIVu, proto jich je více než publikací evidovaných v databázi WoS, ve které jsou zahrnuté pouze kvalitní bodované publikace. Za rok 2020 byla data k publikacím posbírána koncem ledna, předpokládáme nárůst v počtu publikací vykázaných v roce 2020, uživatelé je do systému Perun v kládají až s výroční zprávou. Také ve WoS se některé publikace z konce roku objevují se zpožděním.

TOP organizace dle počtu publikací s poděkováním MetaCentru /CERIT-SC/e-INFRA za využití infrastruktury (zdroj WoS, rok 2020)

TOP uživatelské publikace s poděkováním podle vědních oborů (zdroj WoS, rok 2020)

Report citací z let 2013-2021, zdroj WoS, leden 2021

![Web of Science [v 5 35] - Citation Report](/export/sites/meta/images/statistiky/2020images/Web_of_Science_xv_5_35x_-_Citation_Report.png_1380299536.png)

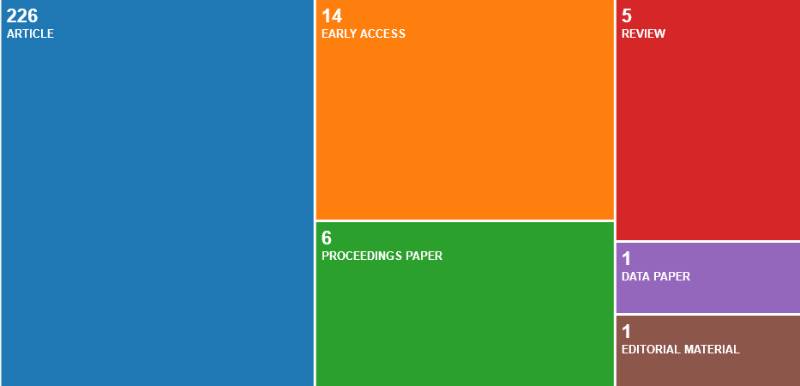

Typy uživatelských publikací s poděkováním (zdroj WoS, rok 2020)

Seznam publikací s poděkováním MetaCentru (2020, zdroj WoS)

V MetaCentrum Cloud bylo ke konci měsíce k dispozici celkem 9560 CPU jader, z toho 3120 CPU jader bylo pořízeno koncem roku 2020 a bude dáno do provozu v průběhu ledna 2021 a 2400 jader bylo k dispozici výhradně prostřednictvím PBS a v následujících statistikách nejsou zohledňovány. V čistě cloudovém režimu bylo koncem roku 2020 v provozu 4040 CPU jader.

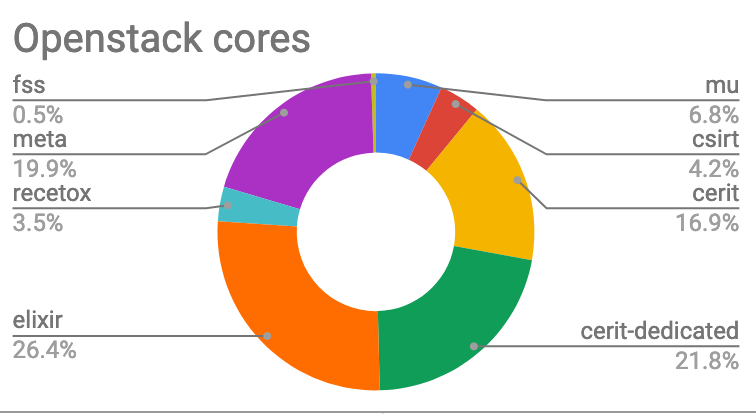

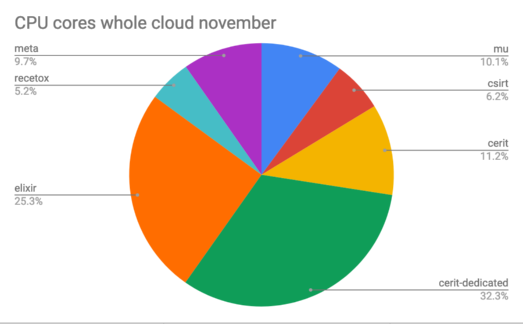

Rozdělení jader v OpenStacku podle vlastníků (započítáno všech 9560 CPU jader): Největší část kapacity 37 % (3536 CPU jader) patří centru CERIT-SC, 28% (2688 CPU jader) patří projektu ELIXIR-CZ, 20 % (1904 CPU jader) patří CESNETu, Ústav výpočetní techniky MUNI vlastní 644 CPU jader, 400 CPU jader patří projektu C4E, 336 CPU jader RECETOXu a 48 CPU jader vlastní FSS MUNI.

Jsou zde započítaná jádra (3120), která byla pořízená na konci 2020, ale zprovozněna budou až na začátku následujícího roku. Na prvním obrázku je celkový poměr počtu jader po započítání veškerého pořízeného HW, na druhém pak podíl pouze zapojeného HW.

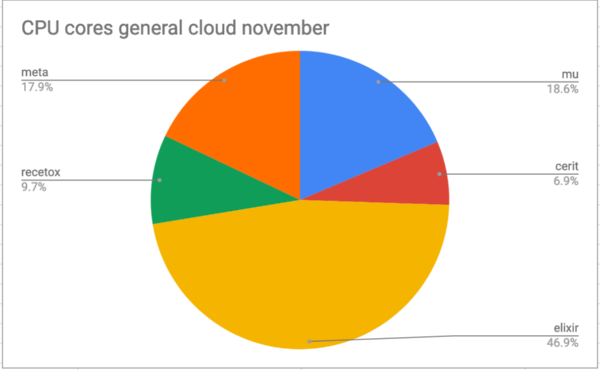

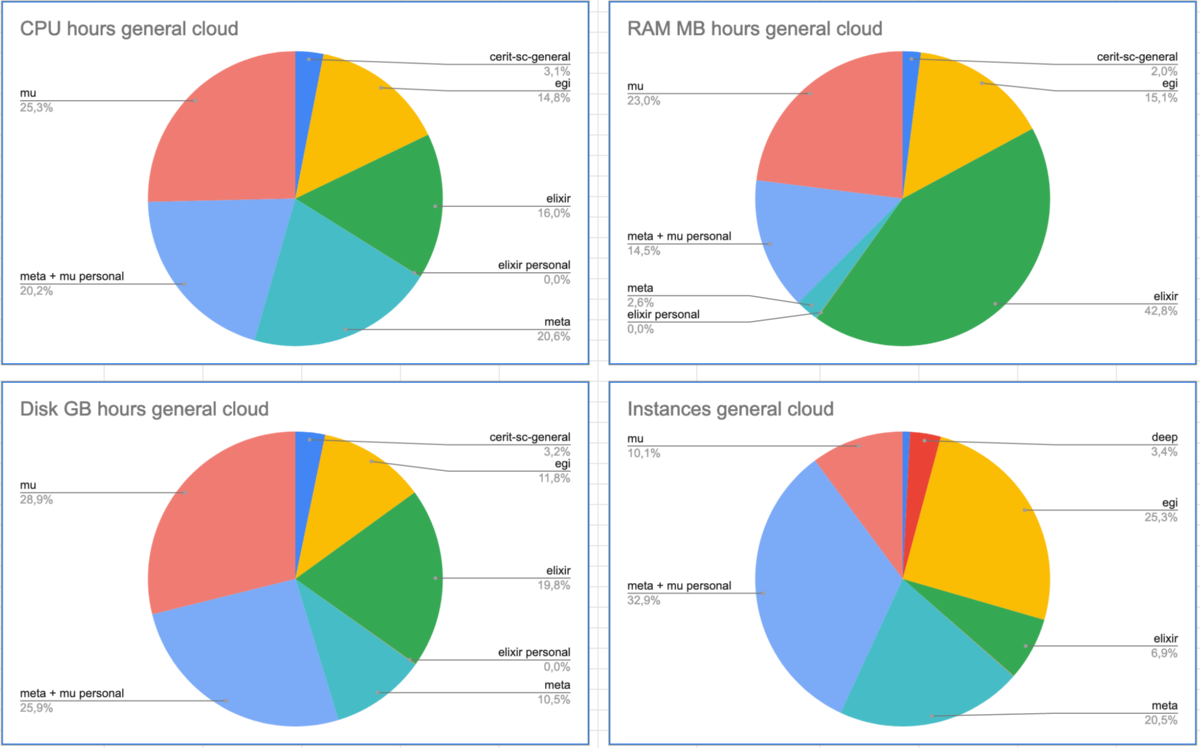

Následující graf ukazuje rozdělení zdrojů v obecně přístupném cloudu, po odečtení dedikovaného HW projektům vlastníků (csirt, cerit-dedicated).

V prostředí MetacentrumCloud bylo propočítáno 3006 CPU let (1468 CPU let v roce 2019) na 13278 (12 tis. v loňském roce) virtuálních strojích.

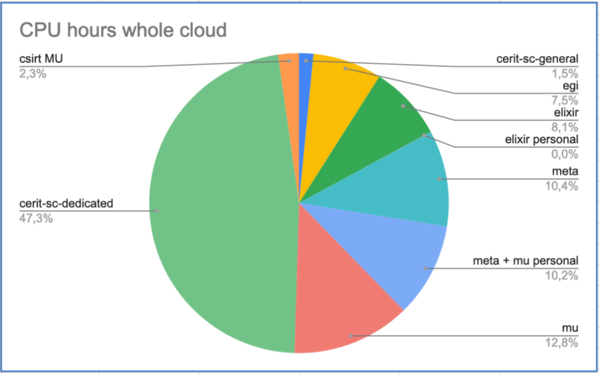

Celkový počet přidělených CPU hodin pro jednotlivé typy projektů, včetně těch dedikovaných.

Celkový počet přidělených CPU hodin, RAM, disků pro jednotlivé typy projektů v kategorii general (bez dedikovaných).

Na GPU kartách bylo propočítáno 273 tis. GPU hodin. Koncem roku 2020 bylo k dispozici 34 karet Nvidia 1080(2080) a 1 GPU karta Nvidia Titan.

Uživatelé založili 470 projektů a vedle toho běžely stovky individuálních instancí.

Největší uživatelé cloudu:

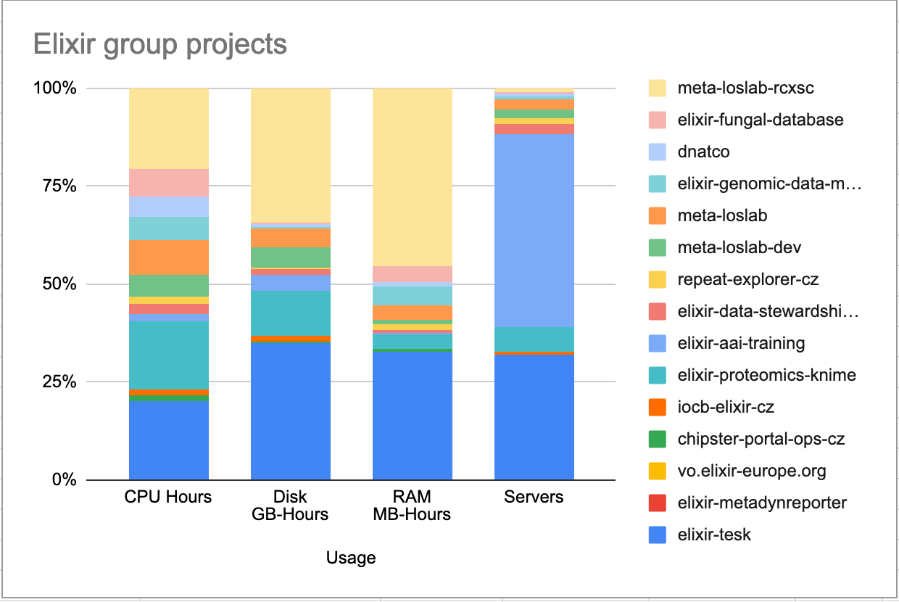

Velké projekty z projektu ELIXIR: 15 projektů, 4036618 CPU hodin, 523 VM

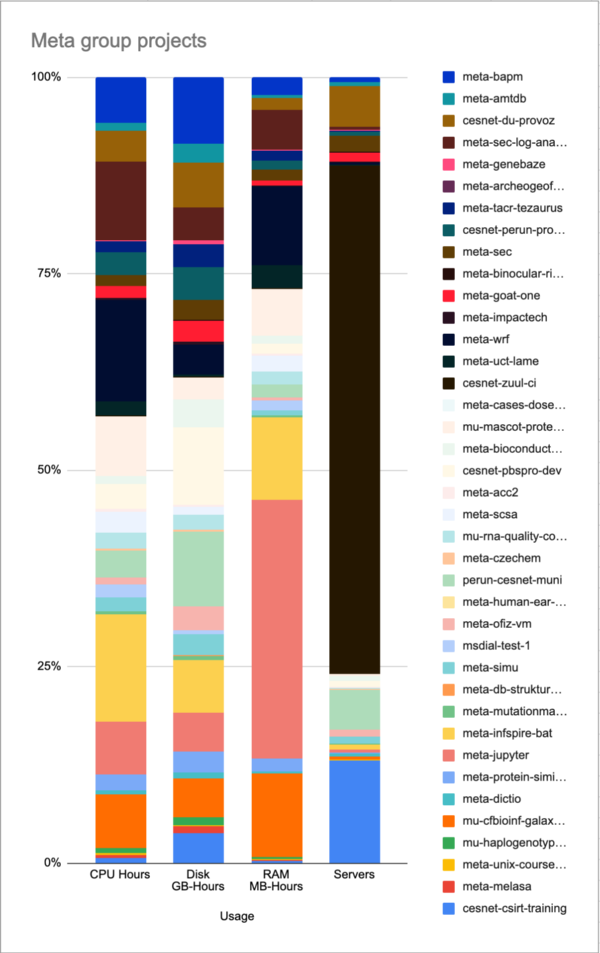

Velcí uživatelé přicházející z MetaCentra: 38 projektů, 5188578 CPU hodin, 1546 VM

Uživatlé přicházející z EGI (FedCloud): 20 projektů, 3726263 CPU hodin, 1910 VM

Ke clusteru pořízenému z projektu ELIXIR-CZ mělo prostřednictvím plánovacího systemu elixir-pbs dedikovaný přístup 72 uživatelů projektu ELIXIR-CZ, uživatelé MetaCentra sem mohli posílat krátké výplňové úlohy pouze tehdy, pokud byl cluster nevyužitý. V cloudovém prostředí uživatelé z ELIXRu založili celkem 15 projektových skupin.

Velikost clusteru ke konci roku 2020: 1664 (pbs) + 2656 CPU jader (cloud, z toho 896 CPU jader bylo nakoupeno koncem roku 2020 a bude zprovozněno v lednu 2021).

V roce 2020 na tomto clusteru bylo propočítáno (pbs) 1007 CPU let ve 983 tisících úlohách, v cloudu pak 461 CPU let v 526 instancích.

Mezi největší počtáře (organizace, služby) podle propočítaného času na strojích projektu ELIXIR-CZ patří (pbs) UK (28%), RE Galaxy ELIXIR (15%), MU (14%), ČVUT 11% a UPOL 6%, ostatní propočítali 26%.

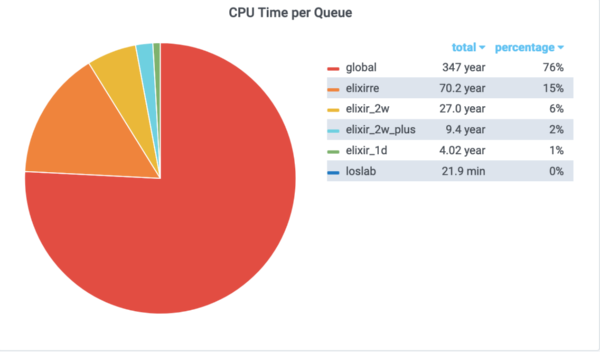

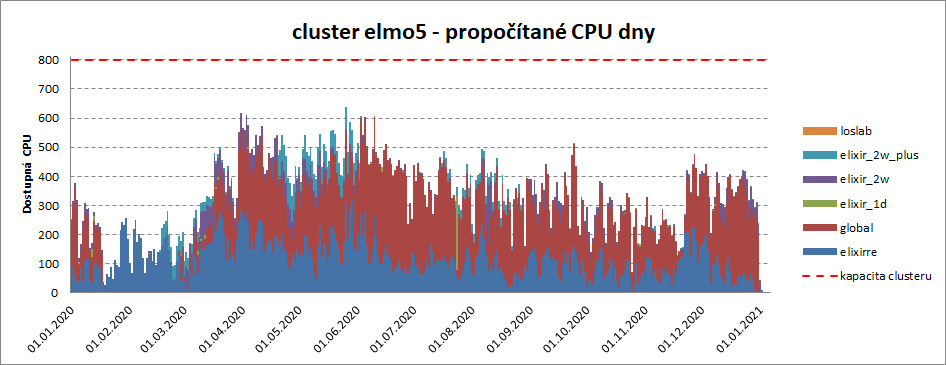

Nejvíce propočítaného času bylo ve frontě global, do které směřují také krátké úlohy z jiných pbs systémů. Druhou nejžádanější frontou byla fronta obsluhující apliklaci RepeatExplorer Galaxy. Fronta loslab zůstala nevyužitá, protože se veškéré výpočty z této fronty přesunoly do cloudového prostředí.

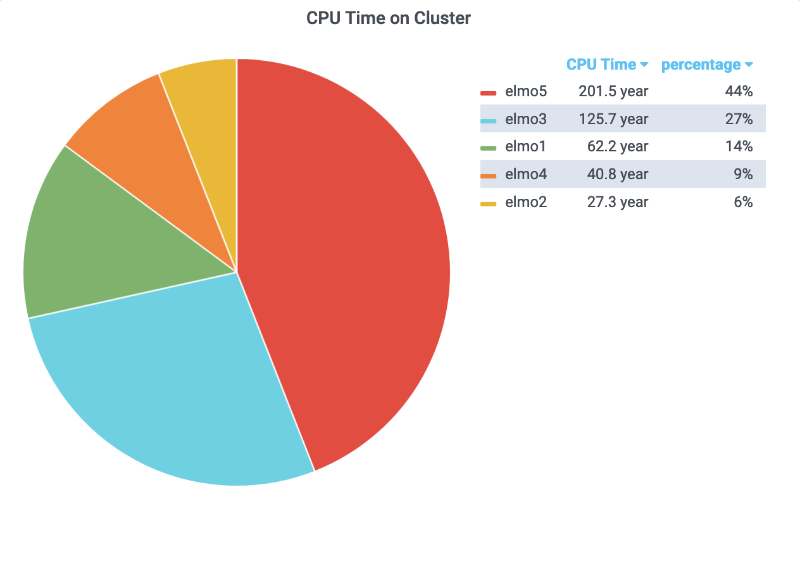

Následující obrázek ukazuje, na kterém clusteru se propočítalo nejvíce.

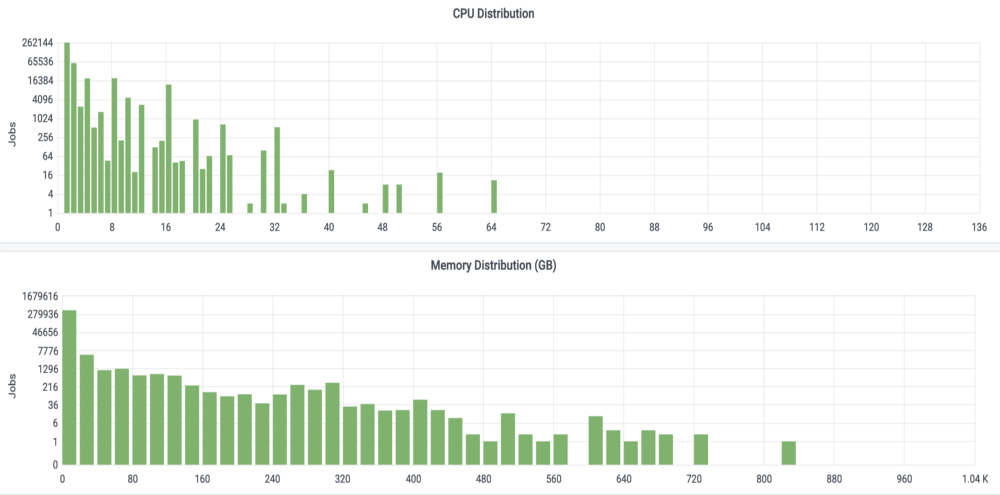

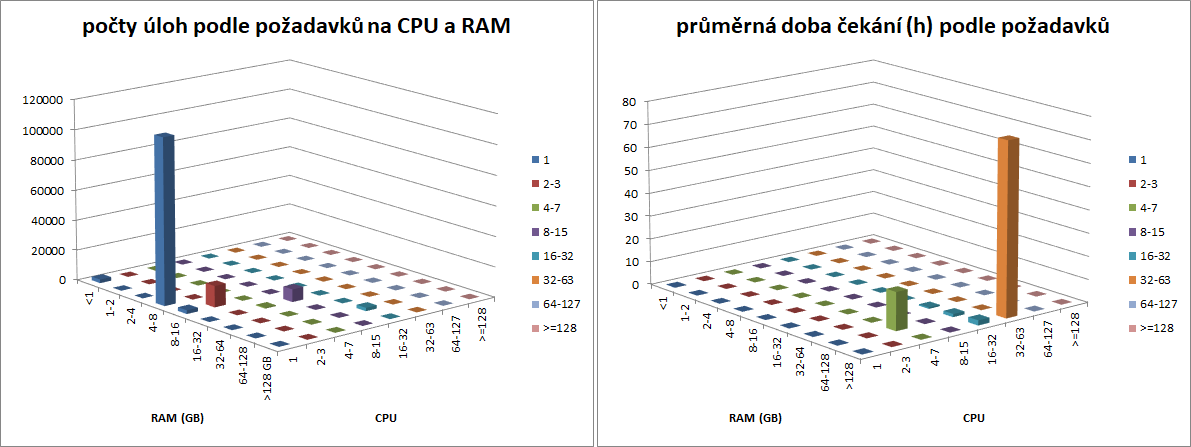

Většina úloh požadovala několi málo jader na jeden běh, vyskytly se však úlohy požadující až 128 CPU jader. Podobně si většina úloh vystačila s požadavkem na paměť v řádu desítek GB, vyskytly se však i úlohy požadující téměř 1 TB RAM.

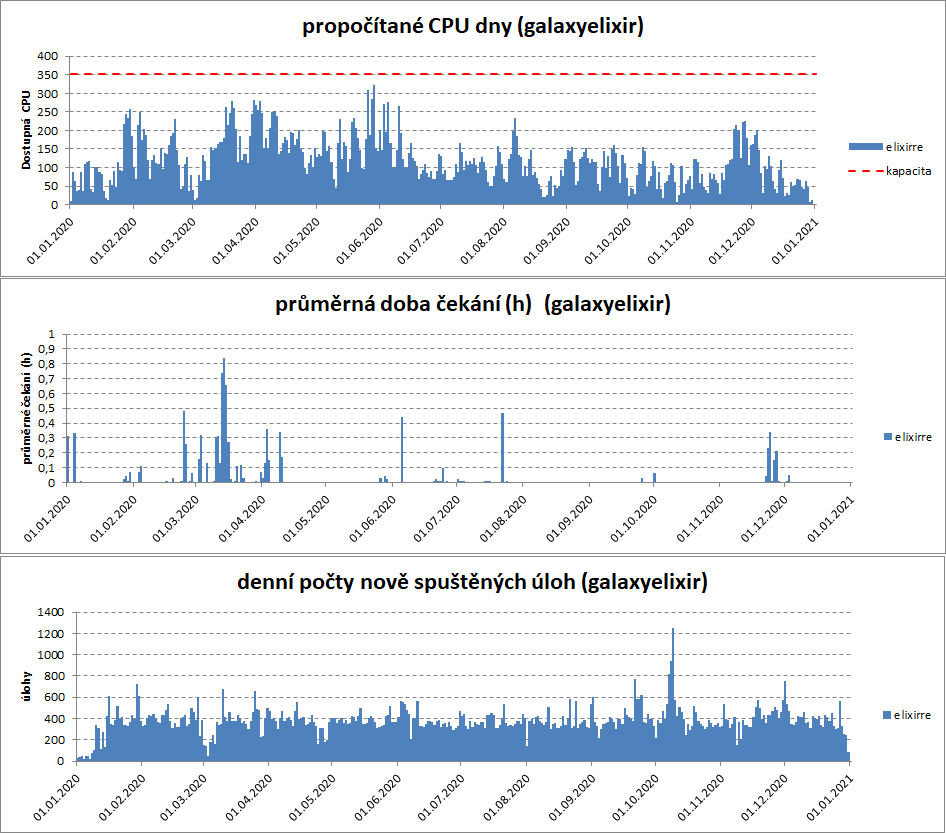

Službě RE Galaxy (elixirre) bylo vyhrazeno 11 uzlů po 32 jádrech, tj. celkem 352 CPU jader.

Na následujících grafech je znázorněné vytížení těchto dedikovaných výpočetních prostředků, průměrná doba čekání úlohy na spuštění a denní počty nově spuštěných úloh.

Využití dedikovaných jader bylo v průměru třetinové, což se projevilo velmi krátkou dobou čekání úloh na spuštění. Průměrná doba čekání ve frontě elixirre byla 8 minut, minimální doba 1 vteřinu, maximální doba více než týden, ale zdůvodu chyby v zadání jedné úlohy. Denní přírůstky nově zadaných úloh byly přibližně rovnoměrné.

Služba RE Galaxy (elixirre) běží na clusteru elmo5, který má celkem 800 CPU jader. Následující graf ukazuje využití kapacity tohoto clusteru v porovnání s běžnými frontami, které na něj mají rovněž přístup.

Většina úloh bežící v RE Galaxy požadovala 1 CPU a 4-8 GB RAM, vyskytly se však i úlohy požadující více než 32 CPU jader a více než 128 GB RAM. Průměrná doba čekání úloha na spuštění byla 8 minut. Je zde vidět anomálii u úlohy požadující 32-63 CPU jader a více než 128 GB RAM, která čekala více než týden z důvodu chyby v zadání.

Velikost clusteru zapojeného v cloudu byla ke konci roku 2020 2656 CPU jader, z toho 896 CPU jader bylo nakoupeno koncem roku 2020 a bude zprovozněno v lednu 2021.

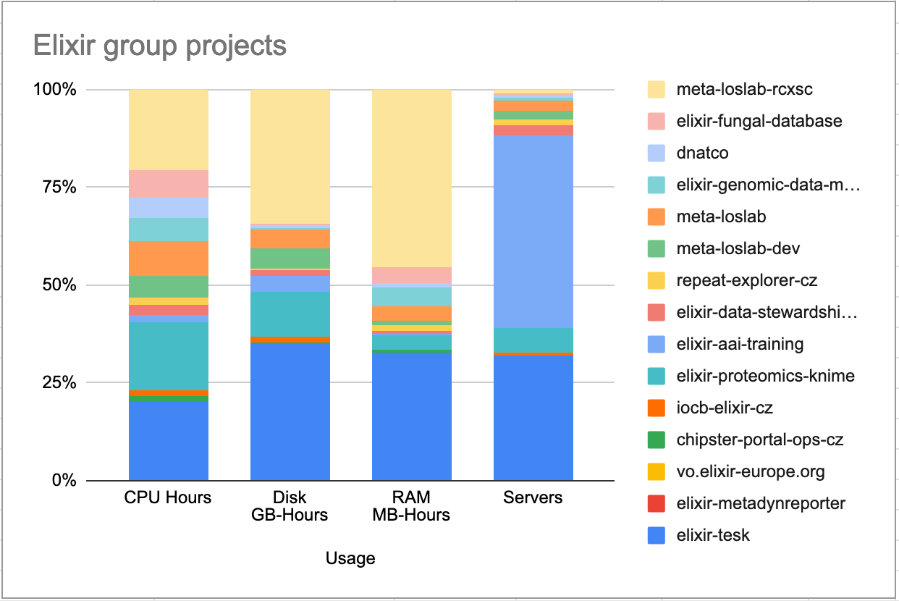

Projekty uživatelů ELIXIR-CZ běžící v cloudu propočítaly v roce 2020 celkem 461 CPU let a běžely v 526 instancích. V cloudovém prostředí uživatelé z ELIXIRu založili celkem 15 projektových skupin, jejich podíl na využití HW ukazuje následující obrázek.

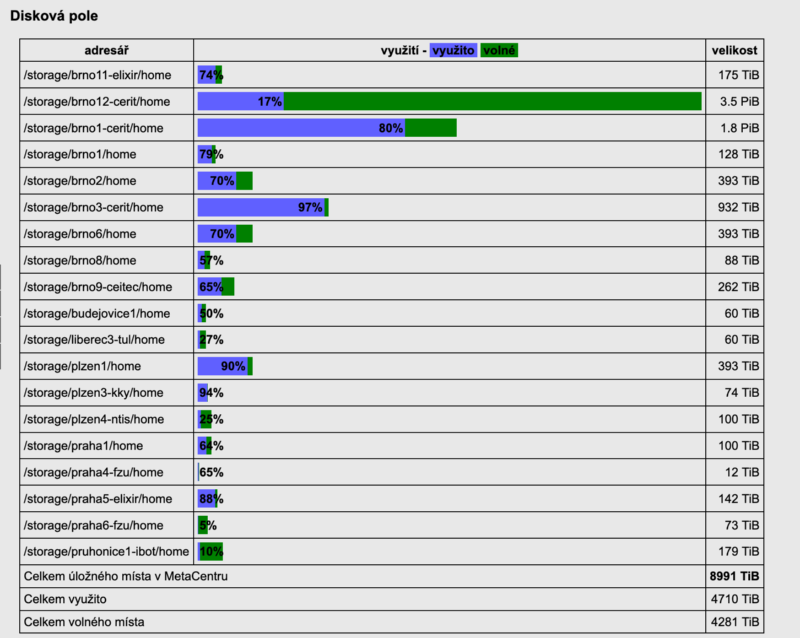

Meziročně opět vzrostlo zaplnění diskových polích v MetaCentru i v CERIT-SC. Mimo to, se podařilo integrovat diskové pole jiných vlastníků do infrastruktury MetaCentra (CEITEC, ELIXIR). Přístup na taková pole je dedikován vlastníkům, po dohodě s nimi může býrt přístupný i pro další uživatele.

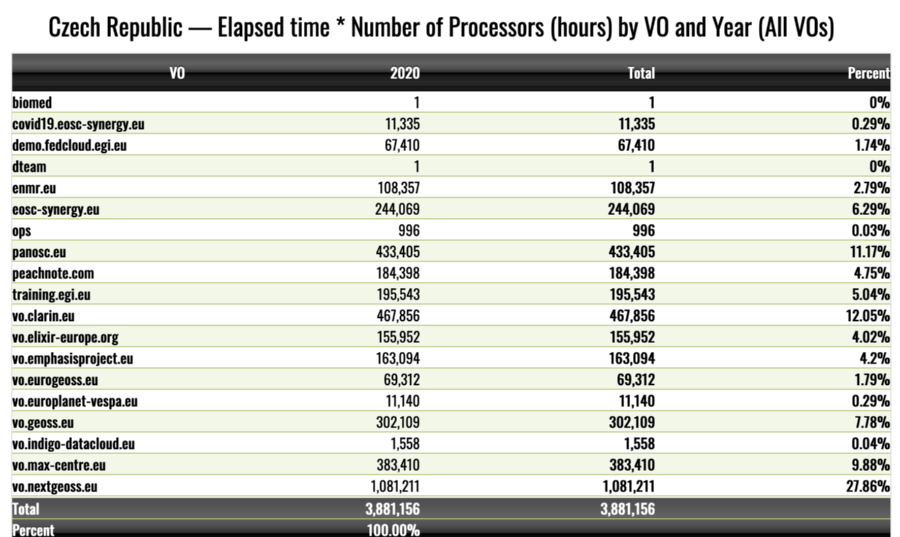

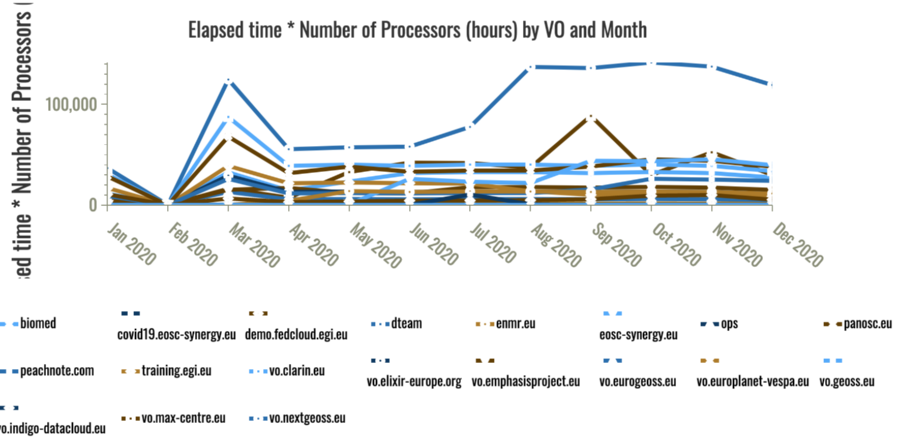

Přehled z Cloud Compute EGI accounting portálu zobrazuje accountingová data ze všech center cloudových zdrojů v infrastruktuře EGI v České republice. Jsou shromažďovány pouze od zdrojů, která jsou součástí federace EGI a jsou certifikována v GOCDB. Zobrazená metrika je Elapsed time * Number of Processors.

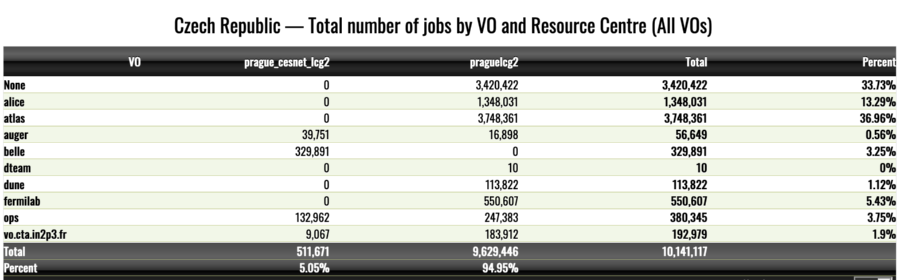

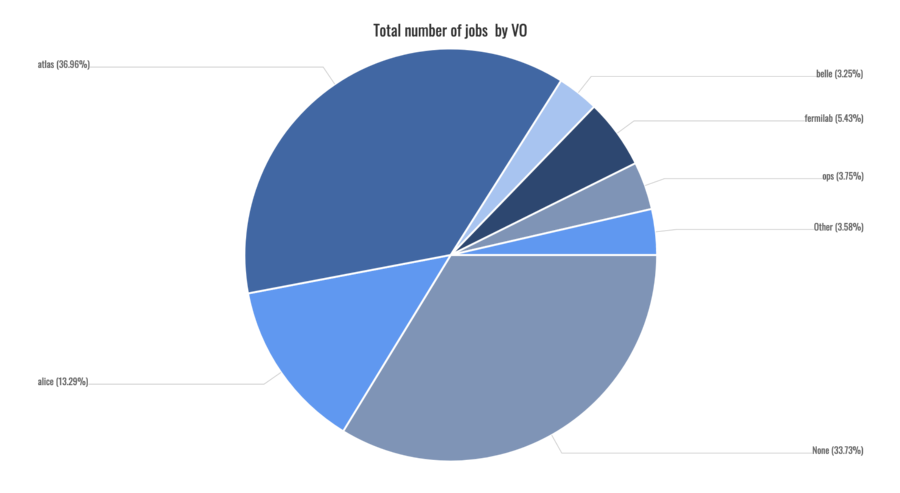

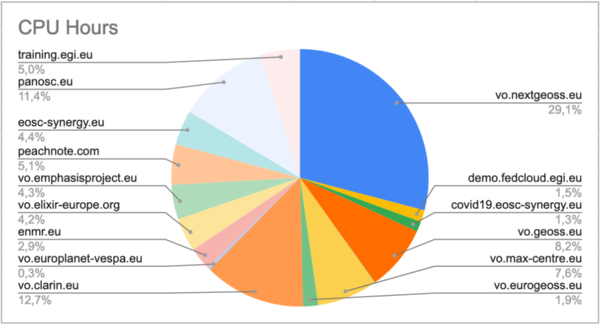

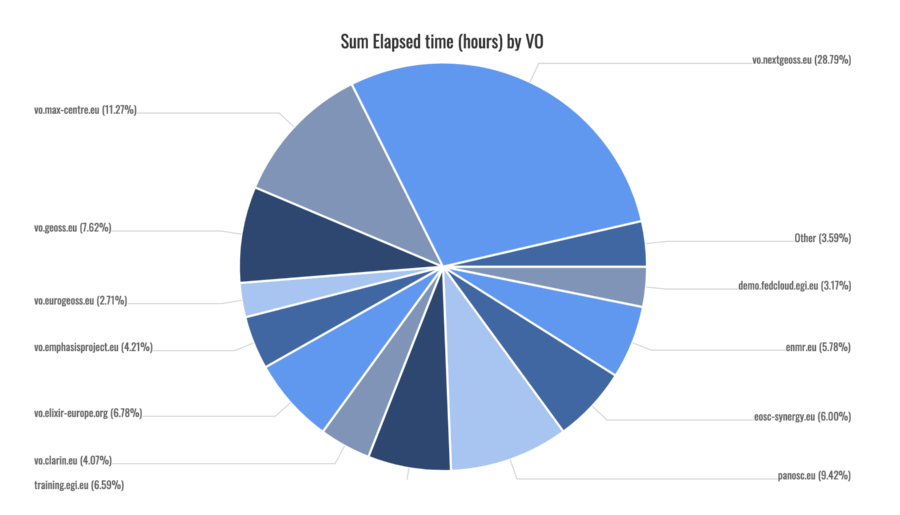

Následující tabulka a graf ukazují propočítaný čas v rámci jednotlivých mezinárodních projektů (VO), kterým poskytujeme výpočetní výkon.

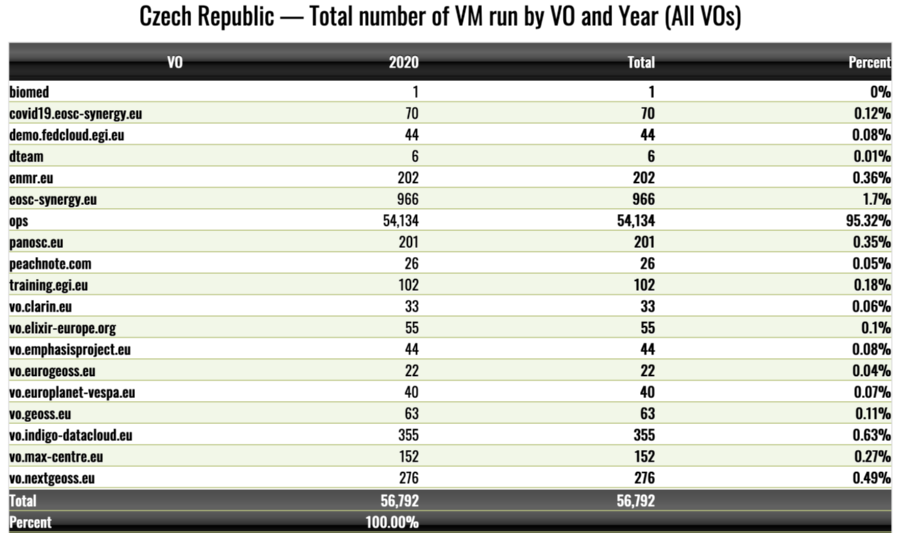

Následující tabulka a graf ukazují počty spuštěných virtuálních strojů jednotlivými projkety (VO).

Počet CPU jader zapojených do EGI HTC: 6230 CPU jader, z toho

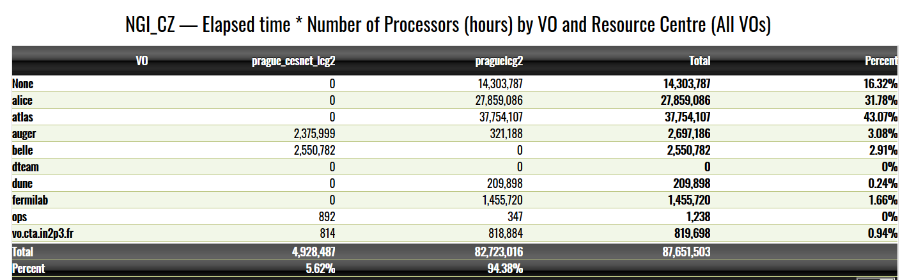

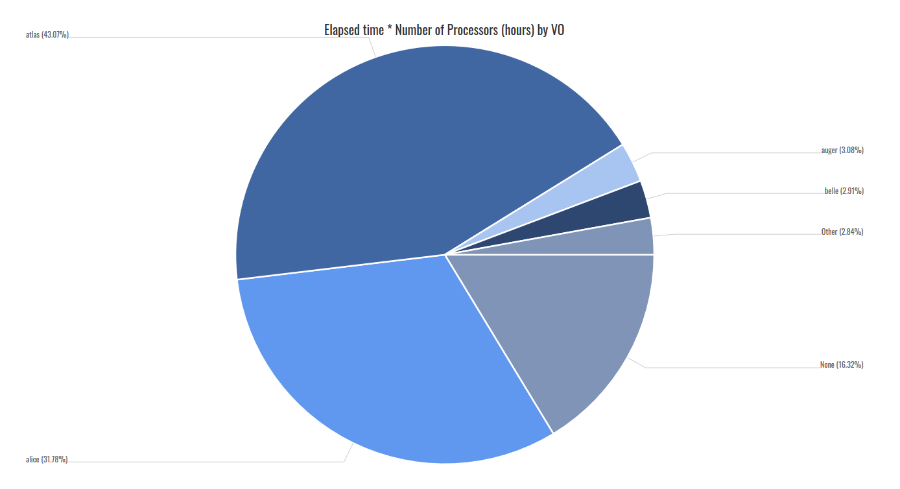

Přehled z HTC Compute EGI accounting portálu zobrazuje accountingová data ze všech výpočetních středisek výpočetní kapacity s vysokou propustností v infrastruktuře EGI v NGI_CZ. Účetní informace jsou shromažďovány pouze od středisek zdrojů, která jsou součástí federace EGI a jsou certifikována v GOCDB. Zobrazená metrika je Elapsed time * Number of Processors.

Počet úloh z EGI accounting portálu za rok 2020 a rozdělení mezi podpořené virtuální organizace.