Tyto novinky můžete číst jako RSS.

Vážení uživatelé,

v průběhu tohoto týdne nasadíme do provozu šifrování interaktivních úloh. Tento krok je důležitý pro zvýšení bezpečnosti přenosu dat a komunikace v rámci výpočetního prostředí MetaCentra.

Pro vás, jako uživatele, přináší tato aktualizace dvě praktické změny, na které bychom vás rádi upozornili:

Systém bude nově striktněji vyžadovat platný Kerberos lístek.

Pokud v okamžiku startu interaktivní úlohy nemáte platný Kerberos lístek (ticket), systém vás při pokusu o připojení k úloze vyzve k jeho obnově (zadání hesla / kinit).

Pokud lístek máte platný, přihlášení proběhne standardně bez další interakce.

Zavádíme bezpečnostní časový limit pro zahájení práce.

Jakmile interaktivní úloha na klastru odstartuje (je jí přidělen výpočetní uzel), máte 3 hodiny na to, abyste se k ní připojili.

Pokud se k běžící úloze do 3 hodin nepřipojíte, bude automaticky zrušena.

Tato opatření nám pomáhají udržovat infrastrukturu bezpečnou a efektivně využívanou. Děkujeme za pochopení.

MetaCentrum

Počítáte u nás? Chceme znát váš názor.

Aby naše výpočetní a cloudové služby i nadále vyhovovaly nárokům vašeho výzkumu, potřebujeme znát váš názor. Vaše zpětná vazba je klíčová pro náš další strategický rozvoj. Pomáhá nám přesně určit, které oblasti infrastruktury – od plánování úloh (job scheduling) až po dostupnost úložišť – je třeba zlepšit nebo rozšířit.

Pokud jste již dotazník vyplnili dříve, děkujeme za Váš názor.

Termín: Své odpovědi prosím odešlete do 14. února 2026.

Odkaz: Dotazník

S potěšením oznamujeme, že do infrastruktury MetaCentra byly úspěšně integrovány nové výpočetní clustery ve vlastnictví sdružení CESNET a Západočeské univerzity v Plzni (ZČU). Toto rozšíření přináší navýšení kapacity pro CPU i GPU výpočty a specializovaný SMP uzel s velkou sdílenou pamětí.

Níže uvádíme technické specifikace:

Tento cluster nahrazuje původní cluster stejného jména. Je určen pro náročné výpočty na CPU a neobsahuje grafické akcelerátory. Cluster je již dostupný v běžných frontách plánovače.

Vlastník: CESNET

adan[1-48].grid.cesnet.cz

Celková kapacita: 48 uzlů / 6 144 jader CPU

Konfigurace uzlu:

CPU: 2x AMD EPYC 9554 64-Core Processor

RAM: 768 GiB

Disk: 2x 3.84 TB NVMe

Síť: 25 Gbit/s

Výkon uzlu: SPECrate 2017_fp_base: 1360 (10.6 na jádro)

Cluster alfrid[1-9].meta.zcu.cz prošel ve dvou fázích (květen a prosinec 2025) zásadní modernizací a rozšířením. Nahrazuje původní hardware a nabízí nyní 8 GPU uzlů a jeden SMP uzel. Cluster je již dostupný v prioritních frontách vlastníka (iti a zcu) a pro ostatní uživateleběžných krátkých frontách .

1. GPU uzly (alfrid alfrid[1-4].meta.zcu.cz a alfrid-II alfrid[6-9].meta.zcu.cz) Tyto uzly jsou vybaveny akcelerátory NVIDIA L40 a L40S, vhodné pro akcelerované výpočty a AI úlohy.

Vlastník: ZČU Plzeň

Celková kapacita: 8 uzlů / 1 024 jader CPU

Konfigurace uzlů:

CPU: 2x AMD EPYC 9554 64-Core Processor

RAM: 1 536 GiB (alfrid) / 768 GiB (alfrid-II)

GPU: 2x NVIDIA L40 48GB (alfrid) / 4x NVIDIA L40S 48GB (alfrid-II)

Disk: 2x 7 TB NVMe

Síť: 25 Gbit/s

Výkonuzlu : SPECrate 2017_fp_base: 1230

2. SMP uzel (alfrid-smp alfrid5.meta.zcu.cz) Specializovaný uzel určený pro úlohy vyžadující velké množství sdílené paměti.

Vlastník: ZČU Plzeň

Kapacita: 1 uzel / 128 jader CPU

Konfigurace uzlu:

CPU: 2x AMD EPYC 9554 64-Core Processor

AM: 4 608 GiB (přibližně 4,5 TB)

Disk: 2x 7 TB NVMe

Síť: 10 Gbit/s

Výkon uzlu: SPECrate 2017_fp_base: 1200

Kompletní seznam dostupných výpočetních serverů a jejich aktuální vytížení naleznete na stránce: Hardware MetaCentra.

Věříme, že tento nový hardware přispěje k efektivní realizaci vašich výpočtů a vědeckých projektů.

|

||||||

|

||||||

|

Ve čtvrtek 2. října 2025 proběhl v pražském Klubu Lávka Seminář výkonného počítání MetaCentrum 2025, kterého se zúčastnilo více než 90 účastníků na místě a dalších 60 účastníků se připojilo online.

Program byl zaměřen na zpracování a ukládání dat, bezpečnost, práci s kontejnery i cloudem a využití AI modelů na infrastruktuře MetaCentra a CERIT-SC. O své zkušenosti se podělili nejen odborníci z CESNET a CERIT-SC, ale i uživatelé z výzkumných skupin Masarykovy univerzity a Univerzity Karlovy.

Prezentace ze semináře jsou k dispozici na stránce akce. Na stejném odkaze bude, po sestříhání, vystaven i videozáznam ze semináře.

Vážení uživatelé,

Dovolujeme si Vás pozvat na akci pořádanou IT4Innovations: Basics of Quantum Machine Learning

https://events.it4i.cz/event/354/

|

||||||

|

Vážení uživatelé,

Dovolujeme si Vás pozvat na pravidelný Seminář výkonného počítání MetaCentrum 2025, který se uskuteční ve čtvrtek 2. října 2025 v Novotného lávce v Praze s exkluzivním výhledem na Karlův most a centrum Prahy.

Seminář bude zaměřen na zpracování, analýzu a ukládání dat a také na představení novinek v gridovém, cloudovém a kubernetím prostředí MetaCentra a CERIT-SC.

Akci pořádá projekt MetaCentrum sdružení CESNET ve spolupráci s Centrem CERIT-SC při Ústavu výpočetní techniky Masarykovy univerzity.

Program a další informace:

https://metavo.metacentrum.cz/cs/seminars/Seminar2025/index.html

Na shledanou se těší Vaše MetaCentrum

S potěšením oznamujeme, že do infrastruktury MetaCentra byl úspěšně integrován nový výpočetní cluster fobos.meta.zcu.cz.

Cluster je dostupný v běžných frontách.

Kompletní seznam dostupných výpočetních serverů naleznete zde: https://metavo.metacentrum.cz/pbsmon2/hardware

Věříme, že tento nový hardware přispěje k efektivnější realizaci vašich výpočtů a vědeckých projektů!

Jsme rádi, že Vám můžeme oznámit dostupnost nového rychlého sdíleného scratchu s využitím paralelního distribuovaného souborového systému BeeGFS na našem clusteru bee.cerit-sc.cz. Tento nový zdroj, dostupný jako scratch_shared, je speciálně navržen pro potřeby vysokovýkonných výpočtů (HPC) a nabízí řadu výhod pro aplikace náročné na data a výpočty.

BeeGFS je ideální volbou pro náročné úlohy, které vyžadují:

S potěšením oznamujeme, že do infrastruktury MetaCentra byly úspěšně integrované nové výpočetní clustery elbi1.hw.elixir-czech.cz, elmu1.hw.elixir-czech.cz, eluo1.hw.elixir-czech.cz, elum1.hw.elixir-czech.cz projektu ELIXIR. Clustery mají velmi podobnou konfiguraci a jsou umístěné v různých lokalitách.

|

elmu1.hw.elixir-czech.cz (2400 CPU, 25 uzlů ) - Cluster výpočetních strojů (MUNI Brno)

|

eluo1.hw.elixir-czech.cz (576 CPU, 6 uzlů ) - Cluster výpočetních strojů (UOCHB Praha)

|

elum1.hw.elixir-czech.cz (96 CPU, 1 uzel ) - Cluster výpočetních strojů (UMG Praha)

|

Cluster je dostupný v prioritních frontách Elixíru. Cluster elbi1 má k dispozici 2 GPU karty a je přístupný i v gpu frontách. Ostatní uživatelé mohou cluster využívat v krátkých běžných frontách s limitem do 24 hodin.

Kompletní seznam dostupných výpočetních serverů naleznete zde: https://metavo.metacentrum.cz/pbsmon2/hardware

Věříme, že tento nový hardware přispěje k efektivnější realizaci vašich výpočtů a vědeckých projektů!

Vážení uživatelé,

s potěšením vám oznamujeme, že pro vás máme tři novinky:

Nasadíme brzy! Naše stávající dokumentace https://docs.metacentrum.cz/ prošla vizuální modernizací.

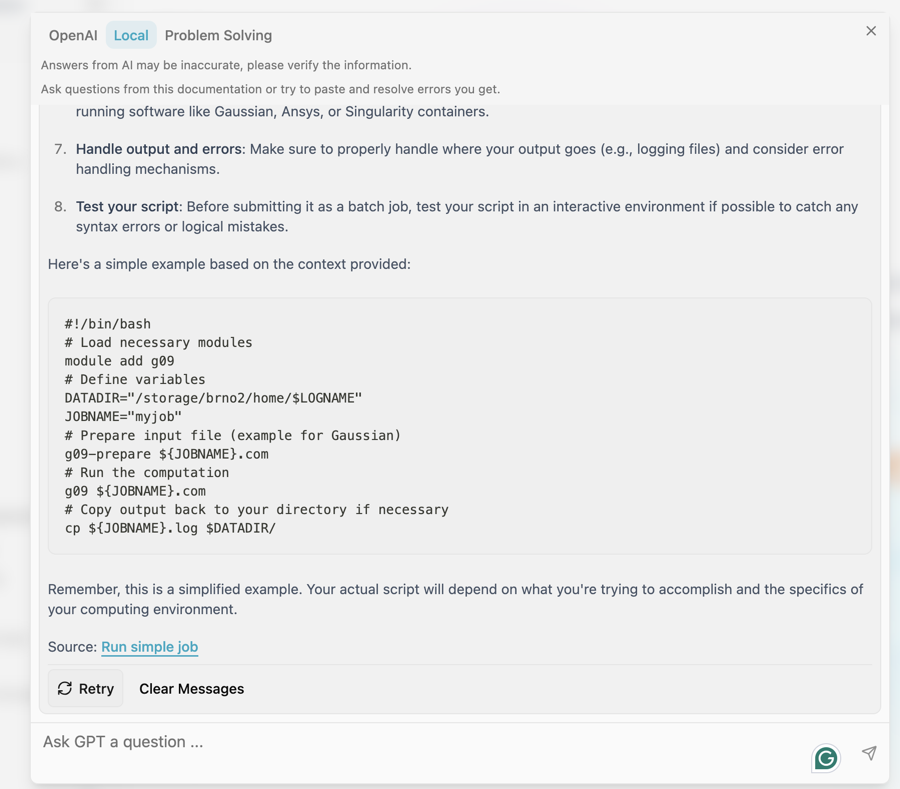

I když její struktura zůstává beze změny, převedli jsme ji na novou technologii podporující integraci AI chatu (https://docs.metacentrum.cz/en/docs/tutorials/chat-help) , který vám pomůže rychle najít odpovědi na otázky týkající se dokumentace.

AI chat umístěný v pravém dolním rohu umožňuje, po přihlášení, interaktivní vyhledávání informací obsažených v dokumentaci. Volte volbu Local, pokud chcete odpověď založenou na obsahu dokumentace. Volba Problem Solving řeší nejčastější problémy, na které můžete narazit.

Budeme rádi za vaši zpětnou vazbu. Na základě vašich dotazů a připomínek budeme průběžně dokumentaci vylepšovat.

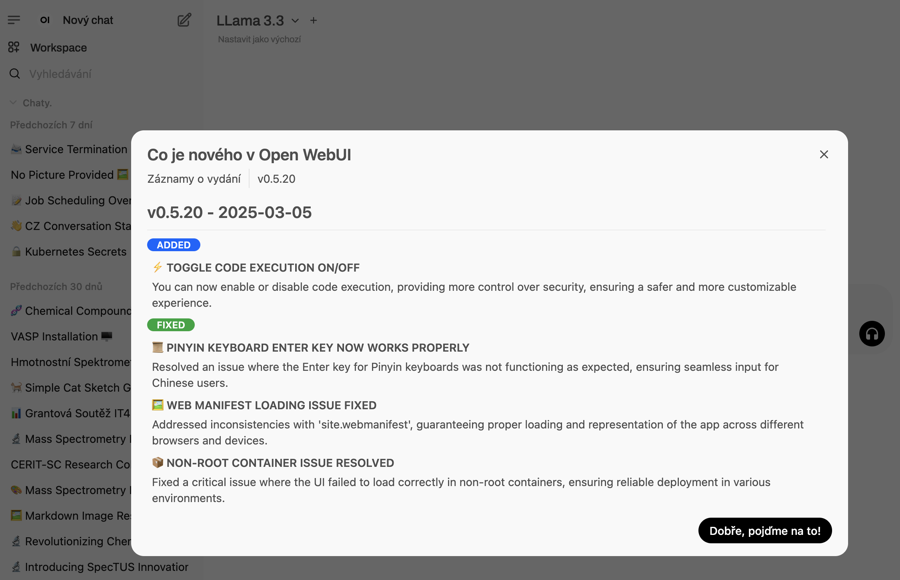

Zároveň jsme zprovoznili samostatný AI chat dostupný na https://chat.ai.e-infra.cz/. Je v něm dostupných několik modelů k vyzkoušení, podporuje kreslení obrázků i čtení přiložených dokumentů. Modely běží u nás lokálně na našich výpočetních zdrojích, takže se nemusíte bát úniku dat mimo naši infrastrukturu.

Všechny nabízené modely jsou k dispozici také přes API a je je možné využít pro Vaše projekty. Dokumentace je k dispozici na:

https://docs.cerit.io/en/docs/web-apps/chat-ai

Zajímavosti k AI chatu i k jiným tématům, které se týkají infrastruktury, najdete v našem blogu https://blog.e-infra.cz/

Vážení uživatelé,

|

|||||||||||||||||||

|

Upozorňujeme uživatele, že došlo ke změně způsobu přístupu k výpočetnímu stroji NVIDIA DGX H100 80GB (capy.cerit-sc.cz).

Nově bude přístup umožněn pouze na základě schválené žádosti o výpočetní čas. Kritéria a postup podání žádosti naleznete zde: docs.metacentrum.cz/computing/gpu-comput/dgx/.

Pokud vaše výpočetní požadavky nesplňují stanovená kritéria, ale potřebujete GPU s velkou pamětí, můžete využít GPU cluster bee (bee.cerit-sc.cz) s NVIDIA 2×H100 94GB. Více informací o tomto clusteru najdete v předchozí novince: Odkaz na novinku.

Vaše MetaCentrum

S potěšením oznamujeme, že do infrastruktury MetaCentra byl úspěšně integrován nový výpočetní cluster farin.grid.cesnet.cz provozovaný Fakultou stavební ČVUT v Praze.

Cluster je dostupný v prioritní frontě vlastníka cvut@pbs-m1.metacentrum.cz. Ostatní uživatelé mohou cluster využívat v krátkých běžných frontách s limitem do 24 hodin.

Studenti a zaměstnanci Fakulty stavební ČVUT mají možnost požádat o přístup do vyhrazené fronty.

Kompletní seznam dostupných výpočetních serverů naleznete zde: https://metavo.metacentrum.cz/pbsmon2/hardware

Věříme, že tento nový hardware přispěje k efektivnější realizaci vašich výpočtů a vědeckých projektů!

Migrace projektů běžících v e-INFRA CZ / Metacentrum OpenStack cloudu Brno G1 [1] do nového prostředí Brno G2 [2], která probíhala v průběhu roku 2024, se blíží do finální fáze.

Migrace osobních projektů [3] bude umožněna od února 2025 a bude možné ji učinit svépomocí.

Postup migrace bude aktualizován v průběhu ledna 2025 na stránkách [2], [4].

Detailněji o postupu a novinkách Vás budeme průběžně informovat na úvodní stránce G2 e-INFRA CZ / Metacentrum OpenStack cloudu [2].

Děkujeme za pochopení.

e-INFRA CZ / Metacentrum OpenStack cloud tým

cloud@metacentrum.cz

[1] https://cloud.metacentrum.cz/

[2] https://brno.openstack.cloud.e-infra.cz/

[3] https://docs.e-infra.cz/compute/openstack/technical-reference/brno-g1-site/get-access/#personal-project

[4] https://docs.e-infra.cz/compute/openstack/migration-to-g2-openstack-cloud/#may-i-perform-my-workload-migration-on-my-own

Vážené uživatelky a uživatelé MetaCentra,

doufáme, že Vás potěší několik novinek, které jsme připravili pro zvýšení vašich možností při výpočtech a optimalizaci vašich projektů. Snažíme se nabídnout špičkové softwarové nástroje a inovativní služby, které zefektivní práci a umožní kvalitnější výsledky.

MetaCentrum nyní disponuje novými komerčními licencemi pro kvantově chemické výpočty pomocí nástrojů MolPro a Turbomole. Tyto nástroje umožní detailnější a efektivnější simulace i analýzy molekulárních systémů:

Podrobné informace o všech softwarových možnostech dostupných v MetaCentru naleznete zde: https://docs.metacentrum.cz/software/alphabet/

S radostí představujeme novou webovou službu Foldify, která je nyní plně integrovaná do prostředí Kubernetes. Foldify je špičková platforma navržená pro prostorové skládání proteinů, která vyniká svým snadným a uživatelsky přívětivým rozhraním. Tato služba výrazně zjednodušuje a zefektivňuje práci odborníků v oblasti biochemie a biofyziky. Uživatelům nabízí široké možnosti zpracování dat, neboť kromě populárního AlphaFoldu podporuje také nástroje jako ColabFold, OmegaFold a ESMFOLD.

Foldify můžete prozkoumat a využít na této adrese: https://foldify.cloud.e-infra.cz/

Přejeme Vám pohodové Vánoce a vše nejlepší do Nového roku.

Vaše MetaCentrum

MetaCentrum bylo nedávno rozšířeno o dva nové výkonné clustery:

1) Masarykova univerzita (CERIT-SC) přikoupila k výkonnému stroji NVIDIA DGX H100 další cluster čítající 32x NVIDIA H100 GPU (94 GB GPU RAM) ve 20 uzlech s 960 CPU jádry vhodných pro AI náročné výpočty.

2) Fyzikální ústav Akademie věd zapojil do MetaCentra nový cluster magma.fzu.cz sestávající z 23 uzlů celkem s 2208 CPU jádry a každý s 1,5 TB RAM

1) Cluster bee.cerit-sc.cz

V dávkovém systému MetaCentra je zapojených 10 uzlů, celkem s 960 CPU jádry a 20x NVIDIA H100 s následující konfigurací každého uzlu:

| CPU | 2x AMD EPYC 9454 48-Core Processor |

|---|---|

| RAM | 1536 GiB |

| GPU | 2x H100 s 94 GB GPU RAM |

| disk | 8x 7TB SSD s podporou BeeGFS |

| net | Ethernet 100Gbit/s, InfiniBand 200Gbit/s |

| poznámka | Výkon každého uzlu je dle SPECrate 2017_fp_base = 1060 |

| vlastník | CERIT-SC |

Cluster podporuje nástroje NVidia GPU Cloud (NGC) pro hluboké učení, včetně předkonfigurovaných prostředí a je přístupný v běžných gpu frontách.

Zároveň připravujeme změnu pro přístup ke stroji NVIDIA DGX H100, který zůstane ve speciální frontě gpu_dgx@meta-pbs.metacentrum.cz. Bude využitelný na požádání a jen uživateli, kteří prokáží, že jejich úlohy podporují NVLink a umí využít alespoň 4 nebo všech 8 GPU kartet zaráz. O připravované změně budeme ještě informovat.

2) Cluster magma.fzu.cz

V dávkovém systému MetaCentra je zapojených 23 uzlů, celkem s 2208 CPU jader s následující konfigurací každého uzlu:

| CPU | 2x AMD EPYC 9454 48-Core Processor CPU @ 2.7GHz |

|---|---|

| RAM | 1536 GiBidia |

| isk | 1x 3.84 NVMe |

| net | Ethernet 10Gbit/s |

| poznámka | Výkon každého uzlu je dle SPECrate 2017_fp_base = 1160 |

| vlastník | FZÚ AV ČR |

Cluster je přístupný v prioritní frontě vlastníka luna@pbs-m1.metacentrum.cz a pro ostatní uživatele v krátkých běžných frontách.

Kompletní seznam aktuálně dostupných výpočetních serverů je na http://metavo.metacentrum.cz/pbsmon2/hardware.

S přáním příjemného počítání,

Vážení uživatelé,

dovolujeme si přeposlat informaci o grantové soutěži v IT4I:

|

||||||||

|

Vážení uživatelé,

Na začátku března jsme poprvé informovali o zahájení přechodu na novou PBSPro —> OpenPBS.

Pokud se tak již nestalo, používejte pro své úlohy nové OpenPBS prostředí pbs-m1.metacentrum.cz. Pokud nechcete ve svých skriptech nic měnit, zadávejte úlohy z frontendů s OS Debian12, názvy front zůstanou zachované, změní se jen PBS server (FRONTA@pbs-m1.metacentrum.cz).

Seznam dostupných frontendů včetně aktuálního OS najdete na stránce https://docs.metacentrum.cz/computing/frontends/

Nyní je v novém OpenPBS prostředí k dispozici cca 3/4 clusterů, na reinstalaci dalších intenzivně pracujeme. Čekáme na doběhnutí úloh.

Přehled strojů s vlastností Debian12: https://metavo.metacentrum.cz/pbsmon2/props?property=os%3Ddebian12

Zda se Vaše úloha spustí v novém OpenPBS prostředí, můžete vyzkoušet v Sestavovači qsub: https://metavo.metacentrum.cz/pbsmon2/qsub_pbspro

Aktuální informace o migraci najdete v dokumentaci https://docs.metacentrum.cz/tutorials/debian-12/ (postup migrace zde aktualizujeme).

Vaše MetaCentrum

Vážení uživatelé,

Provedli jsme změnu ve službě Open OnDemand (OOD), kdy se nově OOD úlohy spouštějí také na clusterech, které nemají výchozí home na poli brno2. Z toho důvodu se může stát, že již existující data, historie příkazu, atd. z pole brno2 nebudou dostupná v nové OOD úloze, pokud bude spuštěna na stroji s jiným /home.

Pro přístup k původním datům na poli brno2 bude nutné nastavit symbolický odkaz na pole nové. Příklad níže nastavuje symbolický odkaz pro historii programu R.

ln -s /storage/brno2/home/user_name/.Rhistory /storage/new_location/home/user_name/.Rhistory

Vaše MetaCentrum

Na Konferenci e-INFRA CZ 2024, která se konala 29. - 30. dubna 2024 v Praze v hotelu Occindental, se sešlo přes 180 účastníků.

Prezentace z přednášek jsou k dispozici na stránkách akce.

Videozáznam připravujeme a zveřejníme brzy rovněž na stránkách akce.

Na začátku března jsme informovali o zahájení přechodu na novou PBSPro —> OpenPBS.

Pokud se tak již nestalo, používejte pro své úlohy nové OpenPBS prostředí pbs-m1.metacentrum.cz. Pokud nechcete ve svých skriptech nic měnit, zadávejte úlohy dočasně z nového frontendu zenith nebo z přeinstalovaných frontendů nympha, tilia a perian běžících v novém OpenPBS prostředí (už s OS Debian12). Ostatní frontendy budeme převádět postupně.

Seznam dostupných frontendů včetně aktuálního OS najdete na stránce https://docs.metacentrum.cz/computing/frontends/

Přístup k nové PBS je možný také z ostatních frontendů, je však nutná aktivace modulu openpbs (module add openpbs).

Problémy s kompatibilitou některých aplikací s OS Debian12 průběžně řešíme rekompilací nových SW modulů. Pokud narazíte na problém u své aplikace, vyzkoušejte přidání modulu debian11/compat na začátek spouštěcího skriptu (module add debian11/compat). Pokud problémy přetrvávají (chybějící knihovny atd.), dejte nám vědět na meta(at)cesnet.cz.

Nyní je v novém OpenPBS prostředí k dispozici cca polovina clusterů, na reinstalaci dalších intenzivně pracujeme. Čekáme na doběhnutí úloh. Přehled strojů s vlastností Debian12: https://metavo.metacentrum.cz/pbsmon2/props?property=os%3Ddebian12

Zda se Vaše úloha spustí v novém OpenPBS prostředí můžete vyzkoušet v Sestavovači qsub: https://metavo.metacentrum.cz/pbsmon2/qsub_pbspro

Aktuální informace o migraci najdete v dokumentaci https://docs.metacentrum.cz/tutorials/debian-12/ (postup migrace zde aktualizujeme).

Vážení uživatelé,

Dovolujeme si Vás tímto pozvat k účasti na Konferenci e-INFRA CZ 2024, která se koná 29. - 30. dubna 2024 v Praze v hotelu Occindental.

Na konferenci vám představíme infrastrukturu e-INFRA CZ, její služby, mezinárodní projekty a výzkumné aktivity. Seznámíme Vás s aktuálními novinkami a nastíníme také plány MetaCentra. Druhý den konference přinese konkrétní rady a příklady užití infrastruktury.

Konference bude vedena v anglickém jazyce.

Na shledanou se těší Vaše MetaCentrum

Vážení uživatelé,

přeposíláme pozvánku na

|

|

S přáním příjemného počítání,

Připravujeme přechod na novou PBS - OpenPBS. Stávající PBSPro servery budou v budoucnu odstaveny z provozu, protože nemohou přímo komunikovat s novými OpenPBS servery a utilitami. Zároveň s migrací na novou PBS probíhá upgrade OS: Debian11 —> Debian12.

Pro testovací účely jsme připravili nové OpenPBS prostředí pbs-m1.metacentrum.cz s novým frontendem zenith běžícím na OS Debian12:

• nový frontend zenith.cerit-sc.cz (alias zenith.metacentrum.cz) s OS Debian12

• nový OpenPBS server pbs-m1.metacentrum.cz

• home /storage/brno12-cerit/

Postupně bude nové prostředí doplňováno o další clustery.

Přehled strojů s Debian12: https://metavo.metacentrum.cz/pbsmon2/props?property=os%3Ddebian12

Seznam dostupných frontendů včetně aktuálního OS: https://docs.metacentrum.cz/computing/frontends/

Přístup k nové PBS je možný také z ostatních frontendů, je však nutná aktivace modulu openpbs (module add openpbs).

Problémy s kompatibilitou některých aplikací s OS Debian12 průběžně řešíme rekompilací nových SW modulů. Pokud narazíte na problém u své aplikace, vyzkoušejte přidání modulu debian11/compat na začátek spouštěcího skriptu (module add debian11/compat). Pokud problémy přetrvávají (chybějící knihovny atd.), dejte nám vědět na meta(at)cesnet.cz.

Více informací najdete v dokumentaci https://docs.metacentrum.cz/tutorials/debian-12/ (postup migrace zde budeme upřesňovat).

Chtěli bychom Vám připomenout možnost sdílet s námi své zkušenosti s výpočetními službami velké výzkumné infrastruktury e-INFRA CZ, kterou tvoří e-infrastruktury CESNET, CERIT-SC a IT4Innovations. Prosíme o vyplnění dotazníku do 8. 3. 2024. Vaše odpovědi nám pomohou upravit naše služby tak, aby Vám lépe vyhovovaly.

Pokud jste již dotazník vyplnili, děkujeme Vám za to! Velmi si toho vážíme.

Dotazník je dostupný na adrese https://survey.e-infra.cz/compute

Matlab

Získali jsme novou akademickou licenci pro 200 instancí Matlab 9.14 a novějšího (včetně široké škály toolboxů), pokrývající výpočetní prostředí MetaCentra, CERIT-SC i IT4Innovations.

Tato nová licence má přísnější podmínky než předchozí: lze ji používat pouze z IP adres MetaCenta/IT4Innovations, tj. nelze ji použít pro Matlab spuštěný na vašem počítači/univerzitní přednáškové místnosti.

Více informací: https://docs.metacentrum.cz/software/sw-list/matlab/

Mathematica

Od letošního roku již MetaCentrum nevlastní gridovou licenci SW Mathematica pro obecné využití v MetaCentru (dodavatel nedokázal nabídnout vhodný licenční model).

V současné době jsou licence Mathematica 9 omezeny pouze na členy UK a JČU, které mají vlastní licence pro své studenty a zaměstnance. Pokud máte vlastní (institucionální) licenci SW Mathematica, kontaktujte nás pro více informací na adrese meta(at)cesnet.cz.

Více informací: https://docs.metacentrum.cz/software/sw-list/wolfram-math/

Chipster

MetaCentrum pro své uživatele nově zpřístupnila vlastní instanci nástroje Chipster, dostupného na adrese https://chipster.metacentrum.cz/.

Chipster je open-source nástroj pro analýzu genomických dat. Jeho hlavním cílem je umožnit výzkumníkům a bioinformatickým odborníkům provádět pokročilé analýzy nad genomickými daty, jako jsou sekvenční data, mikročipy a RNA-seq. Zde jsou některé klíčové rysy Chipsteru:

Více informací: https://docs.metacentrum.cz/related/chipster/

Galaxy pro uživatele MetaCentra

Galaxy je otevřená webová platforma určená pro analýzu dat FAIR, původně v biomedicínském výzkumu, ale v současné době zahrnuje mnoho vědeckých oblastí. Pro uživatele MetaCentra jsme připravili dvě prostředí Galaxy pro obecné použití:

a) usegalaxy.cz

Obecný portál https://usegalaxy.cz/, který kopíruje funkčnost (zejména sadu dostupných nástrojů) celosvětových služeb (usegalaxy.org, usegalaxy.eu) a zároveň nabízí registrovaným uživatelům MetaCentra výrazně vyšší uživatelské kvóty (výpočetní i úložné). Zde jsou některé klíčové vlastnosti:

Více informací: https://docs.metacentrum.cz/related/galaxy/

b) RepeatExplorer Galaxy

Vedle obecně využitelné Galaxy nabízíme našim uživatelům specializovanou instanci Galaxy s nástrojem Repeat Explorer. Ke službě je potřeba se registrovat.

RepeatExplorer je výkonný nástroj pro zpracování dat, který je založen na platformě Galaxy. Jeho hlavním účelem je charakterizace opakujících se sekvencí v datech získaných ze sekvenování. Klíčové vlastnosti:

Více informací: https://galaxy-elixir.cerit-sc.cz/

OnDemand

Open OnDemand https://ondemand.grid.cesnet.cz/ je služba, která uživatelům umožňuje přístup k výpočetním zdrojům přes webový prohlížeč v grafickém režimu. Uživatel může spouštět běžné úlohy PBS, získat přístup k frontend terminálům, kopírovat soubory mezi úložišti nebo spouštět několik grafických aplikací přímo v prohlížeči. Některé z funkcí:

Více nformací: https://docs.metacentrum.cz/software/ondemand/

Kubernetes/Rancher

Celá řada grafických aplikací je dostupná rovněž v Kubernetes / Rancher https://rancher.cloud.e-infra.cz/dashboard/ ve správě Centra CERIT-SC (Ansys, Remote Desktop, Matlab, RStudio, …)

Více informací: https://docs.cerit.io/

JupyterNotebooky

Jupyter Notebooks jsou prostředím „as a Service“ založeným na technologii Jupyter. Jedná se o nástroj, který je dostupný přes webový prohlížeč a umožňuje uživatelům kombinovat kód (zejména v jazyce Python), výstupy ve formátu Markdown, text, matematiku, výpočty a bohatý mediální obsah.

Uživatelé MetaCentra mohou využívat Jupyter Notebooks ve třech variantách:

a) v cloudu: Pro uživatele MetaCentra je dostupný Jupyter přes MetaCentrum Cloud Hub. Registrace není nutná, stačí se přihlásit pomocí svého Metacentrum účtu. Více informací: https://docs.metacentrum.cz/related/jupyter/

b) v Kubernetes: Jupyter lze také provozovat v Kubernetes clusteru. V tomto případě se přihlašuje také pomocí Metacentrum přihlašovacích údajů.

Více informací: https://docs.cerit.io/docs/jupyterhub.html

c) jako aplikace v OnDemand

https://ondemand.grid.cesnet.cz/

AlphaFold

AlphaFold je populární nástroj založený na umělé inteligenci, který slouží k predikci 3D struktury proteinů. Jeho revoluční přístup v oblasti biochemie a návrhu léčiv umožňuje přesněji předpovídat, jak se proteiny skládají do třídimenzionálních struktur. Opět jej nabízíme ve třech variantách:

a) Centrum CERIT-SC nabízí přístup k AlphaFold as a Service ve webovém prohlížeči (jako předpřipravený Jupyter Notebook)

Více informací: https://docs.cerit.io/docs/alphafold.html

b) v dávkových úlohách v OnDemand https://ondemand.grid.cesnet.cz/pun/sys/myjobs/workflows/new

c) v dávkových úlohách pomocí RemoteDesktop a předpřipravených kontejnerů pro Singularity

Více informací: https://docs.metacentrum.cz/software/sw-list/alphafold/

Archivní úložiště du4.cesnet.cz v MetaCentru připojené jako storage-du-cesnet.metacentrum.cz je již mimo záruku a vykazuje řadu technických problémů v mechanice páskové knihovny, což neohrožuje samotná uložená data, ale komplikuje jejich dostupnost. Kolegové z Datových úložišť CESNET připravují přesun stávajících dat na nový systém (Object Storage).

Nyní je potřeba co nejvíce utlumit provoz na tomto úložišti, prosíme proto

Pokud potřebujete zde uložená data k výpočtům, domluvte si prioritní přesun s kolegy na du-support(at)cesnet.cz

Pokud naopak zde máte uložená data, která již neplánujete používat ani stěhovat (například staré zálohy), prosíme, kontaktujte rovněž kolegy na du-support(at)cesnet.cz

Vážení uživatelé,

přeposíláme pozvánku s kurzy SVS FEM (Ansys):

|

|

SVS FEM s.r.o., Trnkova 3104/117c, 628 00 Brno

+420 543 254 554 | http://www.svsfem.cz

S přáním příjemného počítání,

Z důvodu poruchovosti a stáří jsme nedávno zrušili, nebo v dohledné době rušit plánujeme, stará disková pole Centra CERIT-SC:

• /storage/brno3-cerit/

• /storage/brno1-cerit/

Nedávno jsme zrušili diskové pole /storage/brno3-cerit/ a data z /home adresářů jsme přesunuli do /storage/brno12-cerit/home/LOGIN/brno3 (alternativně přímo do /home, pokud byl na novém úložišti prázdný).

Dočasně zůstal funkční symlink /storage/brno3-cerit/home/LOGIN/…, který vede na stejná data na novém poli. Od nynějška prosím používejte novou cestu ke stejným datům /storage/brno12-cerit/home/LOGIN/…

Všechna data z brno3 jsou již fyzicky přestěhována na nové pole! Není potřeba nic nikam kopírovat.

V blízké budoucnosti začneme stěhovat data z diskového pole /storage/brno1-cerit/ do /storage/brno12-cerit/home/LOGIN/brno1/.

Data přestěhujeme my, v době, kdy nebudou používána v úlohách.

Dočasně zůstane funkční symlink /storage/brno1-cerit/home/LOGIN/…, který povede na stejná data na novém poli. Ten bude po zrušení pole smazán a data budou dostupná jako /storage/brno12-cerit/home/LOGIN/brno1/.

POZOR na poli /storage/brno1-cerit/ jsou uložená také data z archivů starých, dávno zrušených diskových polí. Data z archivů neplánujeme přenášet automaticky! Pokud data z následujících archivů používáte, ozvěte se nám na meta@cesnet.cz, potřebná data překopírujeme rovněž do /storage/brno12-cerit/:

• /storage/brno4-cerit-hsm/

• /storage/brno7-cerit/

• /storage/jihlava1-cerit/

Jediným diskovým polem, připojeným do MetaCentra z Centra CERIT-SC, bude nadále /storage/brno12-cerit/ (storage-brno12-cerit.metacentrum.cz)

Všechna svá data najdete na diskovém poli /storage/brno12-cerit/home/LOGIN/… a symlinky na stará úložiště budou nejpozději v létě zrušeny.

S omluvou za komplikace a s přáním pěkného dne,

Vaše MetaCentrum

Vážení uživatelé,

přeposíláme pozvánku s kurzy v IT4Innovation.

|

||||||||||||

|

||||||||||||

|

S přáním příjemného počítání,

Výzkumníci z Katedry kybernetiky FAV ZČU, kteří na jaře přednášeli na Gridovém semináři MetaCentra, a se kterými jsme nedávno připravili reportáž o využívání našich služeb, získali ocenění AI Awards 2023. Gratulujeme!

Za oceněným projektem zachování historického dědictví a kulturní paměti, který spočívá ve zpřístupnění archivu historických dokumentů NKVD/KGB, stojí také naše služby, zejména Kubernetes cluster Kubus a s ním spojená disková úložiště.

Tyto výpočetní a datové zdroje k řešení velmi náročných úloh spravuje pro oblast vědy a výzkumu MetaCentrum. Více informací v tiskové zprávě ZČU.

Náš kolega Zdeněk Šustr dnes vystupuje na konferenci Copernicus forum a Inspirujme se 2023 ve Hvězdáně a planetáriu v Brně. Představí nové služby, data a plány národního uzlu Sentinel CollGS a projekt GREAT. Konference je součástí akce Czech Space Week. Je zaměřena na dálkový průzkum Země a infrastruktury INSPIRE pro sdílení prostorových dat.

Projekt GREAT je financován z prostředků Evropské unie, programu Digital Europe Programme (DIGITAL – ID: 101083927).

Vážení uživatelé,

přeposíláme pozvánku s kurzy v IT4Innovation.

|

|

|

|

|

|

|

S přáním příjemného počítání,

Vážení uživatelé,

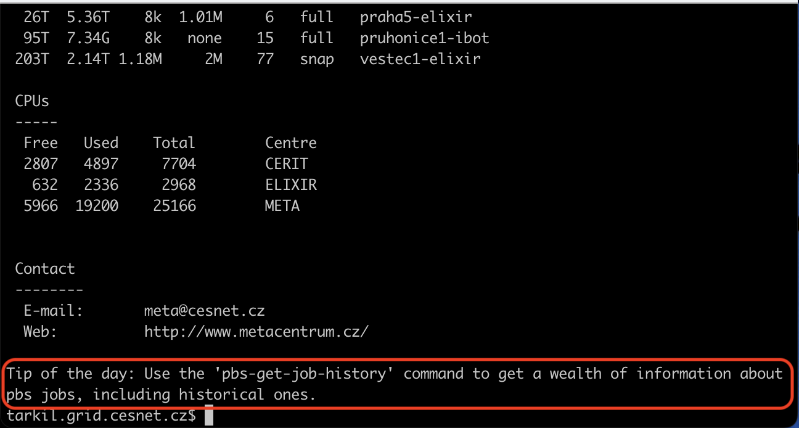

na základě zpětné vazby, kterou jsme od Vás získali v uživatelském dotazníku z přelomu roku, jsme nejčastější dotazy zpracovali do podoby Tipu dne.

Nově se Vám zobrazí na všech frontendech náhodná rada v podobě krátkého textu na konci výpisu MOTD po přihlášení na frontend.

Zobrazování tipů si můžete na vybraném frontendu deaktivovat pomocí přikazu "touch ~/.hushmotd".

S přáním příjemného počítání,

Vážení uživatelé,

s radostí oznamujeme, že jsme do MetaCentra pořídili nový velice zajímavý HW.

Více informací najdete také v tiskové zprávě e-INFRA CZ "Vědci v ČR získali nejpokročilejší systém pro AI a dva nové clustery pro náročné technické výpočty"

Masarykova univerzita (CERIT-SC) se stala průkopníkem v oblasti podpory umělé inteligence (AI) a výkonné výpočetní technologie díky instalaci nejnovějšího a nejvyspělejšího systému NVIDIA DGX H100. Jedná se o první zařízení tohoto typu v celé ČR (a Evropě), které přináší extrémní výpočetní sílu a inovativní možnosti pro výzkum.

Díky nejnovější architektuře GPU NVIDIA Hopper DGX H100 disponuje osmi pokročilými grafickými procesory NVIDIA H100 Tensor Core, každý s GPU pamětí 80 GB. Umožňuje tak paralelní zpracování obrovských datových objemů a výrazně urychluje výpočetní úlohy.

Konfigurace systému NVIDIA DGX H100 capy.cerit-sc.cz

Server DGX H100 je dodáván s předinstalovaným softwarovým balíčkem NVIDIA DGX, který obsahuje komplexní sadu softwarových nástrojů pro hluboké učení, včetně předkonfigurovaných prostředí.

Stroj je přístupný na požádání ve speciální frontě gpu_dgx@meta-pbs.metacentrum.cz.

Pro přístup žádejte na adrese meta@cesnet.cz. V žádosti popište důvody pro přidělení tohoto zdroje (potřebnost a schopnost efektivního využítí. Zároveň popište stručně očekávané výsledky, předpokládaný objem zdrojů a časový rozsah potřebného přístupu.

Kromě toho mohou uživatelé MetaCentra začít využívat dva zcela nové výpočetní clustery, které pořídíl CESNET. První byl zprovozněn v Ústavu molekulární genetiky Akademie věd ČR v Praze-Krči pod názvem TURIN a druhý na Ústavu výpočetní techniky Masarykovy univerzity v Brně pod jménem TYRA.

Pražský cluster TURIN má 52 uzlů, z nichž každý disponuje 64 jádry CPU a 512 GB RAM. Jeho brněnský kolega TYRA je tvořen 44 uzly a jinak s totožnou technickou specifikací.

Oba clustery jsou osazeny procesory AMD společně s technologií AMD 3D V-Cache. Jde o nejvýkonnější serverové procesory určené pro náročné výpočty.

Konfigurace clusterů turin.metacentrum.cz a tyra.metacentrum.cz

Kompletní seznam aktuálně dostupných výpočetních serverů je na https://metavo.metacentrum.cz/pbsmon2/hardware.

S přáním příjemného počítání,

Masarykova univerzita (CERIT-SC) se stala průkopníkem v oblasti podpory umělé inteligence (AI) a výkonné výpočetní technologie díky instalaci nejnovějšího a nejvyspělejšího systému NVIDIA DGX H100. Jedná se o první zařízení tohoto typu v celé ČR, které přináší extrémní výpočetní sílu a inovativní možnosti pro výzkum.

Díky nejnovější architektuře GPU NVIDIA Hopper DGX H100 disponuje osmi pokročilými grafickými procesory NVIDIA H100 Tensor Core, každý s GPU pamětí 80 GB o celkovém výpočetním výkonu 32 TeraFLOPS. Umožňuje tak paralelní zpracování obrovských datových objemů a výrazně urychluje výpočetní úlohy. Díky vysoce výkonným paměťovým subsystémům v grafických akcelerátorech poskytuje rychlý přístup k datům a optimalizuje výkon při práci s velkými datovými sadami. Uživatelé tak mohou dosáhnout bezkonkurenční efektivity a odezvy ve svých AI úlohách.

Server DGX H100 je dodáván s předinstalovaným softwarovým balíčkem NVIDIA DGX, který obsahuje komplexní sadu softwarových nástrojů pro hluboké učení, včetně předkonfigurovaných prostředí.

Stroj je přístupný na požádání ve speciální frontě gpu_dgx@meta-pbs.metacentrum.cz.

Pro přístup žádejte na adrese meta@cesnet.cz. V žádosti popište důvody pro přidělení tohoto zdroje (potřebnost a schopnost efektivního využít). Zároveň popište stručně očekávané výsledky, předpokládaný objem zdrojů a časový rozsah potřebného přístupu.

Konfigurace NVIDIA DGX H100 (capy.cerit-sc.cz)

Kompletní seznam aktuálně dostupných výpočetních serverů je na http://metavo.metacentrum.cz/pbsmon2/hardware.

S přáním příjemného počítání,

MetaCentrum bylo rozšířeno o nové clustery:

1) CPU cluster turin.metacentrum.cz, 52 uzlů, 3328 jader CPU, s následující specifikací každého uzlu:

2) CPU cluster tyra.metacentrum.cz, 44 uzlů, 2816 jader CPU, s následující specifikací každého uzlu:

Clustery jsou dostupné v prostředí plánovacího serveru @pbs-meta prostřednictvím standardních krátkých front. Po otestování budou přidány i delší fronty.

Kompletní seznam aktuálně dostupných výpočetních serverů je na http://metavo.metacentrum.cz/pbsmon2/hardware.

S přáním příjemného počítání,

Vážení uživatelé,

připravili jsme pro Vás novou dokumentaci MetaCentra, která je dostupná na https://docs.metacentrum.cz/ .

Obsah jsme strukturovali podle témat, která Vás zajímají, ta najdete v horní liště. Po rozkliknutí vybraného tématu se rozbalí pomocné menu vlevo s další navigací. V pravo je pak obsah s tématy obsaženými na stránce.

Do přípravy dokumentace jsme promítli i zpětnou vazbu, kterou jste nám poslali v dotazníku (děkujeme). Například jsme pročistili spoustu neaktuálních informací, které zůstávaly dohledatelné ve wiki a pokusili jsme se zpřehlednit výukové příklady.

Kvůli možnosti zpětného dohledání informací nebude původní dokumentace smazána hned, ale zůstane dočasně přístupná. Od konce března 2023 však není aktualizována!

Proč jsme zvolili jiný formát dokumentace a opustili wiki?

Jak jistě víte, probíhá integrace poskytovaných služeb do jednotné platformy e-INFRA CZ*. Součástí této integrace je sjednocení formátu všech uživatelských dokumentací. Do budoucna naši novou dokumentaci začleníme do společné dokumentace všech poskytovaných služeb v rámci aktivit e-INFRA CZ https://docs.e-infra.cz/.

-----

* e-INFRA CZ je infrastruktura pro vědu a výzkum, která spojuje a koordinuje aktivity tří českých e-infrastruktur: CESNET, CERIT-SC a IT4Innovations. Více informací naleznete na domovské stránce e-INFRA CZ https://www.e-infra.cz/.

-----

Nová dokumentace stále prochází vývojem a změnami. V případě, že narazíte na jakékoliv problémy, nejasnosti nebo Vám něco chybí, dejte nám prosím vědět na e-mailu meta@cesnet.cz . Už teď přemýšlíme, jak pro Vás ještě lépe rozpracovat část dokumentace věnované instalacím SW.

S pozdravem,

tým MetaCentra

Vážení uživatelé,

dovolujeme si přeposlat informaci o grantové soutěži v IT4I:

|

||||

|

Vážení uživatelé,

dovolujeme si Vám přeposlat pozvánku na hybridní školení Introduction to MPI:

--

Dear Madam / Sir,

The Czech National Competence Center in HPC is inviting you to a course Introduction to MPI, which will be held hybrid (online and onsite) on 30–31 May 2023.

Message Passing Interface (MPI) is a dominant programming model on clusters and distributed memory architectures. This course is focused on its basic concepts such as exchanging data by point-to-point and collective operations. Attendees will be able to immediately test and understand these constructs in hands-on sessions. After the course, attendees should be able to understand MPI applications and write their own code.

Introduction to MPI

Date: 30–31 May 2023, 9 am to 4 pm

Registration deadline: 23 May 2023

Venue: online via Zoom, onsite at IT4Innovations, Studentská 6231/1B, 708 00 Ostrava–Poruba, Czech Republic

Tutors: Ondřej Meca, Kristian Kadlubiak

Language: English

Web page: https://events.it4i.cz/event/165/

Please do not hesitate to contact us might you have any questions. Please write us at training@it4i.cz.

We are looking forward to meeting you online and onside.

Best regards,

Training Team IT4Innovations

training@it4i.cz

Vážení uživatelé,

Rádi bychom Vás pozvali na tradiční Seminář MetaCentra, který se bude konat v Praze 12. a 13. dubna 2023.

Společně s EOSC CZ jsme připravili bohatý program, který by Vás mohl zajímat.

První den akce bude věnován EOSC CZ aktivitám, především pak přípravě národní repozitářové platformy a ukládání/archivování výzkumných dat v ČR.

Druhý den pak proběhne Seminář gridového počítání 2023, který bude zaměřen na představení novinek a nových služeb, které MetaCentrum nabízí.

Mezi nimi budou například Singularity kontejnery, NVIDIA framework pro AI, Galaxy, grafická prostředí v OnDemand a Kubernetes, Jupyter Notebooky, Matlab (zvaná přednáška) a mnoho dalšího. Odpoledne se bude konat volitelný Hands-on workshop s omezenou kapacitou, kde si dozvíte mnoho zajímavého a pod vedením našich odborníků si můžete vyzkoušet témata, která Vás zajímají.

Protože chceme, aby Seminář odpovídal Vašim potřebám, budeme velmi rádi, když nám sdělíte, která témata Vás zajímají a co byste si chtěli vyzkoušet. Pokusíme se je zařadit do programu. Náměty prosím pište na meta@cesnet.cz.

Podrobnější informace a registraci najdete na stránce semináře: https://metavo.metacentrum.cz/cs/seminars/Seminar2023/index.html

Těšíme se na Vaši účast! Seminář proběhne v českém jazyce.

Vaše MetaCentrum

Vážení uživatelé,

rádi bychom vám oznámili, že od od čtvrtka 9. 3. 2023 se mění způsob výpočtu fairshare. Přidáváme nový koeficient s názvem "spec", který bere v úvahu rychlost výpočetního uzlu, na kterém běží úloha.

Dosud se "usage fairshare" počítal jako usage = used_walltime*PE , kde PE je "procesor ekvivalent" vyjadřující kolik zdrojů (ncpus, mem, scratch, gpu...) si uživatel na stroji alokoval.

Nově se bude počítat jako usage = spec*used_walltime*PE, kde "spec" značí koeficient, který vystihuje výkon hlavního uzlu (spec na jádro), na kterém běží úloha. Tento koeficient nabývá hodnot od 3 do 10.

Doufáme, že vám tato změna umožní ještě efektivnější využití našich výpočetních zdrojů. Pokud máte jakékoli dotazy, neváhejte nás kontaktovat.

Vážení uživatelé,

připravili jsme novou verzi grafického prostředí OnDemand, které je dostupné nově na https://ondemand.metacentrum.cz

Open OnDemand je služba, která uživatelům umožňuje přístup k výpočetním zdrojům přes webový prohlížeč v grafickém režimu. Uživatel může spouštět běžné úlohy PBS, získat přístup k frontend terminálům, kopírovat soubory mezi našimi úložišti nebo spouštět několik grafických aplikací v prohlížeči. Mezi nejpoužívanější dostupné aplikace patří Matlab, ANSYS, MetaCentrum Remote Desktop a VMD (viz úplný seznam GUI aplikací dostupných přes OnDemand). Grafické relace jsou trvalé, můžete k nim přistupovat z různých počítačů v různých časech nebo dokonce současně.

Přihlašovací jméno a heslo do rozhraní Open OnDemand V2 je vaše přihlašovací jméno e-INFRA CZ / Metacentrum a heslo Metacentra.

Více informací najdete v dokumentaci: https://wiki.metacentrum.cz/wiki/OnDemand

Vážení uživatelé,

dovolujeme si Vám přeposlat pozvánku na hybridní školení High Performance Data Analysis with R:

--

Dear Madam / Sir,

The Czech National Competence Center in HPC is inviting you to a course High Performance Data Analysis with R, which will be held hybrid (online and onsite) on 26–27 April 2023.

This course is focused on data analysis and modeling in R statistical programming language. The first day of the course will introduce how to approach a new dataset to understand the data and its features better. Modeling based on the modern set of packages jointly called TidyModels will be shown afterward. This set of packages strives to make the modeling in R as simple and as reproducible as possible.

The second day is focused on increasing computation efficiency by introducing Rcpp for seamless integration of C++ code into R code. A simple example of CUDA usage with Rcpp will be shown. In the afternoon, the section on parallelization of the code with future and/or MPI will be presented.

High Performance Data Analysis with R

Date: 26–27 April 2023, 9 am to 5 pm

Registration deadline: 20 April 2023

Venue: online via Zoom, onsite at IT4Innovations, Studentská 6231/1B, 708 00 Ostrava – Poruba, Czech Republic

Tutor: Tomáš Martinovič

Language: English

Web page: https://events.it4i.cz/event/163/

Please do not hesitate to contact us might you have any questions. Please write us at training@it4i.cz.

We are looking forward to meeting you online and onside.

Best regards,

Training Team IT4Innovations

training@it4i.cz

Vážení uživatelé,

Rádi bychom se dozvěděli, co si myslíte o námi poskytovaných službách.

Najděte si prosím přibližně 15 minut na vyplnění formuláře pro zpětnou vazbu a poskytněte nám tak cenné informace potřebné pro rozvoj našich služeb.

Chápeme, že Váš čas strávený nad tímto dotazníkem je cenný, a proto každý, kdo formulář vyplní a bude mít vyplněné přihlašovací údaje do e-INFRA CZ, od nás obdrží odměnu v podobě 0,5 impaktované publikace, která navýší fairshare a zvýší prioritu uživatele v prostředí PBS.

Formulář pro zpětnou vazbu (vyberte prosím libovolnou jazykovou variantu):

Děkujeme vám za Vaši zpětnou vazbu. Přejeme Vám mnoho úspěchů a publikací i v roce 2023.

S pozdravem,

Vaše MetaCentrum

Vážení uživatelé,

kvůli optimalizaci na NUMA systému serveru ursa byla zavedena fronta uv18.cerit-pbs.cerit-sc.cz, která umožňuje alokovat procesory pouze po nasobcích 18 tak, aby byl vždy využit celý NUMA node a nedocházelo k výraznému zpomalování výpočtu při zbytečné alokaci úlohy na více numa nodů.

Do fronty jsou proto přijímány pouze úlohy v násobcích 18 jader CPU a má vysokou prioritu.

S pozdravem,

Vaše MetaCentrum

Vážení uživatelé,

nově je možné při žádosti o zdroje pro výpočetní úlohu zadat minimální rychlost CPU výpočetního nodu, t.j. zajistit, aby výpočetní uzel, na kterém úloha poběží, neměl procesor pomalejší než je určitá definovaná hodnota. Tento parametr se jmenuje spec a jeho číselná hodnota vychází z metodiky https://www.spec.org/ . Více k použití parametru spec se dočtete v naší uživatelské wiki na https://wiki.metacentrum.cz/wiki/About_scheduling_system#CPU_speed.

Vyžádání strojů s rychlejším procesorem může vést ke zkrácení výpočetní doby, na druhou stranu se tím omezuje množina nodů, kterou má úloha potenciálně k dispozici, a úloha tedy může čekat déle ve frontě. Používejte proto parametr spec s rozmyslem.

S pozdravem,

Vaše MetaCentrum

Vážení uživatelé,

V rámci kontroly zabezpečení infrastruktury Metacentra jsme identifikovali

několik slabých uživatelských hesel. Aby byla zajištěna dostatečná ochrana

prostředí Metacentra, bude u příslušných uživatelů potřeba, aby provedli změnu

svého hesla na portále MetaCentra

(https://metavo.metacentrum.cz/cs/myaccount/heslo.html).

Uživatele, kterých se to týká, budeme kontaktovat přímo.

V případě dotazů se prosím obraťte na meta@cesnet.cz.

S pozdravem,

Vaše MetaCentrum

Uživatelé mohou nově přistupovat ke grafickému rozhraní aplikací proklikem přes webový prohlížeč. Návod na wiki https://wiki.metacentrum.cz/wiki/Remote_desktop#Quick_start_I_-_Run_GUI_desktop_in_a_web_browser.

Dřívější způsob přístupem přes VNC klienta je nadále možný - viz https://wiki.metacentrum.cz/wiki/Remote_desktop#Quick_start_II_-_Run_GUI_desktop_in_a_VNC_session a následující návody.

Uživatelé mohou nově získat historii svých úloh, včetně těch starších než 24 hodin, příkazem

pbs-get-job-history <job_id>

Pokud příkaz nalezne úlohu v archivu, vytvoří v aktuálním adresáři podadresář s názvem job_ID (např. 11808203.meta-pbs.metacentrum.cz), který obsahuje několik souborů. Důležité jsou zejména

job_ID.SC - kopie skriptu předaného příkazu qsub

job_ID.ER - standardní výstup úlohy (STDOUT)

job_ID.OU - standardní chybový výstup úlohy (STDERR)

Více informací je k dispozici v dokumentaci: https://wiki.metacentrum.cz/wiki/PBS_get_job_history

Na GPU kartách mohou nově uživatelé specifikovat, kolik nejméně paměti musí mít GPU karta k dispozici. K tomu slouží parametr gpu_mem. Například příkaz

qsub -q gpu -l select=1:ncpus=2:ngpus=1:mem=10gb:scratch_local=10gb:gpu_mem=10gb -l walltime=24:0:0

zařídí, aby se úloze přidělil stroj s GPU kartou, která má alespoň 10 GB paměti.

Více informací je k dispozici v dokumentaci https://wiki.metacentrum.cz/wiki/GPU_stroje

V souvislosti s tím bychom uživatele rádi upozornili, že pro specifikaci GPU karet je vhodnější používat kombinaci parametrů

gpu_mem a cuda_cap než název konkrétního klastru. Prvně uvedený způsob zahrne širší množinu strojů a tím pádem se zkrátí čekání úlohy ve frontě.

Vážení uživatelé,

dovolujeme si Vám přeposlat pozvánku na ESFRI Open Session

--

Dear All,

I am pleased to invite you to the 3rd ESFRI Open Session, with the leading theme Research Infrastructures and Big Data. The event will take place on June 30th 2022, from 13:00 until 14:30 CEST and will be fully virtual. The event will feature a short presentation from the Chair on recent ESFRI activities, followed by presentations from 6 Research infrastructures on the theme and there will also be an opportunity for discussion. The detailed agenda of the 3rd Open Session will soon be available via the event webpage.

ESFRI holds Open Sessions at its plenary meetings twice a year, to communicate to a wider audience about its activities. They are intended to serve both the ESFRI Delegates and representatives of the Research Infrastructures community, and facilitate both-ways exchange. ESFRI has launched the Open Session initiative as a part of the goals set within the ESFRI White Paper - Making Science Happen.

I would like to inform you that the Open Session will be recorded and will be at your disposal at our ESFRI YouTube channel. The recordings from the previous Open Sessions themed around the ESFRI RIs response to the COVID-19 pandemic, and the European Green Deal, are available here.

Please forward this invitation to your colleagues in the EU Research & Innovation ecosystem that you deem would benefit from the event.

Registration is mandatory for participation, and should be done via the following link:

https://us06web.zoom.us/webinar/register/WN_0-sM43ktT3mPuCzXi3KNdQ

Your attendance at the Open Session will be highly appreciated.

Sincerely,

Jana Kolar,

ESFRI Chair

Vážení uživatelé,

Dovolujeme si Vás tímto pozvat k účasti na Seminář gridového počítání - MetaCentrum 2022, který se koná 10. května 2022 v Praze v hotelu Diplomat.

Seminář je součástí konference e-infrastruktury e-INFRA CZ 2022 https://www.e-infra.cz/konference-e-infra-cz

Představíme Vám infrastrukturu e-INFRA CZ, její služby, mezinárodní projekty a výzkumné aktivity. Seznámíme vás s aktuálními novinkami a nastíníme naše plány.

V odpoledním programu vám nabídneme dvě paralelní sekce. Jedna se zaměří na rozvoj sítě, její bezpečnost a multimédia a druhá na zpracování a ukládání dat - Seminář gridového počítání MetaCentrum 2022.

V podvečer se pak zájemci mohou zúčastnit bonusové sekce Gridová služba MetaCentrum - Best Practices s následnou volnou diskuzí o tématech, která Vás zajímají a nedají Vám spát.

Více informací, program a registraci najdete na stránce akce https://metavo.metacentrum.cz/cs/seminars/seminar2022/index.html

Na shledanou se těší Vaše MetaCentrum

MetaCentrum bylo rozšířeno o nové clustery:

galdor.metacentrum.cz vlastník CESNET, 20 uzlů, 1280 jader CPU a 80 GPU kartami NVIDIA A40, s následující specifikací každého uzlu:

Cluster je dostupný v prostředí plánovacího serveru @pbs-meta prostřednictvím standardních krátkých front a prioritní fronty gpu.

Na GPU clusterech je možné využívat dockerové obrazy z NVIDIA GPU Cloud (NGC) -- nejpoužívanější prostředí pro vývoj machine learning a deep learning aplikací, HPC aplikací nebo vizualizaci akcelerovanou NVIDIA GPU kartami. Nasazení těchto aplikací je pak otázkou zkopírování odkazu na příslušný Docker obraz, jeho spuštění spuštění v Docker kontejneru v Singularity. Více informací najdete na https://wiki.metacentrum.cz/wiki/NVidia_deep_learning_frameworks

halmir.metacentrum.cz vlastník CESNET, 31 uzlů, 1984 jader CPU, s následující specifikací každého uzlu:

Cluster je dostupný v prostředí plánovacího serveru @pbs-meta prostřednictvím standardních krátkých front. Po otestování budou přidány i delší fronty.

Kompletní seznam aktuálně dostupných výpočetních serverů je na http://metavo.metacentrum.cz/pbsmon2/hardware.

Problémy s kompatibilitou některých aplikací s OS Debian11 průběžně řešíme rekompilací nových SW modulů. Pokud narazíte na problém u své aplikace, vyzkoušejte přidání modulu debian10-compat na začátek spouštěcího skriptu. Pokud problémy přetrvávají, dejte nám vědět na meta(at)cesnet.cz.

S přáním příjemného počítání,

Vážení uživatelé,

zveme Vás na webinář Představení Kubernetes jako další výpočetní platformy dostupné uživatelům MetaCentra

Záznam z webináře https://youtu.be/zUrkd5qmbAc

Dokumentace ke Kubernetes a Rancheru https://docs.cerit.io/

Vážení uživatelé,

v infrastruktuře MetaCentrum pokračujeme v přechodu na nové algoritmy používané pro autentizaci uživatelů a ověření jejich hesel.

Nové algoritmy jsou bezpečnější a přináší podporu nových zařízení a operačních systémů. Pro dokončení přechodu bude u některých uživatelů potřeba, aby provedli nové zadání svého hesla v aplikaci pro změnu hesla na portále Metacentra (https://metavo.metacentrum.cz/cs/myaccount/heslo.html).

Uživatele, kterých se to týká, budeme kontaktovat přímo.

Připomínáme, že po uživatelích nikdy nepožadujeme zasílání hesel mailem. Veškeré informace o správě hesel jsou dostupné ze stránek MetaCentra.

V případě dotazů se prosím obraťte na support@metacentrum.cz.

S pozdravem,

Vaše MetaCentrum

Vážení uživatelé,

dovolujeme si Vám přeposlat pozvánku na EGI webinář OpenRDM

--

Dear all

I'm please to announce the first webinar in the new year which is related to the current hot topic, Data Space. Register now to reserve your place!

Title: openRDM

Date and Time: Wednesday, 12th January 2022 |14:00 -15:00 PM CEST

Description: The talk will introduce OpenBIS, an Open Biology Information System, designed to facilitate robust data management for a wide variety of experiment types and research subjects. It allows tracking, annotating, and sharing of data throughout distributed research projects in different quantitative sciences.

Agenda: https://indico.egi.eu/event/5753/

Registration: us02web.zoom.us/webinar/register/WN_6xn2eqnjTI60-AtB6FKEEg

Speaker: Priyasma Bhoumik, Data Expert, ETH Zurich. Priyasma holds a PhD in Computational Sciences, from University of South Carolina, USA. She has worked as a Gates Fellow in Harvard Medical School to explore computational approaches to understanding the immune selection mechanism of HIV, for better vaccine strategy. She moved to Switzerland to join Novartis and has worked in the pharma industry in the field of data science before joining ETHZ.

If you missed any previous webinars, you can find recordings at our website: https://www.egi.eu/webinars/

Please let's know if there are any topics you are interested in, and we can arrange according to your requests.

Looking forward to seeing you on Wednesday!

Yin

----

Dr Yin Chen

Community Support Officer

EGI Foundation (Amsterdam, The Netherlands)

W: www.egi.eu | E: yin.chen@egi.eu | M: +31 (0)6 3037 3096 | Skype: yin.chen.egi | Twitter: @yinchen16

EGI: Advanced Computing for Research

The EGI Foundation is ISO 9001:2015 and ISO/IEC 20000-1:2011 certified

Od nynějška je možné používat nový typ scratche, tzv. SHM scratch. Tento scratch je určen pro úlohy, které potřebují extrémně rychlé čtení a zápis z/do souborů. SHM scratch existuje pouze v RAM, proto jsou data v něm uložená neperzistentní a zanikají s pádem nebo skončením úlohy. Více o použití SHM scratchů se dočtete na stránce https://wiki.metacentrum.cz/wiki/Scratch_storage

S přátelským pozdravem

MetaCentrum

Z důvodu obměny hardware budou úložiště /storage/brno8, resp. /storage/ostrava1 zrušena a 27. 9. 2021 budou odpojena. Data z domovských adresářů budou přesunuta do adresáře /storage/brno2/home/USERNAME/brno8. Tento přesun zajistíme. Žádáme nicméně uživatele, aby na rušených úložištích smazali data, která nechtějí zachovávat, a pomohli nám tak zkrátit proces kopírování.

S přátelským pozdravem

MetaCentrum

Připravili jsme nástroj pro prodlužování úloh, který mohou v omezené míře využít uživatelé k prodloužení svých úloh, u kterých neodhadli potřebný čas walltime.

Úlohy je možné prodloužit z příkazové řádky na libovolném frontendu příkazem

qextend <full jobID> <additional_walltime>

Příklad:

(BUSTER)melounova@skirit:~$ qextend 8152779.meta-pbs.metacentrum.cz 01:00:00 The walltime of the job 8152779.meta-pbs.metacentrum.cz has been extended. Additional walltime: 01:00:00 New walltime: 02:00:00

Jako prevence proti nadužívání nástroje (přílišná volnost v prodlužování by velmi ztížila plánování úloh) jsme nastavili následující limity:

Interval je klouzavý. Prodloužení úloh starší 30 dnů jsou „zapomenuta“ a již nezabírají Vaši kvótu.

Více informací najdete v dokumentaci https://wiki.metacentrum.cz/wiki/Prolong_walltime

S přátelským pozdravem

MetaCentrum & CERIT-SC

Dobrý den,

oznamujeme, že 15.8.2021 dojde ke zrušení clusteru hador poskytující služby Hadoop. Náhradou je virtualizované prostředí v cloudu, včetně navrhovaného postupu vytvoření jednostrojové nebo vícestrojové varianty clusteru.

Více informací: https://wiki.metacentrum.cz/wiki/Hadoop

S přátelským pozdravem

MetaCentrum

Vzhledem k narůstajícímu množství dat na našich polích jsou některé diskové operace již neúměrně dlouhé. Problémy způsobují zejména hromadné manipulace s daty (kopírování celých uživatelských adresářů, prohledávání, zálohování apod). Komplikace působí hlavně velké množství souborů, u některých uživatelů jsou to řádově i desítky miliónů.

Rádi bychom vás touto cestou požádali o kontrolu počtu souborů ve vašich domovských adresářích a jejich redukci. Aktuální stav je uvedený

Kvóta kterou plánujeme zavést bude orientačně 1-2 milióny souborů na uživatele. Věříme, ze pro drtivou většinu z vás bude naprosto dostatečná, v odůvodněných případech bude možno ji navýšit obdobně jako datovou kvótu.

Kvóty plánujeme zavádět postupně v následujících měsících. Při redukci počtu souborů využívejte prosím přistup přímo přes frontendy diskových polí, jak je uvedeno na naší wiki v sekci Práce s daty: https://wiki.metacentrum.cz/wiki/Prace_s_daty

Informace o způsobu zálohování jednotlivých polí jsou uvedeny na výše zmíněné wiki stránce Práce s daty, včetně doporučení jak nakládat s různými typy dat. I když bychom rádi zálohovali vše, není to ekonomicky či technicky vždy možné. Jakkoli jsou nehody vedoucí ke ztrátě dat řídké, rádi bychom opět zdůraznili, že ne každé pole je zálohované a je vhodné na to pamatovat při ukládání důležitých dat.

Abychom vám usnadnili orientaci v režimu záloh jednotlivých polí, nově ji zobrazujeme i v tabulce MOTD při každém přihlášení na výpočetní frontend.

Kvůli zvýšení bezpečnosti našich uživatelů jsme se rozhodli zrušit možnost zápisu cizími uživateli (ACL group a other) do kořenových domovských adresářů, ve kterých se nachází citlivé soubory typu .k5login, .profile apod, u kterých není žádoucí, aby s nimi mohl manipulovat někdo jiný než vlastník.

Proto budeme od 1.7. práva zápisu kontrolovat a strojově odebírat. Možnost zápisu do dalších podadresářů, typicky z důvodu sdílení dat v rámci skupiny, zůstává i nadále zachována.

Více informací naleznete na našich wiki stránkách v sekci Sdílení dat ve skupině:

https://wiki.metacentrum.cz/wiki/Sdileni_dat_ve_skupine

S přátelským pozdravem

MetaCentrum

V rámci zvyšování bezpečnostních standardů zavádí Metacentrum 2 novinky:

1) Nový mechanismus monitoringu uživatelských přístupů, jehož cílem je předejít zneužití odcizených přihlašovacích údajů. Nově bude lokace, ze které se uživatel přihlašuje, porovnávána s historií přístupů daného uživatele. V případě, že bude detekováno přihlášení z dosud neznámé lokace, bude uživateli zaslán informační e-mail spolu s žádostí o kontrolu, zda přihlášení skutečně provedl on.

Žádáme uživatele, aby v případě, že zjistí nesrovnalosti, postupovali podle pokynů v informačním e-mailu.

2) Změna šifrování uživatelských hesel. Během úprav bezpečnostní archiktury Metacentra bylo nutné zavést podporu pro nové šifrovací metody, které se používají během přihlašování. K dokončení procesu je nezbytné, aby si uživatelé, kterých se změny týkají, změnili heslo. Samotné heslo není nutné měnit, pouze připomínáme na nutnost používat dostatečně silná hesla.

Uživatele, kterých se změna týká, budeme o nutnosti změnit heslo v následujících týdnech informovat e-mailem. Připomínáme, že změna hesla se provádí na portále Metacentra na odkazu https://metavo.metacentrum.cz/cs/myaccount/heslo.html

S přátelským pozdravem

MetaCentrum & CERIT-SC

Vážení uživatelé,

dne 21. dubna 2021 proběhl další (desátý) ročník Semináře gridového počítání 2021, tentokráte jako součást třídenní online Konference CESNET 25 http://www.cesnet.cz/konferenceCESNET.

Prezentace z celé konference jsou zveřejněné na stránce konference

Prezentace a videozáznamy ze Semináře gridového počítání, včetně hands-on, jsou k dispozici na webu MetaCentra: https://metavo.metacentrum.cz/cs/seminars/seminar2021/index.html

S přátelským pozdravem

MetaCentrum & CERIT-SC

Vážení uživatelé,

dnes začíná Konference e-infrastruktury CESNET!

Zítra proběhne náš Seminář gridového počítání 2021!

Konference probíhá od úterý 20. 4. do čtvrtka 22. 4. Dopolední sekce začínají v 9:00 a odpolední ve 13:00.

Ke konferenci se připojte přes ZOOM.

20.4.

21.4.

22.4.

Konference také poběží také přes YouTube, odkaz najdete na webu http://www.cesnet.cz/konferenceCESNET v programu u každé sekce.

Podrobný program našeho MetaCentrového semináře: https://metavo.metacentrum.cz/cs/seminars/seminar2021/index.html. Zde budou po skončení akce zveřejněny prezentace ze semináře.

Těšíme se na viděnou!

S přátelským pozdravem

MetaCentrum & CERIT-SC

Vážení uživatelé,

Dovolujeme si Vás tímto pozvat k účasti na Seminář gridového počítání 2021.

KDY: 21. 4. 2021

KDE: online (před začátkem akce Vám přijde link, pomocí kterého se připojíte na konferenci)

PROGRAM:

V dopolední části našeho semináře zazní přednášky o novinkách v MetaCentru, CERIT-SC i IT4Innovation. Kromě toho se představí naše národní aktivity v prostředí European Open Science Cloud a zazní zkušenosti z naší spolupráce s uživatelskou komunitou ESA, konkrétně o zpracovávání a uchovávání dat z družic Sentinel.

V odpolední části Semináře gridového počítání proběhne prakticky zaměřený Hands-on seminář, který se skládá z 6 samostatných tutorialů na téma obecné rady, grafická prostředí, kontejnery, podpora AI, JupyterNotebooks, nadstavba nad MetaCloudem,...

Seminář je součástí třídenní konference e-infrastruktury CESNET 2021 https://www.cesnet.cz/akce/konferencecesnet/, která se koná 20. - 22. 4. 2021.

REGISTRACE:

Program semináře, konference a registrace na konferenci: https://metavo.metacentrum.cz/cs/seminars/seminar2021/index.html

Těšíme se na viděnou!

S přátelským pozdravem

MetaCentrum & CERIT-SC

Vážení uživatelé,

Pokud Vaše práce souvisí s výpočetní analýzou, a používáte nebo uvažujete o využití grafického portálu Galaxy, prosíme, vyplňte krátký dotazník české komunity Galaxy:

Cílem dotazníku je zmapovat zájmy českých vědeckých komunit, z nichž některé již Galaxy využívají, např. RepeatExplorer (https://repeatexplorer-elixir.cerit-sc.cz/) nebo naše vlastní instance MetaCentra (https://galaxy.metacentrum.cz/), nebo provozují vlastní instance. Chceme identifikovat zájmy a zaměřit na ně naše tréninkové a terénní úsilí.

Spolu s komunitním dotazníkem také spouštíme Galaxy-Czech mailing list na adrese

https://lists.galaxyproject.org/lists/galaxy-czech.lists.galaxyproject.org/

Je volně přístupný a bude sloužit k informování zájemců o novinkách a připravovovaných akcích napříč všemi instancemi Galaxy, podpoře komunitní diskuse a informačnímu propojení s dalšími národními nebo aktuálními komunitami Galaxy. Pokud Vás zajímá, co se děje v komunitě Galaxy, přihlaste se k odběru.

S přáním příjemného počítání,

Vážení uživatelé,

MetaCentrum bylo rozšířeno o nové clustery Přírodovědecké fakulty Uiverzity Karlovy v Praze (1328 jader CPU)

1) nový GPU stroj cha.natur.cuni.cz (lokalita Praha, vlastník UK), 1 uzel, 32 jader CPU, s následující specifikací:

2) nový cluster mor.natur.cuni.cz (lokalita Praha, vlastník UK), 4 uzly, 80 jader CPU, s následující specifikací každého uzlu:

3) nový cluster pcr.natur.cuni.cz (lokalita Praha, vlastník UK), 16 uzlů, 1024 jader CPU, s následující specifikací každého uzlu:

4) nový GPU cluster fau.natur.cuni.cz (lokalita Praha, vlastník UK), 3 uzly, 192 jader CPU, s následující specifikací každého uzlu:

Clustery jsou dostupné v prostředí plánovacího serveru @pbs-meta prostřednictvím standardních krátkých front, fronty gpu a prioritní fronty vlastníka "cucam".

Kompletní seznam aktuálně dostupných výpočetních serverů je na http://metavo.metacentrum.cz/pbsmon2/hardware.

S přáním příjemného počítání,

Vážení uživatelé,

MetaCentrum bylo rozšířeno o nový cluster:

zia.cerit-sc.cz (lokalita Brno, vlastník CERIT-SC), 5 uzlů, 640 jader CPU a GPU kartami NVIDIA A100, s následující specifikací každého uzlu:

Cluster je dostupný v prostředí plánovacího serveru @pbs-cerit prostřednictvím standardních krátkých front a prioritní fronty gpu.

Cluster je vybavený aktuálně nejvýkonnějšími grafickými akcelerátory NVIDIA A100 https://www.nvidia.com/en-us/data-center/a100/ . Na těchto grafických kartách je možné ještě více urychlit mnoho masivně paralelních úloh a vědeckých (HPC) aplikací nebo efektivněji řešit algoritmy umělé inteligence (AI).

Mezi hlavní výhody NVIDIA A100 patří specializovaná Tensor jádra pro machine learning aplikace nebo velká paměť (40 GB na každý akcelerátor). Podporuje výpočty pomocí tensor jader s různou přesností, kromě INT4, INT8, BF16, FP16, FP64 přibyl i nový formát TF32.

Na clusterech CERIT-SC je možné využívat dockerové obrazy z NVIDIA GPU Cloud (NGC) -- nejpoužívanější prostředí pro vývoj machine learning a deep learning aplikací, HPC aplikací nebo vizualizaci akcelerovanou NVIDIA GPU kartami. Nasazení těchto aplikací je pak otázkou zkopírování odkazu na příslušný Docker obraz, jeho spuštění spuštění v Docker kontejneru (v Podmanovi, alternativně v Singularity). Více informací najdete na https://wiki.metacentrum.cz/wiki/NVidia_deep_learning_frameworks

Kompletní seznam aktuálně dostupných výpočetních serverů je na http://metavo.metacentrum.cz/pbsmon2/hardware.

S přáním příjemného počítání,

Vážení uživatelé,

dovolujeme si Vám přeposlat pozvánku na LUMI ROADSHOW

--

Dear Madam/Sir,

We invite you to a new EuroHPC ivent:

LUMI ROADSHOW

The EuroHPC LUMI supercomputer, currently under deployment in Kajaani, Finland, will be one of the world’s fastest computing systems with performance over 550 PFlop/s. The LUMI supercomputer is procured jointly by the EuroHPC Joint Undertaking and the LUMI consortium. IT4Innovations is one of the LUMI consortium members.

We are organizing a special event to introduce the LUMI supercomputer and to make the first early access call for pilot testing of this World’s unique infrastructure, which is exclusive to the consortium's member states.

Part of this event will also be introducing the Czech National Competence Center in HPC. IT4Innovations joined the EuroCC project which was kicked off by the EuroHPC JU in September and is now establishing the National Competence Center for HPC in the Czech Republic. It will help share knowledge and expertise in HPC and implement supporting activities of this field focused on industry, academia, and public administration.

Register now for this event which will take place online on February 17, 2021! This event will gather the main Czech stakeholders from the HPC community together!

The event will be held in English.

Event webpage: https://events.it4i.cz/e/LUMI_Roadshow

Vážení uživatelé,

MetaCentrum bylo rozšířeno o nové clustery:

1) nový cluster kirke.meta.czu.cz (lokalita Plzeň, vlastník CESNET), 60 uzlů, 3840 jader CPU, s následující specifikací každého uzlu:

Cluster je dostupný v prostředí plánovacího serveru @pbs-meta prostřednictvím standardních front.

2) nový cluster elwe.hw.elixir-czech.cz (lokalita Praha, vlastník ELIXIR-CZ), 20 uzlů, 1280 jader CPU, s následující specifikací každého uzlu:

Cluster je dostupný v prostředí plánovacího serveru @pbs-elixir prostřednictvím speciálních front s přednostním právem přístupu pro členy národního uzlu ELIXIR-CZ

3) nový cluster eltu.hw.elixir-czech.cz (lokalita Vestec, vlastník ELIXIR-CZ), 2 uzly, 192 jader CPU, s následující specifikací každého uzlu:

Cluster je dostupný v prostředí plánovacího serveru @pbs-elixir prostřednictvím speciálních front s přednostním právem přístupu pro členy národního uzlu ELIXIR-CZ

4) nový cluster samson.ueb.cas.cz (vlastník Ústav experimentální botaniky AV ČR, Olomouc), 1 uzel, 112 jader CPU, s následující specifikací každého uzlu:

Cluster je dostupný v prostředí plánovacího serveru @pbs-cerit prostřednictvím prioritních front prio a ueb pro vlastníky clusteru a standardních front s maximální delkou 2 dny pro ostatní uživatele.

Kompletní seznam aktuálně dostupných výpočetních serverů je na http://metavo.metacentrum.cz/pbsmon2/hardware.

S přáním příjemného počítání,

Vážení uživatelé,

MetaCentrum bylo rozšířeno o nový cluster

gita.cerit-sc.cz (lokalita Brno, vlastník CERIT-SC), 14 +14 uzlů, 892 jader CP, polovina uzlů osazena GPU kartami NVIDIA 2080 TI; s následující specifikací každého uzlu:

Cluster je dostupný v prostředí plánovacího serveru @pbs-cerit prostřednictvím standardních front a prioritní fronty gpu.

Kompletní seznam aktuálně dostupných výpočetních serverů je na http://metavo.metacentrum.cz/pbsmon2/hardware.

S přáním příjemného počítání,

V MetaCentru/CERIT-SC dojde tento týden k upgrade všech PBS serverů na novou verzi.

Mezi největší změny bude patřit zapnutí notifikací o zabítí úloh, které bude rozesílat PBS bezprostředně po násilném zabití úlohy z důvodu překročení mem, cpu anebo walltime.

Nové nastavení se projeví postupně, až po restartu všech výpočetních uzlů.

Více informací najdete v dokumentaci:

https://wiki.metacentrum.cz/wiki/Pruvodce_pro_zacatecniky#Ukon.C4.8Den.C3.AD_.C3.BAlohy

https://wiki.metacentrum.cz/wiki/Beginners_guide#Job_termination

S omluvou za komplikace,

Vaše MetaCentrum

V posledních několika týdnech probíhá upgrade OS z Debian9 na Debian10 na většině frontendů a výpočetních strojů. Strojů z OS Centos se upgrade netýká.

Brzy nebude k dispozici žádný výpočetní stroj s OS Debian9, odstraňte prosím ze svých úloh požadavek os=debian9, úlohy s tímto požadavkem se spouštět nebudou.

Problémy s kompatibilitou některých aplikací s OS Debian10 průběžně řešíme rekompilací nových SW modulů. Pokud narazíte na problém u své aplikace, vyzkoušejte přidání modulu debian9-compat na začátek spouštěcího skriptu. Pokud problémy přetrvávají (chybějící knihovny atd.), dejte nám vědět na meta(at)cesnet.cz.

Seznam uzlů s OS Debian9/Debian10/Centos7 je možné zobrazit v seznamu vlastností ve webové aplikaci PBSMon:

* https://metavo.metacentrum.cz/pbsmon2/props?property=os%3Ddebian9

* https://metavo.metacentrum.cz/pbsmon2/props?property=os%3Ddebian10

* https://metavo.metacentrum.cz/pbsmon2/props?property=os%3Dcentos7

Seznam frontendů včetně aktuálního OS je k dispozici na wiki https://wiki.metacentrum.cz/wiki/Frontend

Poznámka: Některé speciální stroje dostupné ve speciálních frontách mohou mít odlišný OS, např. urga, ungu (ve frontě uv@wagap-pro) a phi (ve frontě phi@wagap-pro) běží na OS CentOS 7.

Vážení uživatelé,

vzhledem k tomu, že při rozesílání emailů informujících o změně stavu výpočetní úlohy dochází v některých případech (velké množství úloh) k problémům se spam filtry, rozhodli jsme se od nynějška rozesílat tyto emaily agregovaně za časový interval 30 minut. To se týká emailů informujících o konci nebo pádu úlohy. Emaily informující o započetí úlohy budou i nadále odesílány okamžitě.

Více informací o parametrech agregace na https://wiki.metacentrum.cz/wiki/Email_notifications

Vážení uživatelé,

dovolujeme si Vám přeposlat pozvánku na PRACE training course

--

Dear Madam/Sir,

We invite you to a new PRACE training course, organized by IT4Innovations National Supercomputing Center, with the title:

Parallel Visualization of Scientific Data using Blender

Basic information:

Date: Thu September 24, 2020, 9:30am - 4:30pm

Registration deadline: Wed September 16, 2020

Venue: IT4Innovations, Studentska 1b, Ostrava

Tutors: Petr Strakoš, Milan Jaroš, Alena Ješko (IT4Innovations)

Level: Beginners

Language: English

Main web page: https://events.prace-ri.eu/e/ParVis-09-2020

The course, an enriched rerun of a successful training from 2019, will focus on visualization of scientific data that can arise from simulations of different physical phenomena (e.g. fluid dynamics, structural analysis, etc.). To create visually pleasing outputs of such data, a path tracing rendering method will be used within the popular 3D creation suite Blender. We shall introduce two of our plug-ins we have developed: Covise Nodes and Bheappe. The first is used to extend Blender capabilities to process scientific data, while the latter integrates cluster rendering in Blender. Moreover, we shall demonstrate basics of Blender, present a data visualization example, and render a created scene on a supercomputer.

This training is a PRACE Training Centre course (PTC), co-funded by the Partnership of Advanced Computing in Europe (PRACE).

For more information and registration please visit

https://events.prace-ri.eu/e/ParVis-09-2020 or https://events.it4i.cz/e/ParVis-09-2020.

PLEASE NOTE: The organization of the course will be adapted to the current COVID-19 regulations and participants must comply with them. In case of the forced reduction of the number of participants, earlier registrations will be given priority.

We look forward to meeting you on the course.

Best regards,

Training Team IT4Innovations

training@it4i.cz

Vážený uživateli služby MetaCentrum Cloud.

Rádi bychom vás informovali ohledně nové služby nasazené v rámci služby MetaCentrum Cloud. Load Balancer as a Service je služba umožňující přes OpenStack API/GUI vytvářet a spravovat load balancery pomocí kterých lze následně zprostředkovat přístup ke službám provozovaným v rámci služby MetaCentrum Cloud.

Krátký popis služby a odkaz na dokumentaci naleznete na https://cloud.gitlab-pages.ics.muni.cz/documentation/gui/#lbaas.

S pozdravem

Tým MetaCentrum Cloud

cloud.metacentrum.cz

OpenOnDemand je služba, která uživateli umožňuje přístup k výpočetním prostředkům CERIT-SC prostřednictvím webového prohlížeče v grafickém režimu. Mezi aktuálně dostupné aplikace patří Matlab, ANSYS a VMD, další budou podle zájmu přibývat. Pro webové rozhraní Open OnDemand https://ondemand.cerit-sc.cz/ je přihlašovací jméno a heslo stejné jako pro Metacentrum.

V případě dotazů kontaktujte support@cerit-sc.cz

Více informací je k dispozici v dokumentaci https://wiki.metacentrum.cz/wiki/OnDemand

Na strojích v MetaCentru je nyní nově možné využít frameworky pro deep learning z NVIDIA GPU Cloudu. Frameworky je možné spouštět jak v Singularity (celé MetaCentrum), tak Dockeru (Podman; jen CERIT-SC).

Více informací je k dispozici v dokumentaci https://wiki.metacentrum.cz/wiki/NVidia_deep_learning_frameworks

CVMFS (CernVM filesystem) je souborový systém vyvinutý v Cernu, který umožňuje rychlé, škálovatelné a spolehlivé nasazení softwaru na distribuované výpočetní infrastruktuře. CVMFS je souborový systém jen pro čtení, v MetaCentru jej používáme pro ukládání některých SW modulů (alternativa AFS). Podobně jako svazky AFS je dostupný jako klientský software pro přístup k CVMFS repozitářům a serverových nástrojů pro vytváření nových repozitářů typu CVMFS.

Více informací je k dispozici v dokumentaci https://wiki.metacentrum.cz/wiki/CVMFS

Vážení uživatelé, dovolte nám, abychom Vás informovali o službě na podporu výzkumu a vývoje, kterou IT4Innovations poskytuje v rámci mezinárodního H2020 projektu Centrum excelence POP2. Jedná se o *Bezplatnou asistenci v oblasti optimalizace výkonu paralelních aplikací*. Služba je určena nejen pro všechny akademicko-vědecké pracovníky, ale i pracovníky firem, kteří vyvíjí nebo používají paralelní kódy a nástroje a hodí se jim odborná pomoc s jejich optimalizací pro efektivní spouštění na HPC systémech. V případě zájmu nás neváhejte kontaktovat: info@it4i.cz <mailto:info@it4i.cz>. S pozdravem, Vaše IT4Innovations

Vážení uživatelé,

dovolujeme si Vám přeposlat pozvánku na

IT4Innovations and M Computers would like to invite you to three full day NVIDIA Deep Learning Institute certified training courses to learn more about Artificial Intelligence (AI) and High Performance Computing (HPC) development for NVIDIA GPUs.

The first half day is an introduction by IT4Innovations and M Computers about the latest state of the art NVIDIA technologies. We also explain our services offered for AI and HPC, for industrial and academic users. The introduction will include a tour though IT4Innovations‘ computing center, which hosts an NVIDIA DGX-2 system and the new Barbora cluster with V100 GPUs.

The first full day training course, Fundamentals of Deep Learning for Computer Vision, is provided by IT4Innovations and gives you an introduction to AI development for NVIDIA GPUs.

Two further HPC related full day courses, Fundamentals of Accelerated Computing with CUDA C/C++ and Fundamentals of Accelerated Computing with OpenACC, are delivered as PRACE training courses through the collaboration with the Leibniz Supercomputing Centre of the Bavarian Academy of Sciences (Germany).

We are pleased to be able to offer the course Fundamentals of Deep Learning for Computer Vision to industry free of charge, for the first time. Further courses for industry may be instigated upon request.

Academic users can participate free of charge for all three courses.

Více informací naleznete na http://nvidiaacademy.it4i.cz/

Po úspěšném upgrade PBS serveru v CERIT-SC zahájíme ve středu 8. 1. upgrade ostaních PBS serverů (arien-pro a pbs.elixir-czech.cz) na novou, nekompatibilní verzi (jiná implementace Kerbera). Připravujeme proto nové PBS servery a stávající PBS servery budou, po doběhnutí úloh, odstaveny z provozu:

S omluvou za komplikace,

Vaše MetaCentrum

V MetaCentru/CERIT-SC dojde k upgrade všech PBS serverů na novou, nekompatibilní verzi (jiná implementace Kerbera). Připravujeme proto nové PBS servery a stávající PBS servery budou, po doběhnutí úloh, odstaveny z provozu:

S omluvou za komplikace,

Vaše MetaCentrum

Pro přístup do fronty 'adan' je potřeba speciální oprávnění. Pokud máte zájem stát se AI testerem, konraktujte nás na meta(at)cesnet.cz.

Jméno ADAN není náhodné, ve světě J. R. R. Tolkiena označuje v elfském jazyce „člověka“. Cluster ADAN je díky svým parametrům určen zejména pro tzv. strojové učení (machine learning), které spadá do sféry umělé inteligence.

Tip: Pokud narazíte na problém s kompatibilitou mezi jednotlivými generacemi GPU karet, je možné omezit výběr strojů s určitou generací karet pomocí parametru gpu_cap=[cuda20,cuda35,cuda61,cuda70,cuda75].

Dále byl zprovozněn frontend tilia.ibot.cas.cz (s aliasem tilia.metacentrum.cz) a diskové pole /storage/pruhonice1-ibot/home dedikovane pro skupinu ibot.

Clustery jsou dostupné prostřednictvím fronty 'ibot' (vyhrazené vlastníkům clusteru). Po otestování bude pravděpodobně zpřístupněný prostřednictvím krátkých standardních front.

Pravidla využití jsou dostupné na stránce vlastníka clusteru: https://sorbus.ibot.cas.cz/